af Juan Castro 3 år siden

216

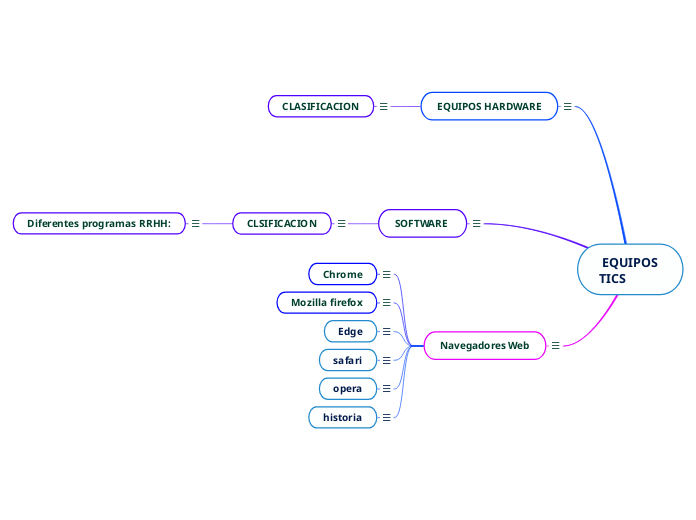

EQUIPOS TICS

af Juan Castro 3 år siden

216

Mere som dette

Definición

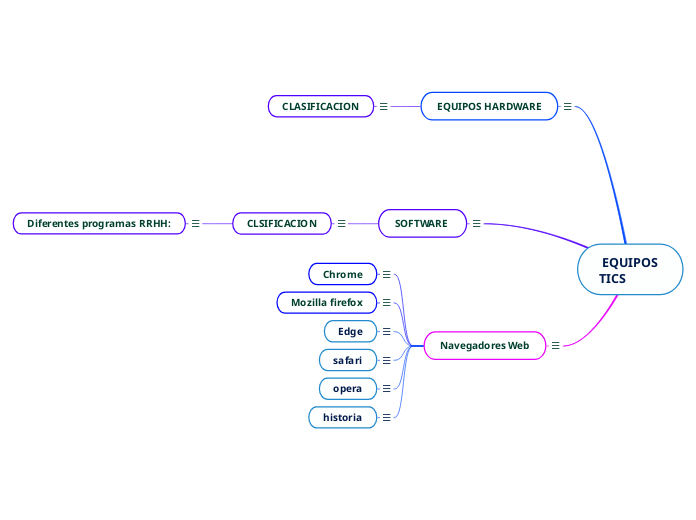

Un navegador web o browser (del inglés tobrowse = “explorar”) es un software para consultar y visualizar páginas web, documentos y datos, como imágenes o documentos PDF.

Como principal punto de acceso a Internet, un navegador puede marcar la diferencia en la experiencia de navegación. ¿Qué criterios definen al mejor navegador?

Historia[editar]

El WorldWideWeb fue el primer navegador web, desarrollado por Tim Berners-Lee, en 1990, por equipos basados en NeXT Computer.

El primer navegador fue desarrollado por Tim Berners-Lee, en la CERN, en 1990; el navegador web llamado WorldWideWeb era bastante sofisticado y gráfico, pero solo funcionaba en estaciones NexT.2

El navegador Mosaic, que funcionaba inicialmente en entornos Unix sobre XFree86 (X11), fue el primero que se extendió debido a que pronto el National Center for Supercomputing Applications (NCSA) preparó versiones para Windows y Macintosh.345

Sin embargo, Netscape Navigator al poco tiempo entró en el mercado y rápidamente superó en capacidades y velocidad al Mosaic. Este navegador tuvo la ventaja de funcionar en casi todos los sistemas Unix, y también en entornos Windows.6

Internet Explorer (anteriormente Spyglass Mosaic) fue la apuesta tardía de Microsoft para entrar en el mercado y consiguió desbancar al Netscape Navigator entre los usuarios de Windows, debido a la integración del navegador con el sistema operativo, llegando a poseer cerca del 95% de la cuota de mercado.7 Netscape Communications Corporation liberó el código fuente de su navegador, naciendo así el proyecto Mozilla.8

Finalmente Mozilla (Mozilla Application Suite) fue reescrito desde cero tras decidirse a desarrollar y usar como base un nuevo conjunto de widgets multiplataforma basado en Extensible Markup Language (XML) llamado XUL y esto hizo que tardara bastante más en aparecer de lo previsto inicialmente, apareciendo una versión 1.0 de gran calidad y para muchísimas plataformas a la vez el 5 de junio de 2002.

El 7 de enero de 2003, Apple lanzó al mercado el navegador web Safari. Este navegador se hace con casi la totalidad del mercado de las microcomputadoras Mac, debido a su velocidad y gran cantidad de actualizaciones. Asimismo, también entra al mercado del sistema operativo Windows.

A finales de 2004 aparece en el mercado Mozilla Firefox, una rama de desarrollo de Mozilla que pretende hacerse con parte del mercado de Internet Explorer.

El 2 de septiembre de 2008, Google Chrome aparece en el mercado. Es el navegador web desarrollado por Google y compilado con base en componentes de código abierto como el motor de renderizado de WebKit y su estructura de desarrollo de aplicaciones (framework). Está disponible gratuitamente bajo condiciones de servicio específicas.9 El nombre del navegador deriva del término usado para el marco de la interfaz gráfica de usuario ("chrome").10 En diciembre de 2011, Chrome superó a Internet Explorer 8.0 como el navegador más utilizado a nivel mundial.11

El 29 de julio de 2015, Microsoft lanza Microsoft Edge como sucesor de Internet Explorer. Es una versión mejorada, modernizada y distinta de Internet Explorer con una línea de desarrollo independiente. El navegador se encuentra disponible para iOS, Android 4.4+ y Windows 10 (PC, Mobile, Xbox One, HoloLens). Tiene varias funciones únicas, como lectura de libros electrónicos (en inglés, ebooks) integrada, función para agregar notas web con Windows Ink y Continuar en PC, una herramienta en la que se puede continuar la navegación web y la sincronización entre el PC y el teléfono.12 En 2020, Microsoft reconstruyó a Microsoft Edge, ahora bajo Chromium, la cual ha tenido mayor aceptación a los usuarios.113

Opera

Opera existe desde 1996 y es especialmente popular en África. Con más de 100 millones de instalaciones en todo el mundo, Opera Mini es uno de los navegadores móviles más utilizados. Además, el monopolio de los navegadores en las actuales consolas de Nintendo lo acapara Opera.

Ventajas

Ampliable con addons

Muy seguro

Buena sincronización de los dispositivos de escritorio y móviles

Desventajas

No está preinstalado, debe descargarse e instalarse

Safari

Safari es el navegador web de la compañía Apple y casi el equivalente al Internet Explorer o Edge de Microsoft. Por lo tanto, también se incluye en el paquete de software de los dispositivos portátiles de Apple con iOS.

Ventajas

Buen rendimiento y fiable para los dispositivos Apple

Muy buena protección de datos

Desventajas

No es compatible con Windows o Android

Falta seguridad ya que las actualizaciones se llevan a cabo muy poco a poco

Menos extensiones que otros navegadores

Microsoft & Edge

Desde Windows 95, Internet Explorer (IE) se convirtió en una parte integral de todos los sistemas operativos de Microsoft y, de forma temporal, fue compatible con Mac y otros sistemas derivados de Unix como Solaris. Internet Explorer se caracterizaba, principalmente, por su estrecha conexión con el sistema operativo, algo que se hacía muy evidente cuando era utilizado, por defecto, para la visualización de contenido HTML de otros programas. Como resultado de las crecientes deficiencias en seguridad y de su reputación como navegador obsoleto, los esfuerzos se concentraron en el desarrollo de Microsoft Edge, el sucesor de IE, que sería lanzado al mercado junto con Windows 10 y también funciona en Windows 7 y Windows 8.

Ventajas

Protección contra el malware y el phishing

Página de inicio personalizada

Se pueden añadir notas a los sitios web

Desventajas

Pocas extensiones y addons

Protección de datos deficiente

Mozilla Firefox

El navegador web gratuito del proyecto Mozilla aparecería en 2002 bajo el nombre de Phoenix. Su sucesor sería Mozilla Firebird y en 2004 se lanzaría la primera versión con el nombre de Firefox. Las ventajas del sucesor directo de Netscape no solo incluyen la solidez de sus estándares de seguridad, sino también una gran capacidad de expansión y compatibilidad con sistemas operativos como Windows, Linux y OS X. Firefox también está disponible como aplicación móvil para dispositivos Android e iOS.

Ventajas

Muchas extensiones

Alta protección de datos

Buena gestión de las contraseñas

Desventajas

Ocasionalmente un alto uso de recursos

Mayor riesgo de caída

Google Chrome

Con el lanzamiento de Chrome en 2008, Google establece un nuevo estándar de funcionalidad. Por un lado, ha sabido satisfacer al usuario con tiempos de carga reducidos y, por otro, ha perfeccionado la sincronización multiplataforma. Las características que hacen que Chrome destaque son:

Ventajas

Buenas opciones para la expansión de la función

Rápido y fiable

Sincronización de datos

Desventajas

Alta carga en la memoria principal cuando hay muchas pestañas abiertas

No hay buena protección de datos

Se conoce como software logicial o soporte lógico al sistema formal de un sistema informático, que comprende el conjunto de los componentes lógicos necesarios que hace posible la realización de tareas específicas, en contraposición a los componentes físicos que son llamados hardware. La interacción entre el software y el hardware hace operativo un ordenador (u otro dispositivo), es decir, el software envía instrucciones que el hardware ejecuta, haciendo posible su funcionamiento.

Los componentes lógicos incluyen, entre muchos otros, las aplicaciones informáticas, tales como el procesador de texto, que permite al usuario realizar todas las tareas concernientes a la edición de textos; el llamado software de sistema, tal como el sistema operativo, que básicamente permite al resto de los programas funcionar adecuadamente, facilitando también la interacción entre los componentes físicos y el resto de las aplicaciones, y proporcionando una interfaz con el usuario.2

El software, en su gran mayoría, está escrito en lenguajes de programación de alto nivel, ya que son más fáciles y eficientes para que los programadores los usen, porque son más cercanos al lenguaje natural respecto del lenguaje de máquina.3 Los lenguajes de alto nivel se traducen a lenguaje de máquina utilizando un compilador o un intérprete, o bien una combinación de ambos. El software también puede estar escrito en lenguaje ensamblador, que es de bajo nivel y tiene una alta correspondencia con las instrucciones de lenguaje máquina; se traduce al lenguaje de la máquina utilizando un ensamblador.

El término software fue usado por primera vez en este sentido por John W. Tukey en 1957. En la ingeniería de software y las ciencias de la computación, el software es toda la información procesada por los sistemas informáticos: programas y datos.

Clasificación del software

Si bien esta distinción es, en cierto modo arbitraria, y a veces confusa, a los fines prácticos se puede clasificar al software en tres tipos:10

· Software de sistema: Su objetivo es desvincular adecuadamente al usuario y al programador de los detalles del sistema informático en particular que se use, aislándolo especialmente del procesamiento referido a las características internas de: memoria, discos, puertos y dispositivos de comunicaciones, impresoras, pantallas, teclados, etc. El software de sistema le procura al usuario y programador adecuadas interfaces de alto nivel, controladores, herramientas y utilidades de apoyo que permiten el mantenimiento del sistema global. Incluye entre otros:

o Controladores de dispositivos

o Herramientas de corrección y optimización

· Software de programación: Es el conjunto de herramientas que permiten al programador desarrollar programas de informática, usando diferentes alternativas y lenguajes de programación, de una manera práctica. Incluyen en forma básica:

o Entornos de desarrollo integrados (IDE): Agrupan las anteriores herramientas, usualmente en un entorno visual, de forma tal que el programador no necesite introducir múltiples comandos para compilar, interpretar, depurar, etc. Habitualmente cuentan con una avanzada interfaz gráfica de usuario (GUI).

· Software de aplicación: Es aquel que permite a los usuarios llevar a cabo una o varias tareas específicas, en cualquier campo de actividad susceptible de ser automatizado o asistido, con especial énfasis en los negocios. Incluye entre muchos otros:

o Aplicaciones para Control de sistemas y automatización industrial

o Telecomunicaciones (por ejemplo Internet y toda su estructura lógica)

o Software de cálculo numérico y simbólico.

o Software de diseño asistido (CAD)

o Software de control numérico (CAM)

Hardware

El hardware (pronunciado [xard.wer]), equipo o soporte físico1 en informática se refiere a las partes físicas, tangibles, de un sistema informático, sus componentes eléctricos, electrónicos, electromecánicos.2 Los cables, así como los muebles o cajas, los periféricos de todo tipo, y cualquier otro elemento físico involucrado, componen el hardware o soporte físico; contrariamente, el soporte lógico e intangible es el llamado software.

El término es propio del idioma inglés, y su traducción al español no tiene un significado acorde, por tal motivo se lo ha adoptado tal cual es y suena. La Real Academia Española lo define como «Conjunto de los componentes que integran la parte material de una computadora».3 El término, aunque sea lo más común, no solamente se aplica a las computadoras, también es a menudo utilizado en otras áreas de la vida diaria y la tecnología. Por ejemplo, hardware también se refiere a herramientas y máquinas, y en electrónica hardware se refiere a todos los componentes electrónicos, eléctricos, electromecánicos, mecánicos, cableados y tarjetas de circuitos impresos.

Historia[editar]

Artículo principal: Historia del hardware

La clasificación evolucionista del hardware del computador electrónico está dividida en generaciones, donde cada una supone un cambio tecnológico notable. El origen de las primeras es sencillo de establecer, ya que en ellas el hardware fue sufriendo cambios radicales.6 Los componentes esenciales que constituyen la electrónica del computador fueron totalmente reemplazados en las primeras tres generaciones, originando cambios que resultaron trascendentales. En las últimas décadas es más difícil distinguir las nuevas generaciones, ya que los cambios han sido graduales y existe cierta continuidad en las tecnologías usadas. En principio, se pueden distinguir:

· 1.ª generación (1945-1956): electrónica implementada con tubos de vacío. Fueron las primeras máquinas que desplazaron los componentes electromecánicos (relés).

· 2.ª generación (1957-1963): electrónica desarrollada con transistores. La lógica discreta era muy parecida a la anterior, pero la implementación resultó mucho más pequeña, reduciendo, entre otros factores, el tamaño de un computador en notable escala.

· 3.ª generación (1964-hoy): electrónica basada en circuitos integrados. Esta tecnología permitió integrar cientos de transistores y otros componentes electrónicos en un único circuito integrado impreso en una pastilla de silicio. Las computadoras redujeron así considerablemente su costo, consumo y tamaño, incrementándose su capacidad, velocidad y fiabilidad, hasta producir máquinas como las que existen en la actualidad.

· 4.ª generación (futuro): probablemente se originará cuando los circuitos de silicio, integrados a alta escala, sean reemplazados por un nuevo tipo de material o tecnología.78

La aparición del microprocesador marca un hito de relevancia, y para muchos autores constituye el inicio de la cuarta generación.9 A diferencia de los cambios tecnológicos anteriores, su invención no supuso la desaparición radical de los computadores que no lo utilizaban. Así, aunque el microprocesador 4004 fue lanzado al mercado en 1971, todavía a comienzo de la década de 1980 había computadores, como el PDP-11/44,10 con lógica carente de microprocesador que continuaban exitosamente en el mercado; es decir, en este caso el desplazamiento ha sido muy gradual.

Otro hito tecnológico usado con frecuencia para definir el inicio de la cuarta generación es la aparición de los circuitos integrados VLSI (very large scale integration), a principios de los ochenta. Al igual que el microprocesador, no supuso el cambio inmediato y la rápida desaparición de los computadores basados en circuitos integrados en más bajas escalas de integración. Muchos equipos implementados con tecnologías VLSI y MSI (medium scale integration) aún coexistían exitosamente hasta bien entrados la década de 1990.

Clasificación del hardware

Una de las formas de clasificar el hardware es en dos categorías: por un lado, el hardware principal, que abarca el conjunto de componentes indispensables necesarios para otorgar la funcionalidad mínima a una computadora; y por otro lado, el hardware complementario, que, como su nombre indica, es el utilizado para realizar funciones específicas (más allá de las básicas), no estrictamente necesarias para el funcionamiento de la computadora.

El hardware principal está básicamente constituido por: un medio de entrada de datos, la unidad central de procesamiento, la memoria RAM, un medio de salida de datos y un medio de almacenamiento de datos.

Unidad central de procesamiento La Unidad Central de Procesamiento, conocida por las siglas en inglés CPU, es el componente fundamental de la computadora, encargado de interpretar y ejecutar instrucciones y de procesar datos.14 En computadores modernos, la función de la CPU la realiza uno o más microprocesadores. Se conoce como microprocesador a una CPU que es manufacturada como un único circuito integrado.

Placa base

La placa base, también conocida como placa madre o principal es un gran circuito impreso sobre el que se suelda el chipset, las ranuras de expansión (slots), los zócalos, conectores, diversos circuitos integrados, etc. Es el soporte fundamental que aloja y comunica a todos los demás componentes: microprocesador, módulos de memoria RAM, tarjetas gráficas, tarjetas de

expansión, periféricos de entrada y salida. Para comunicar esos componentes, la placa base posee una serie de buses mediante los cuales se transmiten los datos hacia dentro y fuera del sistema.

Memoria RAM

La sigla RAM, del inglés Random Access Memory, literalmente significa memoria de acceso aleatorio. El término tiene relación con la característica de presentar iguales tiempos de acceso a cualquiera de sus posiciones (ya sea para lectura o para escritura). Esta particularidad también se conoce como «acceso directo», en contraposición al acceso secuencial.

La RAM es la memoria utilizada en una computadora para el almacenamiento transitorio y de trabajo (no masivo). En la RAM se almacena temporalmente la información, datos y programas que la Unidad de Procesamiento (CPU) lee, procesa y ejecuta. La memoria RAM es conocida como memoria principal de la computadora, también como memoria central o de «trabajo»;15 a diferencia de las llamadas memorias auxiliares, secundarias o de almacenamiento masivo (como discos duros, unidades de estado sólido, cintas magnéticas u otras memorias).

Periféricos

Se entiende por periférico a las unidades o dispositivos que permiten a la computadora comunicarse con el exterior, esto es, tanto ingresar como exteriorizar información y datos.12 Los periféricos son los que permiten realizar las operaciones conocidas como de entrada/salida (E/S).13

Aunque son estrictamente considerados «accesorios», muchos de ellos son fundamentales para el funcionamiento y operación adecuados de la computadora moderna; por ejemplo, el teclado, el ratón, el disco duro y el monitor son elementos actualmente imprescindibles; pero no lo son, por ejemplo, un escáner o un plóter. Para ilustrar este punto: en los años 80, muchas las computadoras personales no utilizaban disco duro ni mouse (o ratón), eran normalmente operativas con sólo una o dos disqueteras, el teclado y el monitor como únicos periféricos (incluso sin disquetera).

Hardware gráficoEl hardware gráfico lo constituyen básicamente las tarjetas gráficas. Dichos componentes disponen de su propia memoria y unidad de procesamiento, esta última llamada unidad de procesamiento gráfico (o GPU, siglas en inglés de Graphics Processing Unit). El objetivo básico de la GPU es realizar los cálculos asociados a operaciones gráficas, fundamentalmente en coma flotante,18 liberando así al procesador principal (CPU) de esa costosa tarea (en tiempo) para que este pueda efectuar otras funciones en forma más eficiente. Antes de esas tarjetas de vídeo con aceleradores por hardware, era el procesador principal el encargado de construir la imagen mientras la sección de vídeo (sea tarjeta o de la placa base) era simplemente un traductor de las señales binarias a las señales requeridas por el monitor; y buena parte de la memoria principal (RAM) de la computadora también era utilizada para estos fines.