HortonWorks

quoi

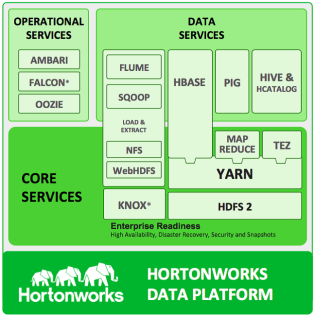

Hortonworks Data Plateform[HDP.Hortonworks est l'éditeur d'Hortonworks Data Platform (HDP), une plate-forme de données basée sur Hadoop qui comprend entre autres les systèmes Hadoop Distributed File System (HDFS), Hadoop MapReduce, Nous allons successivement utiliser dans ce tutoriel les composants HDFS, MapReduce, Hive, Pig et HCatalog.

aservices

HCatalog

Hive

Hive est un langage de requête similaire à SQL qui permet aux analystes familiarisés avec SQL d'exécuter des requêtes sur de gros volumes de données. Hive a trois fonctions principales: la synthèse des données, la requête et l'analyse. Hive fournit des outils qui facilitent l'extraction, la transformation et le chargement des données (ETL).Apache HiveLes analystes de données utilisent Hive pour explorer, structurer et analyser ces données, puis les transformer en informations commerciales. Hive implémente un dialecte SQL (HiveQL) qui se concentre sur l'analyse et présente un riche ensemble de sémantiques SQL comprenant des fonctions OLAP, des sous-requêtes, des expressions de table communes et plus encore. Hive permet aux développeurs SQL ou aux utilisateurs disposant d'outils SQL d'interroger, d'analyser et de traiter facilement les données stockées dans Hadoop. Hive permet également aux programmeurs familiarisés avec le framework MapReduce de brancher leurs mappeurs et réducteurs personnalisés pour effectuer des analyses plus sophistiquées qui peuvent ne pas être prises en charge par les capacités intégrées du langage.Les utilisateurs de Hive ont le choix entre 3 environnements d'exécution lors de l' exécution de requêtes SQL . Les utilisateurs peuvent choisir entre les frameworks Apache Hadoop MapReduce, Apache Tez ou Apache Spark comme backend d'exécution.

aHCatalog

HCatalog est un composant de Hive. Il s'agit d'une couche de gestion des tables et du stockage pour Hadoop qui permet aux utilisateurs disposant de différents outils de traitement de données, notamment Pig et MapReduce, de lire et d'écrire plus facilement des données sur la grille. HCatalog contient un ensemble de chemins de fichiers et de métadonnées sur les données d'un cluster Hadoop. Cela permet aux scripts, MapReduce et Tez, de découpler les tâches de l'emplacement des données et des métadonnées comme le schéma. De plus, étant donné que HCatalog prend également en charge des outils tels que Hive et Pig, l'emplacement et les métadonnées peuvent être partagés entre les outils. L'utilisation des API ouvertes des outils externes HCatalog qui souhaitent s'intégrer, tels que Teradata Aster, peut également utiliser l'emplacement du chemin de fichier et les métadonnées dans HCatalog.Remarque: À un moment donné, HCatalog était son propre projet Apache. Cependant, en mars 2013, le projet de HCatalog a fusionné avec Hive. HCatalog est actuellement publié dans le cadre de Hive.

aWebHCat

WebHCat fournit un service que vous pouvez utiliser pour exécuter des tâches Hadoop MapReduce (ou YARN), Pig, Hive ou pour effectuer des opérations de métadonnées Hive à l'aide d'une interface HTTP (style REST).

tez

ttmt par lot

Pig

langage de programmation de HadoopApache Pig allows Apache Hadoop users to write complex MapReduce transformations using a simple scripting language called Pig Latin. Pig translates the Pig Latin script into MapReduce so that it can be executed within YARN for access to a single dataset stored in the Hadoop Distributed File System (HDFS).

Extract-transform-load (ETL) data pipelines

langage de programmation de HadoopApache Pig allows Apache Hadoop users to write complex MapReduce transformations using a simple scripting language called Pig Latin. Pig translates the Pig Latin script into MapReduce so that it can be executed within YARN for access to a single dataset stored in the Hadoop Distributed File System (HDFS).

Research on raw data

Iterative data processing

HDFS

Une seule machine physique est saturée de sa capacité de stockage à mesure que les données augmentent. Cette croissance s'accompagne du besoin imminent de partitionner vos données sur des machines distinctes. Ce type de système de fichiers qui gère le stockage des données sur un réseau de machines est appelé un système de fichiers distribué. HDFS est un composant central d'Apache Hadoop et est conçu pour stocker des fichiers volumineux avec des modèles d'accès aux données en continu, s'exécutant sur des clusters de matériel de base. Avec Hortonworks Data Platform (HDP), HDFS est désormais étendu pour prendre en charge les supports de stockage hétérogènes au sein du cluster HDFS.

aYARN

gestion des ressources:nodescontainersmemoirefile d'attente/queuesetc.Le cluster computing est confronté à plusieurs défis, tels que:la façon de stocker les données de manière permanente et de les maintenir disponibles en cas de défaillance des nœuds comment gérer les défaillances de nœuds pendant un calcul de longue durée. Il existe également un goulot d'étranglement du réseau qui retarde le temps de traitement des données. MapReduce offre une solution en rapprochant le calcul des données, minimisant ainsi le mouvement des données. Il s'agit d'un modèle de programmation simple conçu pour traiter de gros volumes de données en parallèle en divisant le travail en un ensemble de tâches indépendantes.La plus grande limitation de la programmation MapReduce est que les tâches de mappage et de réduction ne sont pas sans état (state full). Cela signifie que les tâches de réduction doivent d'abord attendre la fin des tâches de carte. Cela limite le parallélisme maximal

pourquoi

Faciliter hadoop

qui

sandbox

comment

Accès en mode commandeL’accès en mode commande se fait via putty en mode ssh, à l’adresse 192.168.239.128.Les codes utilisateurs sont root / hadoop et hue / 1111.Accès par navigateur InternetDans votre navigateur Internet, entrez l’adresse http://192.168.239.128:8000/about/.Vous avez ainsi accès aux différents outils qui seront utilisés dans ce tutoriel.

aCLI

login

Ambari

root