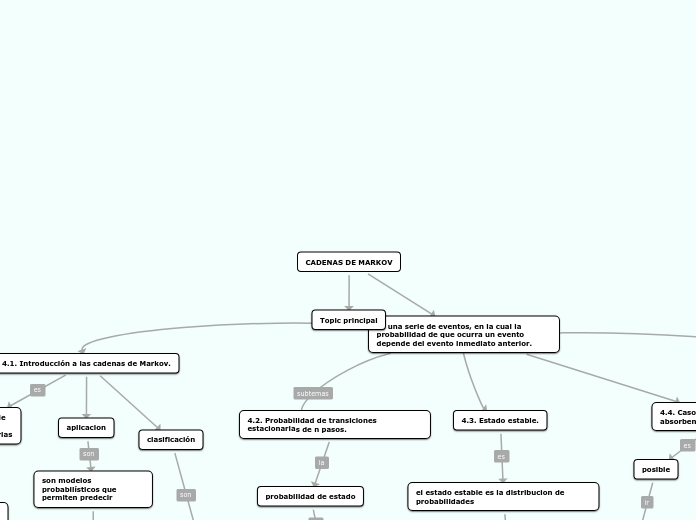

CADENAS DE MARKOV

es una serie de eventos, en la cual la probabilidad de que ocurra un evento depende del evento inmediato anterior.

4.1. Introducción a las cadenas de Markov.

la probabilidad de un sistema de variables aleatorias

evolucionan dependiendo de la variable tiempo

aplicacion

son modelos probabilísticos que permiten predecir

Subtopic

clasificación

cadena irreducibles cadenar regulables o ergódicas, cadenas absorbentes

4.2. Probabilidad de transiciones estacionarias de n pasos.

probabilidad de estado

la probabilidad de que el sistema este en cualquier estado particular

4.3. Estado estable.

el estado estable es la distribucion de probabilidades

en cierto punto quedara fija

el vector P y no presentara cambios en periodos posteriores

4.5. Uso de software

software estadístico

uso de ordenadores y calculadoras

que el alumno comprenda mejores temas complejos

paquete estadistico

un programa informativo que esta especial mente diseñado

resolver problemas

software mas utilizados en inv de operaciones

forecast, excel,stata

estos son los mas usados

4.4. Casos especiales (cadenas absorbentes, cadenas cíclicas).

estado absorbente

aquel que tiene una probabilidad de ser abandonado igual a cero

cadena de markov es absorbente si

por lo menos un estado absorbente

posible

desde cada estado no absorbente hasta por lo menos un estado absorbente