LA HISTORIA DEL COMPUTADOR

La historia del computador se refiere al desarrollo de las máquinas y tecnologías que permitieron la creación de dispositivos capaces de realizar cálculos y procesar información de manera automatizada. A lo largo de los siglos, esta evolución ha pasado por varias etapas clave.

Precursores (Antes de 1940)

Ábaco : Fue uno de los primeros instrumentos de cálculo que ayudó a realizar operaciones matemáticas simples.

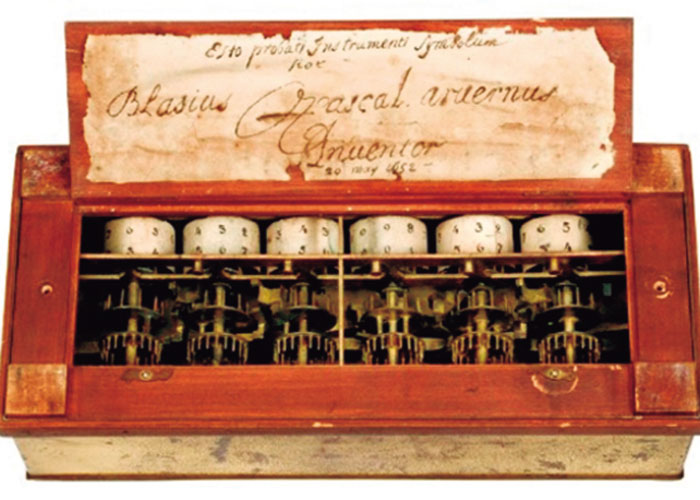

Máquina de Cálculo de Pascal (1642) : Inventada por Blaise Pascal, fue una de las primeras calculadoras mecánicas que podía sumar y restablecer números.

Analizador Diferencial de Babbage (1837) : Diseñada por Charles Babbage, fue una máquina analítica que sentó las bases para el concepto de la computadora moderna, aunque nunca se reunió.

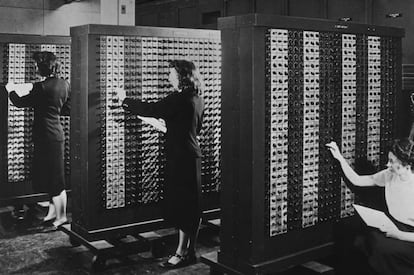

Primera Generación (1940-1956)

Computadoras de Válvulas de Vacío : Las primeras computadoras electrónicas usaban válvulas de vacío, lo que las hacía grandes y poco confiables.

ENIAC (1945) : Fue la primera computadora electrónica de propósito general, utilizada principalmente para cálculos militares.

UNIVAC (1951) : Primera computadora comercial fabricada en los EE.UU., que fue utilizada para procesar datos censales y otros finos comerciales.

Segunda Generación (1956-1963)

Transistores : Reemplazaron las válvulas de vacío, haciendo las computadoras más pequeñas, rápidas y eficientes en energía.

IBM 1401 (1959) : Fue una computadora de uso general que popularizó el uso de transistores en la industria informática.

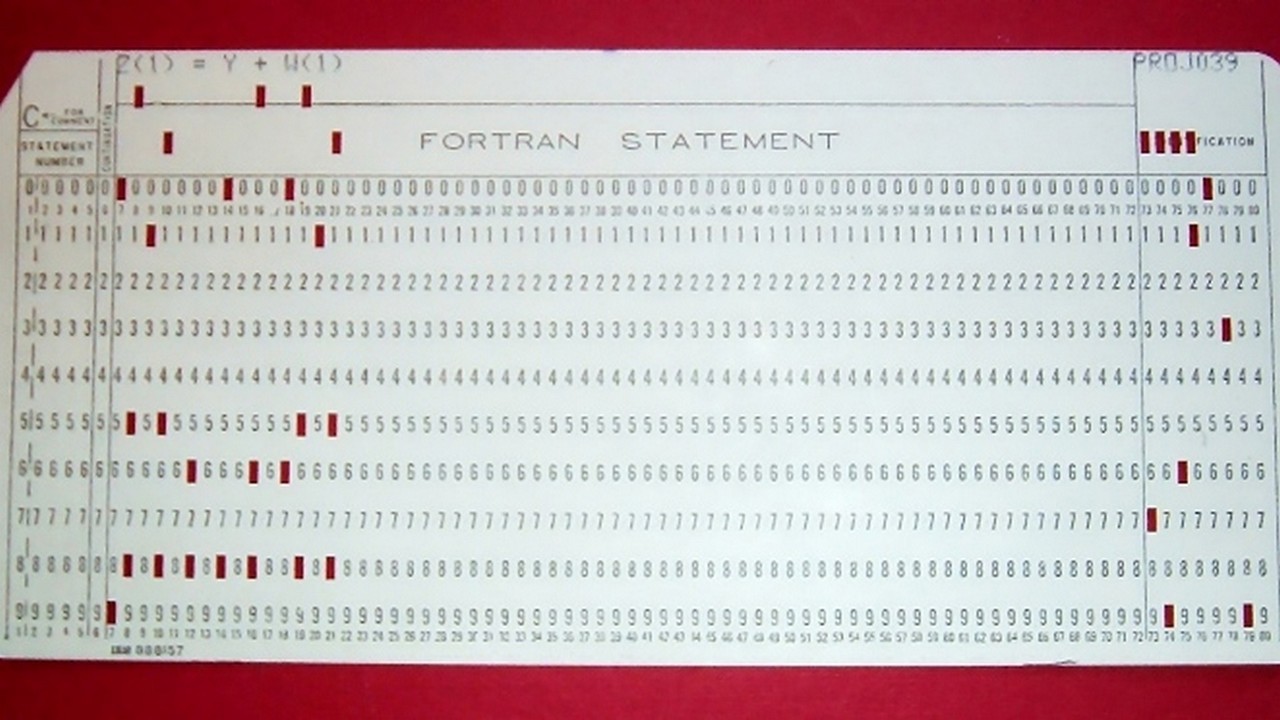

Lenguajes de Programación (FORTRAN) : Surgió el primer lenguaje de programación de alto nivel, FORTRAN (1957), orientado a cálculos científicos y de ingeniería.

Tercera Generación (1964-1971)

Circuitos Integrados : Los circuitos integrados (chips) permitieron una mayor miniaturización y potencia de procesamiento.

IBM System/360 (1964) : Introduce una arquitectura común para diferentes modelos de computadoras, facilitando el desarrollo de software compatible.

Multiprogramación : Capacidad de ejecutar múltiples programas en una computadora al mismo tiempo.

Cuarta Generación (1977-actualidad)

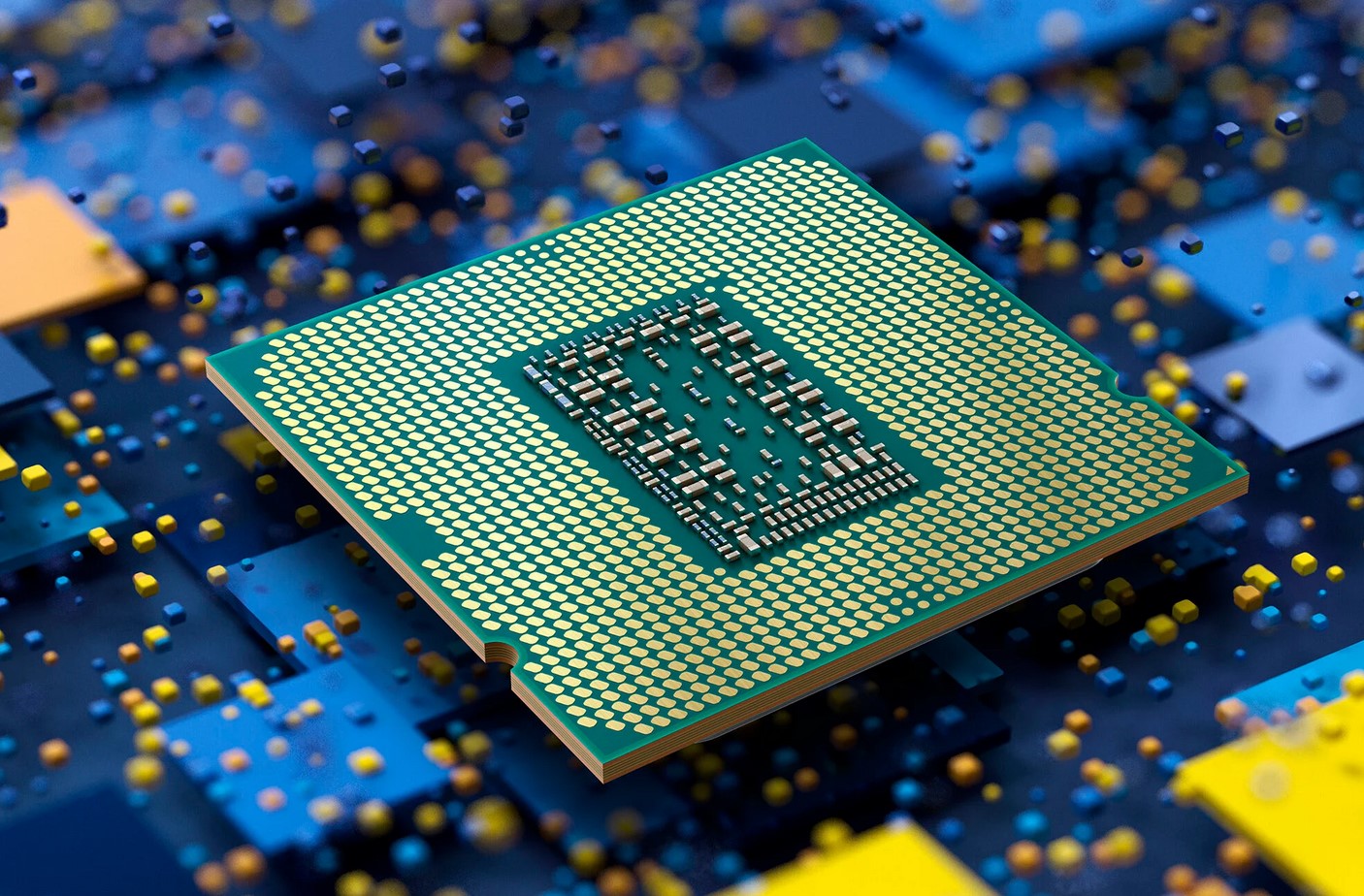

Microprocesadores : Permitieron la creación de computadoras personales (PC), haciendo la computación más accesible al público en general.

Computadoras Personales (IBM PC, 1981) : Marcó el inicio de la computación personal.

Interfaz Gráfica de Usuario (GUI) : Apple Macintosh popularizó el uso de la interfaz gráfica en 1984, facilitando la interacción con las computadoras.

Quinta Generación (1980-1990)

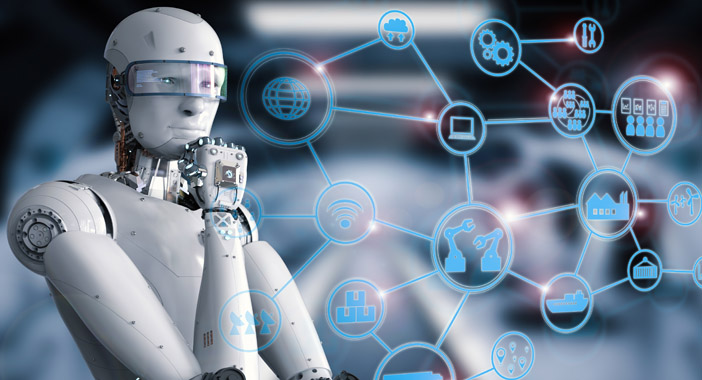

Inteligencia Artificial (IA) : Se empezaron a desarrollar sistemas capaces de aprender y realizar tareas que requieren inteligencia humana.

Computación en la Nube : Se popularizó la idea de almacenar y procesar datos en servidores remotos, accesibles a través de internet.

Dispositivos Móviles : Los teléfonos inteligentes y tablets surgieron como nuevas plataformas de computación.

Tendencias actuales

IA y Aprendizaje Automático : La inteligencia artificial sigue avanzando con algoritmos de aprendizaje automático (machine learning) y redes neuronales profundas.

Computación Cuántica : Explora el uso de qubits para realizar cálculos exponencialmente más rápidos que las computadoras clásicas.

Realidad Virtual y Aumentada : Tecnologías que permiten interactuar con entornos digitales de manera inmersiva o complementando el mundo físico con información digital.