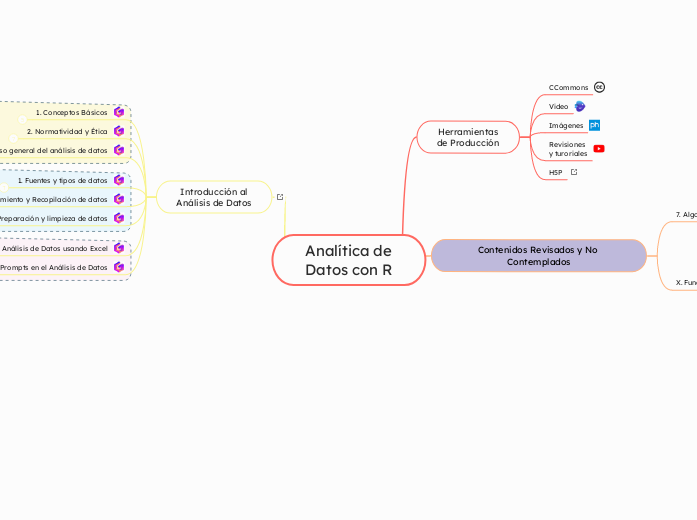

Analítica de

Datos con R

Visualización de Datos

Tendencias Futuras

Ética y privacidad en la era de los big data

Ética y privacidad en la era de los big data. Desafíos y oportunidades.

La era del Big Data ha traído consigo una revolución en la forma en que recopilamos, almacenamos y analizamos información. Sin embargo, esta revolución también plantea importantes desafíos éticos y de privacidad. En esta unidad, exploraremos los principales desafíos éticos relacionados con el Big Data, así como las oportunidades que surgen para proteger la privacidad y garantizar un uso responsable de los datos.

Conceptos Clave

- Big Data: Grandes volúmenes de datos estructurados y no estructurados que se generan a una velocidad sin precedentes.

- Privacidad: El derecho de las personas a controlar su información personal.

- Ética: Un conjunto de principios morales que guían la conducta humana.

Desafíos Éticos en la Era del Big Data

- Privacidad:Recopilación masiva de datos personales sin consentimiento.

- Uso indebido de datos personales para fines comerciales o de vigilancia.

- Dificultad para mantener la privacidad en un mundo cada vez más conectado.

- Sesgos en los datos:Perpetuación de estereotipos y discriminación a través de algoritmos sesgados.

- Toma de decisiones injustas basadas en datos incompletos o sesgados.

- Seguridad de los datos:Riesgo de filtraciones de datos y ciberataques.

- Vulnerabilidad de los sistemas de almacenamiento de datos.

- Transparencia:Falta de transparencia en los algoritmos y modelos utilizados para analizar los datos.

- Dificultad para comprender y explicar las decisiones basadas en datos.

Oportunidades para la Ética en el Big Data

- Legislación:Desarrollo de marcos legales robustos para proteger la privacidad y garantizar el uso responsable de los datos.

- Ejemplos: RGPD (Reglamento General de Protección de Datos), CCPA (California Consumer Privacy Act).

- Tecnología:Desarrollo de tecnologías de anonimización y encriptación para proteger los datos personales.

- Creación de herramientas para detectar y mitigar sesgos en los algoritmos.

- Educación:Fomentar la conciencia sobre los desafíos éticos del Big Data entre los profesionales de la tecnología y el público en general.

- Colaboración:Fomentar la colaboración entre investigadores, empresas, gobiernos y la sociedad civil para desarrollar soluciones éticas.

Principios Éticos para el Uso del Big Data

- Transparencia: Ser transparente sobre cómo se recopilan, almacenan y utilizan los datos.

- Justicia: Garantizar que los algoritmos y modelos no perpetúen sesgos o discriminaciones.

- Responsabilidad: Asumir la responsabilidad por las consecuencias de las decisiones basadas en datos.

- Privacidad: Respetar el derecho de las personas a controlar su información personal.

- Seguridad: Proteger los datos de accesos no autorizados y filtraciones.

Casos de Uso y Ejemplos

- Salud: Uso de datos genómicos para personalizar tratamientos, pero con el riesgo de discriminación.

- Marketing: Segmentación de clientes basada en datos personales, pero con el riesgo de violaciones de la privacidad.

- Gobierno: Uso de datos para mejorar la toma de decisiones políticas, pero con el riesgo de vigilancia masiva.

Realidad virtual y aumentada en la visualización

Realidad virtual y aumentada en la visualización. Nuevas formas de interactuar con los datos.

La realidad virtual (RV) y la realidad aumentada (RA) están revolucionando la forma en que interactuamos con el mundo digital. Estas tecnologías inmersivas están encontrando aplicaciones cada vez más sofisticadas en el campo de la visualización de datos, ofreciendo nuevas formas de explorar y comprender información compleja. En esta unidad, exploraremos cómo la RV y la RA están transformando la manera en que visualizamos y analizamos datos.

Conceptos Clave

- Realidad Virtual (RV): Un entorno simulado generado por computadora en el que el usuario puede interactuar.

- Realidad Aumentada (RA): La superposición de elementos digitales sobre el mundo real, creando una experiencia mixta.

- Inmersión: La sensación de estar completamente inmerso en un entorno virtual o aumentado.

- Interacción: La capacidad de manipular y explorar los datos de forma intuitiva y natural.

Aplicaciones de la RV y RA en la Visualización de Datos

- Exploración de datos en 3D: Visualización de datos espaciales, como edificios, ciudades o sistemas biológicos, en entornos 3D inmersivos.

- Análisis de grandes conjuntos de datos: Exploración de datos multidimensionales a través de interfaces intuitivas y personalizables.

- Simulaciones y modelado: Creación de simulaciones interactivas para analizar el comportamiento de sistemas complejos.

- Capacitación y entrenamiento: Desarrollo de experiencias de aprendizaje inmersivas para enseñar conceptos complejos.

- Colaboración en tiempo real: Facilitar la colaboración entre equipos distribuidos en entornos virtuales compartidos.

Beneficios de la RV y RA en la Visualización

- Mayor inmersión: La RV y la RA permiten a los usuarios sumergirse completamente en los datos, facilitando la comprensión y el análisis.

- Interacción intuitiva: Gestos, movimientos o comandos de voz permiten una interacción más natural con los datos.

- Visualización de datos complejos: La RV y la RA pueden manejar grandes volúmenes de datos y visualizaciones multidimensionales de manera efectiva.

- Mejora de la toma de decisiones: Al proporcionar una comprensión más profunda de los datos, estas tecnologías pueden mejorar la calidad de las decisiones.

Desafíos y Limitaciones

- Costo: El hardware y el software necesarios para la RV y la RA pueden ser costosos.

- Ergonomía: El uso prolongado de dispositivos de RV puede causar fatiga visual y otros problemas de salud.

- Desarrollo: La creación de experiencias inmersivas requiere habilidades de desarrollo especializadas.

- Disponibilidad de contenido: La cantidad de contenido de RV y RA para la visualización de datos aún es limitada.

Tendencias Futuras

- Integración con otras tecnologías: Combinación de la RV y la RA con inteligencia artificial, aprendizaje automático y big data.

- Aplicaciones en diferentes industrias: Expansión de las aplicaciones de la RV y la RA a nuevos sectores, como la medicina, la ingeniería y la educación.

- Dispositivos más accesibles: Desarrollo de dispositivos más asequibles y fáciles de usar.

Ejemplos de Aplicaciones

- Arquitectura: Diseño y visualización de edificios en 3D.

- Medicina: Visualización de datos médicos en 3D para diagnóstico y planificación de tratamientos.

- Ingeniería: Simulación de procesos industriales y diseño de productos.

- Educación: Creación de experiencias de aprendizaje inmersivas en ciencias, matemáticas y otras disciplinas.

Inteligencia artificial y visualización de datos

Inteligencia artificial y visualización de datos. Aprendizaje automático para generar visualizaciones.

La intersección de la inteligencia artificial (IA) y la visualización de datos está dando lugar a nuevas y emocionantes posibilidades. El aprendizaje automático, una rama de la IA, está transformando la forma en que creamos y consumimos visualizaciones. En esta unidad, exploraremos cómo la IA puede automatizar la generación de visualizaciones, permitiendo a los analistas de datos concentrarse en la interpretación y la toma de decisiones.

Conceptos Clave

- Generación automática de visualizaciones: El uso de algoritmos de aprendizaje automático para seleccionar el tipo de gráfico más adecuado, ajustar los parámetros visuales y generar visualizaciones de alta calidad de forma automática.

- Aprendizaje profundo: Un subconjunto del aprendizaje automático que utiliza redes neuronales artificiales para aprender representaciones jerárquicas de datos complejos.

- Visión por computadora: El campo de la IA que se enfoca en permitir a las computadoras interpretar y comprender el contenido visual de imágenes y videos.

Cómo Funciona la Generación Automática de Visualizaciones

- Análisis de los datos: El algoritmo de aprendizaje automático analiza los datos para identificar patrones, relaciones y distribuciones.

- Selección del tipo de gráfico: Basado en las características de los datos, el algoritmo selecciona el tipo de gráfico más adecuado (barras, líneas, dispersión, etc.).

- Optimización de los parámetros visuales: El algoritmo ajusta los parámetros visuales, como colores, tamaños y etiquetas, para maximizar la claridad y la efectividad de la visualización.

- Generación de la visualización: El algoritmo crea la visualización final, que puede ser estática o interactiva.

Beneficios de la Generación Automática de Visualizaciones

- Ahorro de tiempo: Automatiza tareas repetitivas y consume mucho tiempo, permitiendo a los analistas centrarse en tareas de mayor valor.

- Mayor precisión: Los algoritmos de aprendizaje automático pueden identificar patrones que los humanos pueden pasar por alto.

- Escalabilidad: Permite generar rápidamente una gran cantidad de visualizaciones para explorar diferentes perspectivas de los datos.

- Accesibilidad: Facilita la creación de visualizaciones para personas sin conocimientos técnicos en visualización de datos.

Desafíos y Limitaciones

- Interpretabilidad: Los modelos de aprendizaje automático pueden ser difíciles de interpretar, lo que dificulta entender cómo se tomaron las decisiones.

- Sesgos: Los algoritmos pueden perpetuar los sesgos presentes en los datos de entrenamiento.

- Creatividad: La generación automática puede limitar la creatividad y la capacidad de los humanos para contar historias con los datos.

Aplicaciones Prácticas

- Exploración de datos: Generar rápidamente una variedad de visualizaciones para identificar patrones y tendencias.

- Creación de dashboards: Automatizar la actualización de dashboards con nuevas visualizaciones.

- Visualización de datos de alta dimensionalidad: Reducir la dimensionalidad de los datos y generar visualizaciones comprensibles.

Tendencias Futuras

- Visualizaciones interactivas generadas por IA: Visualizaciones que se adaptan en tiempo real a las interacciones del usuario.

- Generación de narrativas visuales: Creación de historias a partir de los datos, utilizando la visualización como medio de expresión.

- Visualización de datos en realidad virtual y aumentada: Experiencias inmersivas para explorar datos complejos.

Ejercicios Prácticos

Visualización de datos para la toma de decisiones

Visualización de datos para la toma de decisiones. Análisis exploratorio y predictivo.

La visualización de datos es una herramienta fundamental para transformar datos en conocimiento accionable. Al permitirnos explorar y entender grandes volúmenes de información de manera visual, podemos identificar patrones, tendencias y relaciones ocultas que son cruciales para la toma de decisiones informadas. En esta unidad, exploraremos cómo la visualización de datos puede apoyar tanto el análisis exploratorio como el predictivo.

Análisis Exploratorio de Datos (EDA) a través de la Visualización

- ¿Qué es el EDA? Un proceso iterativo de descubrimiento y visualización que describe los datos, encuentra patrones y detecta anomalías.

- Objetivos del EDA:Familiarizarse con los datos.

- Descubrir patrones, tendencias y relaciones.

- Detectar valores atípicos y errores.

- Sugerir hipótesis para pruebas posteriores.

- Técnicas de visualización para EDA:Histogramas: Para entender la distribución de una variable numérica.

- Box plots: Para comparar la distribución de múltiples variables.

- Gráficos de dispersión: Para visualizar la relación entre dos variables numéricas.

- Mapas de calor: Para identificar patrones espaciales.

- Matrices de correlación: Para evaluar la relación entre múltiples variables.

Visualización para el Análisis Predictivo

- ¿Qué es el análisis predictivo? El uso de modelos estadísticos y de machine learning para predecir futuros resultados.

- Rol de la visualización en el análisis predictivo:Exploración de datos: Identificar las variables más relevantes para el modelo.

- Evaluación del modelo: Visualizar la precisión del modelo y sus errores.

- Comunicación de resultados: Presentar los resultados de manera clara y concisa a un público no técnico.

- Técnicas de visualización:Curvas ROC: Para evaluar la capacidad de clasificación de un modelo.

- Importancia de las características: Para identificar las variables más importantes en un modelo.

- Árboles de decisión: Para visualizar las reglas de decisión de un modelo.

Casos de Uso en el Mundo Real

- Negocios:Análisis de ventas: Identificar productos populares, temporadas altas y bajas, y predecir futuras ventas.

- Análisis de clientes: Segmentar a los clientes, identificar sus necesidades y personalizar las campañas de marketing.

- Salud:Epidemiología: Visualizar la propagación de enfermedades y identificar factores de riesgo.

- Análisis genómico: Visualizar datos genómicos para identificar mutaciones y desarrollar tratamientos personalizados.

- Finanzas:Análisis de mercado: Identificar tendencias del mercado, evaluar el riesgo y optimizar las carteras de inversión.

- Detección de fraudes: Visualizar patrones de transacciones inusuales para detectar posibles fraudes.

Herramientas y Tecnologías

- Tableau: Ofrece una amplia gama de visualizaciones para EDA y análisis predictivo.

- Power BI: Integración con herramientas de Microsoft y capacidades de colaboración.

- Python (Pandas, Matplotlib, Seaborn): Gran flexibilidad y personalización para crear visualizaciones personalizadas.

- R (ggplot2): Popular entre la comunidad de estadística y data science.

Ejercicios Prácticos

- EDA de un conjunto de datos de ventas: Explorar los datos para identificar patrones y tendencias.

- Crear un modelo de predicción de churn de clientes: Visualizar la importancia de las características y evaluar la precisión del modelo.

- Analizar datos de sensores para detectar anomalías.

- Visualizar datos geográficos para identificar patrones espaciales.

Visualización de datos en tiempo real

Visualización de datos en tiempo real. Dashboards interactivos.

La visualización de datos en tiempo real ha revolucionado la forma en que las organizaciones toman decisiones. Los dashboards interactivos son herramientas poderosas que permiten monitorear y analizar datos a medida que se generan, proporcionando una visión en tiempo real de las operaciones y tendencias. En esta unidad, exploraremos los conceptos clave, las herramientas y las aplicaciones de los dashboards interactivos.

Conceptos Clave

- Datos en tiempo real: Datos que se recolectan y se actualizan continuamente.

- Dashboard: Una interfaz visual que presenta datos clave de manera concisa y fácil de entender.

- Interactividad: La capacidad de los usuarios de explorar los datos de diferentes maneras, filtrando, seleccionando y comparando.

Componentes de un Dashboard Interactivo

- Fuentes de datos: Bases de datos, API, sensores, hojas de cálculo.

- Visualizaciones: Gráficos, tablas, mapas, indicadores clave de rendimiento (KPIs).

- Filtros: Permiten a los usuarios segmentar los datos y enfocarse en áreas específicas.

- Slicers: Controladores que permiten seleccionar diferentes valores de una dimensión.

- Actualizaciones en tiempo real: Mecanismos para actualizar los datos de forma automática.

Beneficios de los Dashboards Interactivos

- Toma de decisiones más rápida: Al proporcionar información actualizada, los dashboards permiten tomar decisiones oportunas.

- Mayor visibilidad: Los dashboards ofrecen una visión global de las operaciones y facilitan la identificación de tendencias y patrones.

- Colaboración mejorada: Los dashboards pueden ser compartidos con equipos multidisciplinarios, facilitando la colaboración.

- Mejora de la eficiencia: Los dashboards automatizan la recopilación y presentación de datos, liberando tiempo para el análisis.

Herramientas para Crear Dashboards Interactivos

- Tableau: Ofrece una amplia gama de visualizaciones y capacidades de interacción.

- Power BI: Integración profunda con el ecosistema de Microsoft y excelentes capacidades de colaboración.

- Google Data Studio: Opción gratuita y fácil de usar para crear dashboards a partir de diferentes fuentes de datos.

- Python (Plotly, Dash): Gran flexibilidad y personalización para crear dashboards personalizados.

Casos de Uso

- Negocios: Monitoreo de ventas, análisis de marketing, seguimiento de inventarios.

- Operaciones: Monitoreo de la producción, gestión de la cadena de suministro, mantenimiento predictivo.

- Salud: Seguimiento de pacientes, análisis de datos clínicos, gestión de recursos hospitalarios.

- Finanzas: Análisis de mercado, gestión de riesgos, seguimiento de inversiones.

Desafíos y Consideraciones

- Calidad de los datos: La calidad de los datos es fundamental para la efectividad de un dashboard.

- Diseño: Un diseño claro y conciso es esencial para garantizar que los usuarios puedan interpretar fácilmente la información.

- Performance: Los dashboards deben ser rápidos y responsivos, especialmente cuando se trata de grandes volúmenes de datos.

- Seguridad: Es necesario proteger los datos confidenciales y garantizar el acceso autorizado a los dashboards.

Proyectos Prácticos

- Crear un dashboard para monitorear el tráfico web de un sitio web.

- Desarrollar un dashboard para visualizar los datos de sensores de una planta de producción.

- Construir un dashboard interactivo para analizar las tendencias del mercado de criptomonedas.

Visualización de datos espaciales

Visualización de datos espaciales. Mapas y geovisualización.

La visualización de datos espaciales, o geovisualización, es una rama de la visualización de información que se enfoca en representar datos geográficos en mapas y otros formatos visuales. Esta técnica es fundamental para entender patrones espaciales, relaciones geográficas y tendencias en una amplia variedad de campos, desde la geografía y la urbanística hasta el marketing y la epidemiología.

Fundamentos de la Geovisualización

- Datos geográficos: Tipos de datos geográficos (puntos, líneas, polígonos), sistemas de coordenadas y proyecciones cartográficas.

- Mapas temáticos: Cómo utilizar mapas para visualizar diferentes tipos de datos (densidad, distribución, cambios a lo largo del tiempo).

- Simbología: Selección de símbolos adecuados para representar diferentes tipos de datos.

- Color: El uso efectivo del color para resaltar patrones y diferencias.

Herramientas para la Geovisualización

- Software de Sistemas de Información Geográfica (SIG): ArcGIS, QGIS, MapInfo.

- Bibliotecas de programación: Python (GeoPandas, Folium), R (sf, leaflet).

- Herramientas en línea: Google Maps, Mapbox, Carto.

Tipos de Visualizaciones Espaciales

- Mapas de calor: Representan la densidad de los datos en un área determinada.

- Coropletas: Utilizan colores para mostrar variaciones en una variable numérica dentro de regiones.

- Mapas de puntos: Visualizan la ubicación de puntos individuales.

- Mapas de líneas: Representan conexiones entre diferentes ubicaciones.

- Mapas de flujo: Muestran el movimiento de personas, bienes o información entre diferentes lugares.

Aplicaciones de la Geovisualización

- Urbanismo: Planificación urbana, análisis del tráfico, identificación de zonas de riesgo.

- Medio ambiente: Monitoreo de la calidad del aire y del agua, análisis de patrones climáticos, seguimiento de la deforestación.

- Marketing: Análisis de la ubicación de los clientes, segmentación de mercados, evaluación de campañas publicitarias.

- Epidemiología: Seguimiento de la propagación de enfermedades, identificación de brotes, evaluación de la eficacia de las intervenciones.

Ejercicios Prácticos

- Crear un mapa de calor: Utilizar datos de densidad de población para crear un mapa de calor de una ciudad.

- Visualizar patrones de movilidad: Analizar datos de GPS para visualizar los patrones de movimiento de una población.

- Comparar múltiples variables: Crear un mapa que compare diferentes variables, como el ingreso per cápita y la tasa de desempleo.

- Crear una historia interactiva: Utilizar una herramienta de visualización interactiva para crear una historia que explore un tema geográfico.

Consideraciones Éticas

- Privacidad: Proteger la privacidad de los datos geográficos, especialmente cuando se trata de datos personales.

- Sesgos: Ser consciente de los posibles sesgos en los datos y en las visualizaciones.

- Interpretación: Evitar sacar conclusiones apresuradas y asegurarse de que la visualización se interpreta correctamente.

Proyectos Reales

- Análisis de la distribución de delitos en una ciudad.

- Evaluación del impacto de un desastre natural.

- Identificación de patrones de migración.

- Análisis de la distribución de especies en peligro de extinción.

Proyectos individuales o en equipo

Proyectos individuales o en equipo. Desarrollo de visualizaciones para resolver problemas del mundo real.

La visualización de datos no solo es una habilidad técnica, sino también una herramienta poderosa para resolver problemas reales y comunicar hallazgos de manera efectiva. En esta unidad, exploraremos cómo aplicar los conocimientos adquiridos en proyectos prácticos, tanto individuales como en equipo, para abordar desafíos del mundo real a través de la visualización de datos.

Fases de un Proyecto de Visualización

- Definición del problema:Identificar claramente la pregunta que se quiere responder con la visualización.

- Definir el público objetivo y sus necesidades.

- Recopilación y preparación de datos:Obtener los datos relevantes de fuentes confiables.

- Limpiar y transformar los datos para que sean adecuados para la visualización.

- Selección de la herramienta adecuada:Elegir la herramienta que mejor se adapte al tipo de datos y a la complejidad de la visualización.

- Diseño de la visualización:Seleccionar los tipos de gráficos más adecuados para comunicar los hallazgos.

- Considerar la estética y la facilidad de comprensión.

- Desarrollo de la visualización:Utilizar la herramienta seleccionada para crear la visualización.

- Iterar y refinar el diseño hasta obtener los resultados deseados.

- Comunicación de los resultados:Presentar la visualización de manera clara y concisa.

- Interpretar los hallazgos y responder a preguntas.

Proyectos Prácticos

- Proyectos individuales:Análisis de datos personales: Visualizar hábitos de gasto, patrones de sueño o actividad física.

- Exploración de datos públicos: Analizar datos de conjuntos de datos abiertos como los de gobiernos o organizaciones sin fines de lucro.

- Visualización de datos de redes sociales: Analizar la interacción en redes sociales, la influencia de los influencers o la evolución de las tendencias.

- Proyectos en equipo:Análisis de datos empresariales: Desarrollar dashboards para monitorear el desempeño de la empresa.

- Investigación académica: Visualizar resultados de experimentos o estudios.

- Proyectos de ciencia ciudadana: Participar en proyectos de ciencia ciudadana y contribuir con visualizaciones de datos.

Ejemplos de Problemas Reales a Resolver con Visualizaciones

- Salud: Visualizar la propagación de enfermedades, analizar los factores de riesgo y evaluar la eficacia de las intervenciones.

- Medio ambiente: Monitorear el cambio climático, analizar la calidad del aire y del agua, y visualizar patrones de consumo de energía.

- Economía: Analizar tendencias del mercado, predecir el comportamiento de los consumidores y evaluar el impacto de las políticas económicas.

- Deportes: Visualizar el desempeño de los atletas, analizar estadísticas de equipos y crear visualizaciones interactivas para los fanáticos.

Herramientas y Recursos

- Tableau Public: Plataforma gratuita para crear y compartir visualizaciones públicas.

- Google Data Studio: Herramienta gratuita para crear dashboards a partir de diferentes fuentes de datos.

- Kaggle: Plataforma para encontrar conjuntos de datos y participar en competiciones de ciencia de datos.

- GitHub: Repositorio de código abierto con numerosos ejemplos y proyectos de visualización de datos.

Consideraciones Éticas

- Privacidad: Asegurarse de proteger la privacidad de los datos personales.

- Sesgos: Ser consciente de los posibles sesgos en los datos y en las visualizaciones.

- Interpretación: Evitar sacar conclusiones apresuradas y asegurarse de que la visualización se interpreta correctamente.

Análisis de casos reales

Análisis de casos reales. Interpretación de visualizaciones existentes.

La visualización de datos es una herramienta poderosa para comunicar información compleja de manera sencilla y efectiva. Sin embargo, la interpretación correcta de una visualización requiere un análisis cuidadoso y una comprensión profunda de los datos y las técnicas de visualización utilizadas. En esta unidad, exploraremos varios casos reales de visualizaciones, analizando sus fortalezas, debilidades y las lecciones que podemos aprender de ellas.

¿Por qué es importante interpretar visualizaciones?

- Evitar conclusiones erróneas: Una interpretación incorrecta puede llevar a decisiones equivocadas.

- Identificar sesgos: Las visualizaciones pueden ser manipuladas para mostrar una determinada perspectiva.

- Apreciar la eficacia: Analizar visualizaciones exitosas puede inspirar nuevas ideas.

Elementos clave para interpretar una visualización

- Tipo de gráfico: Cada tipo de gráfico (barras, líneas, dispersión, etc.) está diseñado para mostrar diferentes tipos de relaciones entre los datos.

- Ejes: Los ejes deben estar claramente etiquetados y la escala debe ser apropiada.

- Colores: Los colores se utilizan para resaltar patrones y diferencias, pero un uso excesivo o inapropiado puede confundir.

- Leyendas: Las leyendas son esenciales para entender los diferentes elementos de la visualización.

- Contexto: El contexto en el que se presenta la visualización es crucial para su interpretación.

Casos de estudio

- Visualizaciones engañosas:Ejes truncados: Cómo los ejes pueden manipular la percepción de las diferencias.

- Colores engañosos: El uso de colores para enfatizar o minimizar ciertas tendencias.

- Gráficos 3D: Los desafíos de interpretar gráficos 3D y cómo pueden distorsionar los datos.

- Visualizaciones exitosas:The New York Times: Análisis de sus visualizaciones interactivas sobre temas como el cambio climático y las elecciones.

- Gapminder: Cómo Hans Rosling utilizó visualizaciones para desafiar los estereotipos y mostrar el progreso global.

- Florence Nightingale: Su innovadora visualización de datos para mejorar las condiciones sanitarias en los hospitales.

- Casos de uso en diferentes industrias:Marketing: Cómo las empresas utilizan visualizaciones para medir el rendimiento de sus campañas.

- Finanzas: Visualizaciones para analizar tendencias del mercado y tomar decisiones de inversión.

- Salud: Visualizaciones para estudiar la propagación de enfermedades y evaluar la eficacia de tratamientos.

Ejercicios prácticos

- Análisis de visualizaciones de noticias: Seleccionar una noticia con una visualización y analizarla en detalle.

- Creación de una visualización alternativa: Tomar una visualización existente y crear una versión alternativa que sea más clara y efectiva.

- Detección de sesgos en visualizaciones: Identificar ejemplos de sesgos en visualizaciones de los medios de comunicación.

Lecciones aprendidas

- La importancia del contexto: El contexto en el que se presenta una visualización es crucial para su interpretación.

- La necesidad de ser crítico: No todas las visualizaciones son lo que parecen.

- El poder de la visualización para contar historias: Las visualizaciones pueden comunicar información compleja de manera efectiva y atractiva.

Ejercicios guiados con

herramientas de visualización

Ejercicios guiados con herramientas de visualización. Creación de gráficos sencillos y complejos.

La mejor manera de aprender a utilizar una herramienta de visualización de datos es a través de la práctica. En esta unidad, te proporcionaremos una serie de ejercicios guiados que te permitirán aplicar los conceptos aprendidos y crear gráficos sencillos y complejos utilizando diferentes herramientas.

Ejercicios Guiados con Tableau

- Ejercicio 1: Gráfico de barras simpleCarga un conjunto de datos de ventas mensuales.

- Crea un gráfico de barras que muestre las ventas por producto.

- Personaliza el gráfico con colores, etiquetas y un título descriptivo.

- Ejercicio 2: Dashboard interactivoCrea un dashboard que muestre las ventas por región y por categoría de producto.

- Utiliza filtros para permitir a los usuarios explorar los datos de manera interactiva.

- Agrega un gráfico de líneas para mostrar la tendencia de ventas a lo largo del tiempo.

Ejercicios Guiados con Power BI

- Ejercicio 1: Mapa de calorCarga un conjunto de datos geográficos (por ejemplo, ventas por ciudad).

- Crea un mapa de calor para visualizar las ventas en diferentes regiones.

- Personaliza el mapa con diferentes colores y niveles de detalle.

- Ejercicio 2: Informe interactivoCrea un informe interactivo que incluya un gráfico de barras, un gráfico circular y una tabla.

- Utiliza paginas para organizar diferentes secciones del informe.

- Agrega filtros y slicers para permitir a los usuarios explorar los datos.

Ejercicios Guiados con Python (Matplotlib y Seaborn)

- Ejercicio 1: Gráfico de dispersiónGenera datos aleatorios para dos variables.

- Crea un gráfico de dispersión para visualizar la relación entre las dos variables.

- Personaliza el gráfico con títulos, etiquetas y una línea de tendencia.

- Ejercicio 2: HistogramaCarga un conjunto de datos numéricos (por ejemplo, edades).

- Crea un histograma para visualizar la distribución de los datos.

- Experimenta con diferentes números de bins y densidades.

Ejercicios Guiados con R (ggplot2)

- Ejercicio 1: Gráfico de líneas múltiplesCarga un conjunto de datos de series temporales.

- Crea un gráfico de líneas múltiples para comparar diferentes series.

- Personaliza el gráfico con colores, leyendas y títulos.

- Ejercicio 2: FacetingCarga un conjunto de datos con múltiples variables categóricas.

- Crea un gráfico facet para visualizar los datos en función de estas variables.

- Experimenta con diferentes tipos de faceting (wrap, grid).

Ejercicios Adicionales y Desafíos

- Creación de infografías: Utiliza herramientas como Canva o Piktochart para crear infografías atractivas y fáciles de entender.

- Visualización de datos geográficos: Utiliza herramientas como Leaflet o Mapbox para crear mapas interactivos.

- Análisis exploratorio de datos: Utiliza herramientas de visualización para descubrir patrones y tendencias en tus datos.

- Creación de dashboards para seguimiento de KPIs: Diseña dashboards personalizados para monitorear el desempeño de tu negocio.

Recursos Adicionales

- Tutoriales en línea: Plataformas como Coursera, Udemy y YouTube ofrecen una amplia variedad de tutoriales gratuitos y de pago.

- Comunidades en línea: Foros y grupos de usuarios en plataformas como Stack Overflow y Reddit son excelentes lugares para hacer preguntas y obtener ayuda.

- Documentación oficial: Consulta la documentación oficial de las herramientas que estás utilizando para obtener información detallada sobre las funciones y características.

Herramientas y Software

Consideraciones al elegir una herramienta

Consideraciones al elegir una herramienta. Facilidad de uso, funcionalidades, costo.

La elección de una herramienta de visualización de datos puede ser una tarea desafiante, dada la amplia variedad de opciones disponibles en el mercado. Cada herramienta ofrece un conjunto único de características y funcionalidades, diseñadas para satisfacer diferentes necesidades y niveles de experiencia. En esta unidad, exploraremos las principales consideraciones que debes tener en cuenta al seleccionar la herramienta adecuada para tu proyecto.

Facilidad de Uso

- Interfaz intuitiva: Busca herramientas con una interfaz de usuario clara y fácil de navegar, que te permita crear visualizaciones sin necesidad de conocimientos técnicos avanzados.

- Arrastrar y soltar: La capacidad de crear visualizaciones simplemente arrastrando y soltando elementos es una característica muy valiosa para usuarios sin experiencia en programación.

- Curva de aprendizaje: Evalúa la facilidad con la que puedes aprender a utilizar la herramienta. Una curva de aprendizaje suave te permitirá ser productivo rápidamente.

Funcionalidades

- Tipos de gráficos: Asegúrate de que la herramienta ofrezca los tipos de gráficos que necesitas para representar tus datos (barras, líneas, dispersión, mapas, etc.).

- Conectividad de datos: Verifica si la herramienta puede conectarse a las fuentes de datos que utilizas (bases de datos, hojas de cálculo, archivos CSV, etc.).

- Personalización: Evalúa la capacidad de personalizar los gráficos en términos de colores, estilos, etiquetas y otros elementos visuales.

- Interactividad: Si necesitas crear dashboards interactivos, busca herramientas que permitan a los usuarios explorar los datos de forma dinámica.

- Análisis avanzado: Algunas herramientas ofrecen funcionalidades avanzadas como análisis predictivo, modelado estadístico y machine learning.

Costo

- Licenciamiento: Considera los diferentes modelos de licenciamiento (suscripción mensual, anual, perpetua) y los costos asociados.

- Escalabilidad: Evalúa si el costo de la herramienta aumentará a medida que tus necesidades crezcan.

- Características adicionales: Algunas herramientas ofrecen características adicionales como almacenamiento en la nube, soporte técnico y capacitación, lo que puede incrementar el costo.

Otros Factores a Considerar

- Integración con otras herramientas: Si utilizas otras herramientas de análisis o software empresarial, verifica si la herramienta de visualización se integra con ellas.

- Comunidad de usuarios: Una comunidad activa puede proporcionar soporte, recursos y ejemplos de uso.

- Soporte técnico: Asegúrate de que la herramienta ofrezca un buen soporte técnico en caso de que necesites ayuda.

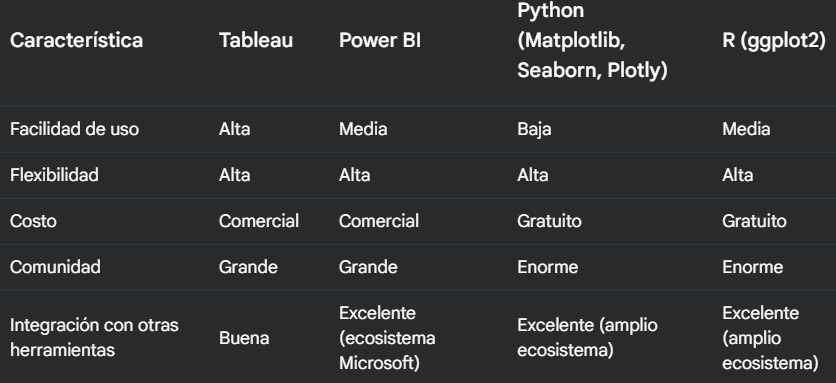

CaracterísticaTableauPower BIPython (Matplotlib, Seaborn, Plotly)R (ggplot2)Facilidad de usoAltaMediaBajaMediaFuncionalidadesAmpliasAmpliasMuy ampliasMuy ampliasCostoComercialComercialGratuitoGratuitoComunidadGrandeGrandeEnormeEnormeIntegraciónBuenaExcelente (ecosistema Microsoft)Excelente (amplio ecosistema)Excelente (amplio ecosistema)

Introducción a herramientas populares

Introducción a herramientas populares. Tableau, Power BI, Python (Matplotlib, Seaborn), R (ggplot2), etc.

En el panorama actual de la visualización de datos, una variedad de herramientas han surgido para satisfacer las diversas necesidades de los analistas y científicos de datos. Cada herramienta ofrece un conjunto único de características y funcionalidades, adaptándose a diferentes niveles de experiencia y tipos de proyectos. En esta unidad, exploraremos algunas de las herramientas más populares y sus características clave.

Tableau: La Estrella de la Visualización

- Características:Interfaz de arrastrar y soltar intuitiva

- Amplia gama de gráficos y visualizaciones

- Conexión a múltiples fuentes de datos

- Capacidad de crear dashboards interactivos

- Ventajas:Fácil de aprender y usar

- Gran comunidad de usuarios

- Ideal para análisis exploratorio y creación de dashboards

- Desventajas:Costo puede ser elevado para usuarios individuales

- Curva de aprendizaje para funcionalidades avanzadas

Power BI: La Opción de Microsoft

- Características:Integración profunda con el ecosistema de Microsoft

- Amplias capacidades de modelado de datos

- Servicio en la nube y aplicaciones móviles

- Ventajas:Ideal para organizaciones que utilizan productos de Microsoft

- Funcionalidades avanzadas de análisis

- Desventajas:Interfaz puede resultar compleja para usuarios principiantes

- Algunas funcionalidades requieren licencias adicionales

Python: La Flexibilidad del Código

- Bibliotecas:Matplotlib: Biblioteca base para crear gráficos estáticos, personalizables y de alta calidad.

- Seaborn: Construido sobre Matplotlib, ofrece una interfaz de alto nivel para crear gráficos estadísticos atractivos.

- Plotly: Crea gráficos interactivos y dashboards que se pueden exportar a diferentes formatos.

- Ventajas:Gran flexibilidad y personalización

- Comunidad activa y amplia documentación

- Ideal para análisis de datos complejos y científicos

- Desventajas:Requiere conocimientos de programación

- Curva de aprendizaje más pronunciada

R: El Líder en Estadística y Ciencia de Datos

- Biblioteca ggplot2:Inspirada en el libro "The Grammar of Graphics"

- Permite crear gráficos elegantes y personalizados a través de capas

- Ventajas:Ideal para análisis estadísticos y gráficos científicos

- Gran comunidad y paquetes adicionales

- Desventajas:Curva de aprendizaje más pronunciada que Tableau o Power BI

- Sintaxis puede ser más compleja para principiantes

Cuándo Utilizar Cada Herramienta

- Tableau: Ideal para análisis exploratorio, creación de dashboards interactivos y visualización de datos empresariales.

- Power BI: Perfecto para organizaciones que utilizan productos de Microsoft y necesitan una solución integrada.

- Python (Matplotlib, Seaborn, Plotly): Ideal para científicos de datos, ingenieros y aquellos que necesitan una gran flexibilidad y personalización.

- R (ggplot2): Perfecto para análisis estadísticos y gráficos científicos, especialmente para aquellos familiarizados con el lenguaje R.

Panorama general de las

herramientas de visualización

Panorama general de las herramientas de visualización. Desde hojas de cálculo hasta software especializado.

La visualización de datos ha evolucionado considerablemente en los últimos años, gracias a la proliferación de herramientas y software especializados. En esta unidad, exploraremos el panorama general de las herramientas disponibles para crear visualizaciones, desde las más básicas hasta las más sofisticadas, y discutiremos sus características clave y aplicaciones.

Hojas de Cálculo: El Punto de Partida

- Excel: La herramienta más utilizada para crear gráficos básicos como barras, líneas y dispersión.

- Ventajas: Familiaridad, facilidad de uso, integración con otras herramientas de Microsoft Office.

- Limitaciones: Funcionalidad limitada para visualizaciones más complejas, dificultad para crear dashboards interactivos.

- Google Sheets: Alternativa gratuita a Excel con funcionalidades similares y colaboración en tiempo real.

- Ventajas: Gratuito, fácil de usar, integración con Google Drive.

- Limitaciones: Menos opciones de personalización que Excel.

Software de Visualización Especializado

- Tableau: Una de las herramientas más populares para crear visualizaciones interactivas y dashboards.

- Ventajas: Facilidad de uso, gran variedad de gráficos, capacidad de conectar con múltiples fuentes de datos.

- Limitaciones: Costo, curva de aprendizaje algo pronunciada.

- Power BI: Otra herramienta poderosa de Microsoft, especialmente integrada con el ecosistema de Microsoft.

- Ventajas: Integración con otras herramientas de Microsoft, capacidad de crear informes interactivos.

- Limitaciones: Curva de aprendizaje similar a Tableau.

- Qlik Sense: Conocido por su capacidad de asociar datos de diferentes fuentes y crear aplicaciones analíticas.

- Ventajas: Asociación de datos, análisis asociativo, creación de aplicaciones.

- Limitaciones: Interfaz puede resultar compleja para usuarios principiantes.

- R y Python: Lenguajes de programación de código abierto con una amplia gama de paquetes para visualización de datos (ggplot2, seaborn, Plotly).

- Ventajas: Gran flexibilidad, personalización, comunidad activa.

- Limitaciones: Requiere conocimientos de programación.

Herramientas de Visualización en Línea

- Google Charts: Biblioteca gratuita de gráficos para incrustar en páginas web.

- Ventajas: Gratuito, fácil de usar, integración con Google Apps.

- Limitaciones: Funcionalidad limitada en comparación con otras herramientas.

- Datawrapper: Herramienta en línea para crear gráficos de alta calidad de forma rápida y sencilla.

- Ventajas: Fácil de usar, plantillas prediseñadas, opción de exportar gráficos en diferentes formatos.

- Limitaciones: Funcionalidad limitada para análisis de datos complejos.

Herramientas de Infografías

- Canva: Herramienta de diseño gráfico con plantillas prediseñadas para crear infografías.

- Ventajas: Fácil de usar, gran variedad de plantillas, ideal para usuarios sin conocimientos de diseño.

- Limitaciones: Menos orientada a datos complejos que otras herramientas.

- Piktochart: Otra herramienta popular para crear infografías y presentaciones visuales.

- Ventajas: Interfaz intuitiva, gran variedad de gráficos y elementos visuales.

- Limitaciones: Menos opciones de personalización que otras herramientas.

Factores a Considerar al Elegir una Herramienta

- Tipo de datos: ¿Qué tipo de datos vas a visualizar?

- Complejidad de la visualización: ¿Necesitas gráficos simples o interactivos?

- Conocimientos técnicos: ¿Tienes experiencia en programación o prefieres una herramienta de arrastrar y soltar?

- Presupuesto: ¿Cuál es tu presupuesto?

- Colaboración: ¿Necesitas compartir tus visualizaciones con otros?

Aplicaciones Prácticas en el Mundo Real

Aplicaciones Prácticas en el Mundo Real

Visualización de datos en diferentes industrias. Ejemplos en negocios, salud, ciencia, gobierno, etc.

Casos de éxito y fracasos. Análisis de visualizaciones efectivas e inefectivas.

Ética en la visualización de datos. Cómo evitar la manipulación de datos y la desinformación.

Ética en la visualización de datos

Ética en la visualización de datos. Cómo evitar la manipulación de datos y la desinformación.

La visualización de datos es una herramienta poderosa que puede influir en la opinión pública y la toma de decisiones. Sin embargo, si no se utiliza de manera ética, puede llevar a la manipulación de datos y la desinformación. En esta unidad, exploraremos los principios éticos de la visualización de datos y cómo evitar prácticas engañosas.

¿Qué es la Ética en la Visualización de Datos?

- Definición: La ética en la visualización de datos se refiere a los principios morales que guían la creación y presentación de visualizaciones, asegurando que sean precisas, justas y no engañosas.

- Importancia: La ética en la visualización de datos es crucial para mantener la integridad de la información y fomentar la confianza en los datos.

Principios Éticos Clave

- Veracidad: Los datos presentados deben ser precisos y completos.

- Objetividad: Evitar sesgos personales o ideológicos al seleccionar y presentar los datos.

- Transparencia: Explicar claramente cómo se obtuvieron y procesaron los datos.

- Contexto: Proporcionar suficiente contexto para que los espectadores puedan interpretar los datos correctamente.

- Claridad: Las visualizaciones deben ser fáciles de entender y no deben engañar al espectador.

Prácticas Deshonestas a Evitar

- Manipulación de ejes: Alterar los ejes para exagerar o minimizar las diferencias.

- Selección de datos: Presentar solo los datos que respaldan una determinada narrativa.

- Uso de colores engañosos: Utilizar colores para influir en la percepción de los datos.

- Gráficos tridimensionales engañosos: Distorsionar las proporciones y dificultar la comparación.

- Falta de contexto: Presentar datos sin el contexto necesario para interpretarlos correctamente. [Image: Ejemplos de gráficos que manipulan los datos]

Cómo Garantizar una Visualización Ética

- Comprender los datos: Asegurarse de entender completamente los datos antes de crear una visualización.

- Elegir el gráfico adecuado: Seleccionar el tipo de gráfico que mejor represente los datos y el mensaje.

- Utilizar colores y escalas de manera adecuada: Evitar colores engañosos y escalas que distorsionen los datos.

- Proporcionar suficiente contexto: Explicar claramente cómo se obtuvieron los datos y qué significan.

- Revisar la visualización con un ojo crítico: Preguntarse si la visualización es clara, precisa y no engañosa.

Casos Reales de Manipulación de Datos

- Censo de los Estados Unidos: A lo largo de la historia, el censo de los Estados Unidos ha sido objeto de manipulaciones para favorecer a ciertos grupos o políticas.

- Publicidad engañosa: Muchas empresas utilizan gráficos engañosos para exagerar los beneficios de sus productos.

- Política: Los políticos a menudo utilizan gráficos para respaldar sus argumentos, incluso cuando los datos no los respaldan completamente.

El Papel del Diseño en la Ética

- Diseño ético: El diseño de una visualización puede influir en la forma en que los espectadores interpretan los datos.

- Responsabilidad del diseñador: Los diseñadores tienen la responsabilidad de crear visualizaciones que sean claras, precisas y no engañosas.

Conclusión

La ética en la visualización de datos es fundamental para garantizar la integridad de la información y fomentar la confianza en los datos. Al seguir los principios éticos y evitar prácticas engañosas, podemos crear visualizaciones que sean informativas, precisas y justas.

¿Te gustaría profundizar en algún aspecto específico de la ética en la visualización de datos o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- La ética en la inteligencia artificial y la visualización de datos

- El papel de los medios de comunicación en la difusión de visualizaciones engañosas

- Cómo detectar visualizaciones engañosas

Casos de éxito y fracasos

Casos de éxito y fracasos. Análisis de visualizaciones efectivas e inefectivas.

La visualización de datos es una herramienta poderosa, pero su efectividad depende en gran medida de cómo se aplica. En esta unidad, exploraremos casos reales de visualizaciones, tanto exitosas como fallidas, para comprender los principios que hacen que una visualización sea efectiva y las trampas que deben evitarse.

Casos de Éxito: Lo que Funciona

- Visualizaciones que cuentan historias:The New York Times: Sus visualizaciones interactivas sobre temas como el cambio climático y las elecciones presidenciales han sido ampliamente reconocidas por su capacidad para contar historias complejas de manera clara y atractiva.

- Gapminder: Hans Rosling y su equipo utilizaron visualizaciones innovadoras para desafiar los estereotipos y mostrar el progreso global en temas como la salud y la pobreza. [Image: Ejemplo de una visualización de Gapminder]

- Dashboards interactivos:Google Analytics: Permite a los marketers analizar el rendimiento de sus campañas y tomar decisiones basadas en datos en tiempo real.

- Tableau Public: Una plataforma donde usuarios de todo el mundo comparten sus visualizaciones, mostrando la versatilidad de esta herramienta para diferentes industrias. [Image: Ejemplo de un dashboard de Google Analytics]

- Infografías:National Geographic: Sus infografías son conocidas por su diseño atractivo y su capacidad para comunicar información compleja de manera sencilla.

- The Economist: Utiliza infografías para explicar temas económicos y políticos de manera visualmente atractiva. [Image: Ejemplo de una infografía de National Geographic]

Casos de Fracaso: Lo que No Funciona

- Sobrecarga de información:Gráficos con demasiados datos: Dificultan la comprensión y distraen al espectador.

- Uso excesivo de colores y efectos: Crean una sensación de desorden y dificultan la lectura. [Image: Ejemplo de un gráfico sobrecargado de información]

- Escalas engañosas:Ejes truncados: Distorsionan las diferencias entre los valores.

- Uso inadecuado de áreas: Crean una impresión errónea de las proporciones. [Image: Ejemplo de un gráfico con una escala engañosa]

- Falta de contexto:Gráficos sin títulos ni etiquetas: Dificultan la interpretación de los datos.

- Datos sin referencia: No permiten comparar los resultados con otros datos o benchmarks. [Image: Ejemplo de un gráfico sin contexto]

Lecciones Aprendidas

- La importancia de la historia: Una buena visualización cuenta una historia clara y concisa.

- La simplicidad es clave: Menos es más. Evita la sobrecarga de información y elige los gráficos adecuados.

- El contexto es fundamental: Proporciona suficiente contexto para que el espectador pueda interpretar los datos.

- La estética importa: Una visualización atractiva es más fácil de recordar y compartir.

- La interactividad mejora la experiencia: Permite a los usuarios explorar los datos a su propio ritmo.

Análisis de los Casos

- ¿Qué hace que una visualización sea exitosa?Claridad, concisión, relevancia, estética, interactividad.

- ¿Cuáles son los errores más comunes?Sobrecarga de información, escalas engañosas, falta de contexto, diseño pobre.

- ¿Cómo podemos evitar estos errores?Planificar la visualización antes de comenzar, elegir los gráficos adecuados, utilizar herramientas de diseño, pedir feedback.

Conclusión

Al analizar casos de éxito y fracaso, podemos aprender valiosas lecciones sobre cómo crear visualizaciones efectivas. La clave está en combinar la belleza y la funcionalidad, y en contar una historia que resuene con la audiencia.

¿Te gustaría profundizar en algún caso específico o explorar otros ejemplos?

Posibles temas a explorar en futuras unidades:

- Visualizaciones engañosas y cómo identificarlas

- Mejores prácticas para la creación de dashboards interactivos

- El futuro de la visualización de datos

Visualización de datos

en diferentes industrias

Visualización de datos en diferentes industrias. Ejemplos en negocios, salud, ciencia, gobierno, etc.

La visualización de datos ha revolucionado la forma en que las industrias analizan información y toman decisiones. Al transformar datos complejos en representaciones visuales, las empresas pueden identificar patrones, tendencias y oportunidades de manera más rápida y efectiva. En esta unidad, exploraremos cómo la visualización de datos se aplica en diversas industrias, desde los negocios hasta la ciencia.

Visualización de Datos en los Negocios

- Análisis de ventas: Identificar productos más vendidos, tendencias de mercado y oportunidades de crecimiento.

- Gestión de clientes: Segmentar clientes, analizar el comportamiento de compra y mejorar la experiencia del cliente.

- Marketing digital: Medir el rendimiento de las campañas, optimizar el presupuesto y conocer a la audiencia.

- Finanzas: Visualizar indicadores clave de rendimiento (KPI), detectar fraudes y predecir tendencias financieras. [Image: Ejemplo de un dashboard de ventas interactivo]

Visualización de Datos en la Salud

- Análisis de registros médicos: Identificar patrones en enfermedades, desarrollar tratamientos personalizados y mejorar la eficiencia de los hospitales.

- Investigación biomédica: Visualizar datos genómicos, proteómicos y de imágenes médicas para descubrir nuevos tratamientos.

- Epidemiología: Monitorear la propagación de enfermedades y evaluar el impacto de las intervenciones de salud pública. [Image: Ejemplo de una visualización de datos genómicos]

Visualización de Datos en la Ciencia

- Exploración de datos: Visualizar grandes conjuntos de datos para descubrir patrones y relaciones.

- Modelado y simulación: Visualizar resultados de modelos matemáticos y simulaciones.

- Gestión de proyectos científicos: Seguimiento del progreso de los proyectos y colaboración entre investigadores. [Image: Ejemplo de una visualización de datos astronómicos]

Visualización de Datos en el Gobierno

- Planificación urbana: Analizar el uso del suelo, el tráfico y otros datos urbanos para mejorar la calidad de vida.

- Política pública: Evaluar el impacto de las políticas públicas y tomar decisiones basadas en datos.

- Seguridad nacional: Monitorear amenazas y detectar patrones de comportamiento sospechoso. [Image: Ejemplo de un mapa de calor que muestra la densidad de población]

Visualización de Datos en Otras Industrias

- Educación: Analizar el rendimiento de los estudiantes, identificar áreas de mejora y personalizar el aprendizaje.

- Medio ambiente: Monitorear el cambio climático, analizar la calidad del aire y del agua, y gestionar los recursos naturales.

- Deportes: Analizar el rendimiento de los atletas, optimizar las estrategias de entrenamiento y mejorar el desempeño de los equipos.

Herramientas y Técnicas Comunes

- Dashboards interactivos: Permiten a los usuarios explorar los datos de manera dinámica.

- Mapas: Visualizan datos geográficos y espaciales.

- Gráficos de red: Representan relaciones entre entidades.

- Visualizaciones de tiempo: Muestra cómo los datos cambian a lo largo del tiempo.

- Inteligencia artificial: Automatiza la creación de visualizaciones y descubre insights ocultos.

Desafíos y Consideraciones

- Calidad de los datos: La calidad de los datos es fundamental para la visualización efectiva.

- Privacidad de los datos: Es necesario proteger la privacidad de los datos personales.

- Interpretación de los datos: La visualización no debe sesgar la interpretación de los datos.

Conclusión

La visualización de datos se ha convertido en una herramienta indispensable en todas las industrias. Al transformar datos complejos en representaciones visuales, las organizaciones pueden tomar decisiones más informadas, mejorar la eficiencia y obtener una ventaja competitiva.

¿Te gustaría profundizar en alguna industria en particular o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- Visualización de datos en tiempo real

- Ética en la visualización de datos

- Tendencias futuras en la visualización de datos

Diseño y Estética

Diseño y Estética

Principios del diseño de la información. Claridad, concisión, coherencia.

La importancia del color, la tipografía y el espacio en blanco. Cómo estos elementos afectan la percepción.

Creación de narrativas visuales. Cómo contar una historia a través de los datos.

Creación de narrativas visuales

Creación de narrativas visuales. Cómo contar una historia a través de los datos.

La visualización de datos no se limita a presentar números y gráficos; es una herramienta poderosa para contar historias y comunicar ideas de manera efectiva. La creación de narrativas visuales implica transformar datos en una secuencia lógica que guíe al espectador a través de una historia. En esta unidad, exploraremos cómo construir narrativas visuales impactantes y persuasivas.

¿Qué es una Narrativa Visual?

- Definición: Una narrativa visual es una secuencia de visualizaciones que cuentan una historia.

- Objetivo: Comunicar un mensaje claro y conciso a través de los datos.

- Elementos:Introducción: Presenta el contexto y la pregunta central.

- Desarrollo: Despliega los datos de manera lógica, destacando los puntos clave.

- Conclusión: Resume los hallazgos principales y ofrece una perspectiva.

Cómo Construir una Narrativa Visual

- Identificar la historia: ¿Cuál es el mensaje principal que quieres transmitir?

- Seleccionar los datos relevantes: ¿Qué datos apoyan tu historia?

- Crear una estructura narrativa: Define la secuencia de las visualizaciones.

- Elegir los tipos de gráficos adecuados: Cada gráfico debe cumplir un propósito específico.

- Utilizar elementos de diseño: Color, tipografía, espacio en blanco para enfatizar los puntos clave.

- Incluir texto explicativo: El texto debe complementar las visualizaciones, no duplicarlas.

- Crear una experiencia interactiva: Permite al espectador explorar los datos de forma dinámica.

Elementos Clave de una Narrativa Visual Efectiva

- Claridad: Cada visualización debe ser fácil de entender.

- Coherencia: Las visualizaciones deben fluir de manera lógica.

- Concisión: Evita la sobrecarga de información.

- Impacto: Despierta el interés y la emoción del espectador.

Técnicas para Mejorar la Narrativa Visual

- Storyboarding: Planifica la secuencia de las visualizaciones.

- Jerarquía visual: Guía la atención del espectador hacia los elementos más importantes.

- Transiciones suaves: Crea una experiencia fluida al pasar de una visualización a otra.

- Uso de metáforas visuales: Transforma conceptos abstractos en imágenes concretas.

- Interactividad: Permite al espectador explorar los datos a su propio ritmo.

Ejemplos de Narrativas Visuales Efectivas

- Casos de éxito: Análisis de campañas de marketing exitosas basadas en datos.

- Estudios de caso: Exploración de problemas del mundo real y cómo los datos pueden ayudar a encontrar soluciones.

- Tableros de control interactivos: Visualización de datos en tiempo real para tomar decisiones informadas.

Herramientas para Crear Narrativas Visuales

- Software especializado: Tableau, Power BI, R, Python

- Herramientas de presentación: PowerPoint, Google Slides

Conclusión

La creación de narrativas visuales es una habilidad esencial para comunicar ideas de manera efectiva a través de los datos. Al seguir estos principios y utilizar las herramientas adecuadas, puedes transformar datos complejos en historias poderosas que inspiren y persuadan.

¿Te gustaría profundizar en algún aspecto específico de la creación de narrativas visuales o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- Narrativas visuales interactivas

- La importancia del contexto en la narrativa visual

- Cómo combinar datos cualitativos y cuantitativos en una narrativa visual

- Ética en la visualización de datos

La importancia del color, la

tipografía y el espacio en blanco

La importancia del color, la tipografía y el espacio en blanco. Cómo estos elementos afectan la percepción.

El diseño de una visualización de datos va más allá de simplemente representar datos. Los elementos visuales como el color, la tipografía y el espacio en blanco juegan un papel fundamental en cómo los espectadores perciben y comprenden la información. En esta unidad, exploraremos cómo estos elementos afectan la percepción y cómo utilizarlos de manera efectiva para crear visualizaciones impactantes.

El Color: Más que una Decoración

- Psicología del color: Los colores evocan emociones y asociaciones culturales.

- Colores cálidos: Rojo, naranja, amarillo: asociadas con energía, pasión, calor.

- Colores fríos: Azul, verde, violeta: asociadas con calma, tranquilidad, confianza.

- Colores neutros: Blanco, negro, gris: proporcionan equilibrio y sofisticación. [Image of: Rueda de color y ejemplos de cómo los colores afectan las emociones]

- Jerarquía visual: El color puede destacar elementos importantes y guiar la atención del espectador.

- Legibilidad: La combinación de colores debe garantizar una buena legibilidad.

La Tipografía: Más que Letras

- Legibilidad: La elección de la fuente afecta la facilidad de lectura.

- Jerarquía: Las diferentes fuentes pueden crear jerarquías visuales.

- Personalidad: La tipografía puede transmitir una sensación de formalidad, informalidad, modernidad, etc. [Image of: Ejemplos de diferentes tipos de fuentes y su impacto visual]

- Emparejamiento de fuentes: Combinar fuentes de manera efectiva para crear una composición armoniosa.

El Espacio en Blanco: El Respiro de la Visualización

- Claridad: El espacio en blanco mejora la legibilidad y reduce la saturación visual.

- Jerarquía: El espacio en blanco puede resaltar elementos importantes.

- Respiración: Permite a los espectadores descansar la vista y procesar la información. [Image of: Ejemplos de cómo el espacio en blanco mejora la legibilidad]

La Interacción entre Color, Tipografía y Espacio en Blanco

- Armonía: Estos elementos deben trabajar juntos para crear una composición cohesiva.

- Contraste: El contraste entre elementos puede resaltar información importante.

- Equilibrio: Una distribución equilibrada de los elementos crea una sensación de armonía.

Ejemplos Prácticos

- Análisis de diferentes paletas de colores: Cómo los colores afectan la percepción de los datos.

- Comparación de diferentes tipos de fuentes: Cómo la tipografía influye en la legibilidad y la estética.

- Estudio de casos: Análisis de visualizaciones exitosas y fallidas en términos de uso del color, tipografía y espacio en blanco.

Herramientas para Crear Visualizaciones Efectivas

- Software especializado: Tableau, Power BI, R, Python

- Hojas de cálculo: Excel, Google Sheets

Conclusión

El color, la tipografía y el espacio en blanco son elementos fundamentales en el diseño de visualizaciones de datos. Al utilizar estos elementos de manera efectiva, podemos crear visualizaciones que sean no solo informativas, sino también estéticamente agradables y memorables.

¿Te gustaría profundizar en algún elemento específico o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- Teoría del color y su aplicación en la visualización de datos

- La psicología de la tipografía

- Diseño de paletas de colores personalizadas

- Cómo crear narrativas visuales efectivas utilizando el color y la tipografía

Principios del diseño de la información

Principios del diseño de la información. Claridad, concisión, coherencia.

El diseño de la información es fundamental para crear visualizaciones de datos efectivas. Los principios de claridad, concisión y coherencia son esenciales para garantizar que nuestras visualizaciones sean fáciles de entender, transmitan la información de manera clara y sean visualmente atractivas. En esta unidad, exploraremos cómo aplicar estos principios a la visualización de datos.

Claridad: La Facilidad de Entender

- Definiciones claras: Cada elemento visual debe tener una definición clara y un significado único.

- Jerarquía visual: Guía la atención del espectador hacia los elementos más importantes.

- Etiquetado preciso: Los ejes, leyendas y títulos deben ser claros y concisos.

- Colores y contrastes adecuados: Utiliza colores que faciliten la distinción entre elementos.

- Tipografía legible: Elige fuentes que sean fáciles de leer y que se adapten al contexto. [Image of: Ejemplo de una visualización clara vs. una confusa]

Concisión: La Esencia del Mensaje

- Eliminar lo innecesario: Elimina cualquier elemento que no sea esencial para comunicar el mensaje principal.

- Simplificar la información: Evita la sobrecarga de información y presenta los datos de manera concisa.

- Priorizar la información: Destaca los hallazgos más importantes.

- Utilizar gráficos adecuados: Elige el tipo de gráfico que mejor represente los datos y el mensaje. [Image of: Ejemplo de una visualización concisa vs. una sobrecargada]

Coherencia: La Unidad del Diseño

- Estilo visual consistente: Utiliza un estilo visual uniforme en toda la visualización.

- Relación entre elementos: Los elementos visuales deben estar relacionados entre sí de manera lógica.

- Flujo visual: Guía al espectador a través de la visualización de manera natural.

- Jerarquía visual consistente: Mantén una jerarquía visual consistente en toda la visualización. [Image of: Ejemplo de una visualización con coherencia visual]

La Importancia de la Percepción Visual

- Ley de la pregnancia: Tendemos a percibir las formas de la manera más simple y organizada posible.

- Ley de proximidad: Elementos cercanos se perciben como un grupo.

- Ley de semejanza: Elementos similares se perciben como un grupo.

- Ley de continuidad: Tendemos a seguir líneas o curvas suaves.

- Ley de cierre: Tendemos a completar formas incompletas.

- Figura-fondo: Separamos los objetos de su entorno. [Image of: Ejemplos de las leyes de la percepción visual aplicadas a gráficos]

Ejemplos Prácticos

- Comparación de diferentes visualizaciones: Análisis de cómo la claridad, concisión y coherencia afectan la comprensión.

- Casos de éxito y fracaso: Identificación de los principios aplicados y los errores cometidos.

Herramientas para Crear Visualizaciones Efectivas

- Software especializado: Tableau, Power BI, R, Python

- Hojas de cálculo: Excel, Google Sheets

Conclusión

La claridad, concisión y coherencia son principios fundamentales del diseño de la información que deben aplicarse a todas las visualizaciones de datos. Al seguir estos principios, podemos crear visualizaciones que sean no solo estéticamente agradables, sino también altamente informativas y persuasivas.

¿Te gustaría profundizar en algún principio específico o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- El papel del color en la visualización de datos

- La importancia de la tipografía en la visualización

- Cómo crear narrativas visuales efectivas

Fundamentos Teóricos

Fundamentos Teóricos

- Principios de la percepción visual. Cómo el cerebro procesa la información visual.

- Elementos básicos de un gráfico. Tipos de gráficos, ejes, escalas, leyendas, etc.

- Tipos de datos y su representación visual. Datos numéricos, categóricos, temporales, geográficos.

- La elección del gráfico adecuado. Cómo seleccionar el tipo de gráfico más efectivo para comunicar la información.

La elección del gráfico adecuado

La elección del gráfico adecuado. Cómo seleccionar el tipo de gráfico más efectivo para comunicar la información.

La elección del gráfico adecuado es una decisión crucial en la visualización de datos. Un gráfico bien seleccionado puede transformar datos complejos en información fácilmente comprensible, mientras que una elección equivocada puede llevar a conclusiones erróneas. En esta unidad, exploraremos los factores clave a considerar al seleccionar el tipo de gráfico más efectivo para comunicar tu mensaje.

Factores a Considerar al Elegir un Gráfico

- Tipo de datos: ¿Son numéricos, categóricos, temporales o geográficos?

- Mensaje a comunicar: ¿Qué quieres destacar? Tendencias, comparaciones, distribuciones, relaciones?

- Audiencia: ¿Cuál es el nivel de conocimiento técnico de tu audiencia?

- Número de variables: ¿Cuántas variables quieres representar?

- Complejidad de los datos: ¿Los datos son simples o complejos?

Preguntas Clave para Guiar tu Elección

- ¿Quiero comparar categorías?

- ¿Quiero mostrar una tendencia a lo largo del tiempo?

- ¿Quiero mostrar la distribución de los datos?

- ¿Quiero mostrar la relación entre dos variables?

- ¿Quiero mostrar partes de un todo?

- ¿Quiero representar datos geográficos?

Matriz de Decisión para la Selección de Gráficos

Pregunta Tipo de Gráfico Sugerido

Comparación de categorías Gráfico de barras, gráfico circular

Tendencia a lo largo del tiempo Gráfico de líneas, gráfico de área

Distribución de datos Histograma, diagrama de caja

Relación entre dos variables Diagrama de dispersión

Partes de un todo Gráfico circular

Datos geográficos Mapa

Ejemplos Prácticos

- Comparar las ventas de diferentes productos: Gráfico de barras

- Mostrar la evolución del precio de una acción a lo largo del tiempo: Gráfico de líneas

- Visualizar la distribución de edades en una población: Histograma

- Mostrar la relación entre el tamaño de una casa y su precio: Diagrama de dispersión

- Representar la proporción de votos por candidato: Gráfico circular

- Visualizar la densidad de población en un país: Mapa coropleta

Consideraciones Adicionales

- Estética: Un gráfico atractivo facilita la comprensión.

- Interactividad: Permite a los usuarios explorar los datos de forma más profunda.

- Contexto: Proporciona suficiente contexto para interpretar los datos.

Errores Comunes a Evitar

- Sobrecarga de información: Demasiados datos en un solo gráfico.

- Escalas engañosas: Manipulación de las escalas para distorsionar los datos.

- Uso incorrecto del color: Dificulta la distinción entre elementos.

- Gráficos tridimensionales excesivos: Pueden dificultar la lectura.

Conclusión

La elección del gráfico adecuado es un arte que requiere tanto conocimiento técnico como habilidades de comunicación visual. Al seguir estos principios y considerar los factores mencionados, podrás crear visualizaciones que sean claras, concisas y efectivas.

¿Te gustaría profundizar en algún aspecto específico de la elección de gráficos o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- Visualización de datos multivariados

- Creación de dashboards interactivos

- Ética en la visualización de datos

Tipos de datos y su representación visual

Tipos de datos y su representación visual. Datos numéricos, categóricos, temporales, geográficos.

La elección del tipo de gráfico adecuado es crucial para una visualización efectiva. La naturaleza de los datos, ya sean numéricos, categóricos, temporales o geográficos, determina la mejor manera de representarlos visualmente. En esta unidad, exploraremos los diferentes tipos de datos y los gráficos más adecuados para cada uno.

Tipos de Datos

- Datos Numéricos: Representan cantidades o medidas.

- Discretos: Valores enteros (ej: número de ventas, cantidad de productos).

- Continuos: Pueden tomar cualquier valor dentro de un intervalo (ej: altura, peso, temperatura).

- Datos Categóricos: Representan grupos o categorías.

- Nominales: No hay un orden inherente (ej: color, género).

- Ordinales: Existe un orden natural (ej: niveles de satisfacción, calificaciones).

- Datos Temporales: Representan eventos que ocurren en un momento específico.

- Datos Geográficos: Relacionados con ubicaciones en un mapa.

Representación Visual de Datos Numéricos

- Gráficos de barras: Comparación de categorías numéricas.

- Histogramas: Distribución de datos numéricos continuos.

- Gráficos de líneas: Tendencias a lo largo del tiempo.

- Diagramas de dispersión: Relación entre dos variables numéricas.

[Image of: Ejemplos de gráficos de barras, histogramas, líneas y dispersión]

Representación Visual de Datos Categóricos

- Gráficos de barras: Comparación de frecuencias entre categorías.

- Gráficos circulares: Proporción de cada categoría dentro del total.

- Gráficos de barras apiladas: Comparación de múltiples categorías.

[Image of: Ejemplos de gráficos de barras, circulares y apilados para datos categóricos]

Representación Visual de Datos Temporales

- Gráficos de líneas: Evolución de una variable a lo largo del tiempo.

- Gráficos de área: Visualización de acumulados a lo largo del tiempo.

[Image of: Ejemplos de gráficos de líneas y área para datos temporales]

Representación Visual de Datos Geográficos

- Mapas:Coropletas: Utilizan colores para representar valores en áreas geográficas.

- De puntos: Representan ubicaciones exactas.

- De flujo: Muestran movimientos o flujos entre ubicaciones.

[Image of: Ejemplos de mapas coropletas, de puntos y de flujo]

Principios para Seleccionar el Gráfico Adecuado

- Tipo de datos: El tipo de gráfico debe coincidir con el tipo de datos.

- Mensaje a comunicar: ¿Qué quieres mostrar?

- Audiencia: ¿Quién verá el gráfico?

- Complejidad: Evita gráficos demasiado complejos.

- Estética: Un buen diseño mejora la comprensión.

Herramientas para Crear Visualizaciones

- Hojas de cálculo: Excel, Google Sheets

- Software especializado: Tableau, Power BI, R, Python

Conclusión

La elección del tipo de gráfico adecuado es fundamental para una visualización efectiva. Al comprender los diferentes tipos de datos y sus representaciones visuales, podrás comunicar tus hallazgos de manera clara y concisa.

¿Te gustaría profundizar en algún tipo de dato en particular o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- Visualización de datos multivariados

- Creación de dashboards interactivos

- Ética en la visualización de datos

Elementos básicos de un gráfico

Elementos básicos de un gráfico. Tipos de gráficos, ejes, escalas, leyendas, etc.

Un gráfico es más que una simple imagen; es una herramienta poderosa para comunicar información de manera concisa y efectiva. Cada elemento que compone un gráfico juega un papel crucial en la transmisión de los datos y en la interpretación que hace el espectador. En esta unidad, exploraremos los elementos básicos de un gráfico y cómo utilizarlos de manera estratégica para crear visualizaciones impactantes.

Los Componentes Esenciales de un Gráfico

- Título:Función: Resume el contenido del gráfico de manera clara y concisa.

- Ubicación: Generalmente en la parte superior del gráfico.

- Importancia: Proporciona al espectador una primera impresión rápida del tema.

- Ejes:Eje X: Representa la variable independiente o categoría.

- Eje Y: Representa la variable dependiente o valor numérico.

- Escalas:Lineales: La distancia entre los valores es proporcional a la diferencia entre ellos.

- Logarítmicas: Útil para representar rangos de valores muy grandes.

- Categóricas: Para representar categorías o grupos. [Image of: Ejemplo de ejes lineales, logarítmicos y categóricos]

- Etiquetas:Ejes: Identifican las variables representadas en cada eje.

- Datos: Proporcionan información adicional sobre los puntos de datos.

- Leyenda:Explica los símbolos, colores o patrones utilizados en el gráfico.

- Ubicación: Generalmente en una esquina del gráfico.

- Área del gráfico:Espacio donde se representan los datos.

- Título de datos:Identifica cada conjunto de datos o serie.

Tipos de Gráficos y su Uso

- Gráficos de barras: Comparación de categorías.

- Gráficos de líneas: Mostrar tendencias a lo largo del tiempo.

- Gráficos circulares: Proporción de partes dentro de un todo.

- Histogramas: Distribución de datos numéricos.

- Diagramas de dispersión: Relación entre dos variables numéricas.

- Mapas: Datos geográficos. [Image of: Ejemplos de diferentes tipos de gráficos]

Principios de Diseño para Gráficos Efectivos

- Simplicidad: Evita la sobrecarga de información.

- Claridad: Los elementos deben ser fáciles de entender.

- Coherencia: Utiliza un estilo visual consistente.

- Relevancia: Solo incluye la información necesaria.

- Estética: Un diseño atractivo puede mejorar la comprensión.

Errores Comunes en la Creación de Gráficos

- Escalas engañosas: Manipulación de las escalas para distorsionar los datos.

- Uso excesivo de efectos 3D: Puede dificultar la lectura.

- Colores poco contrastantes: Dificulta la distinción entre elementos.

- Legendas confusas: Deben ser claras y concisas.

Herramientas para Crear Gráficos

- Hojas de cálculo: Excel, Google Sheets.

- Software especializado: Tableau, Power BI, R, Python.

Conclusión

La elección y el diseño adecuados de los elementos de un gráfico son fundamentales para comunicar información de manera efectiva. Al comprender los principios básicos de la visualización de datos, podemos crear gráficos que sean no solo estéticamente agradables, sino también altamente informativos.

¿Te gustaría profundizar en algún elemento en particular o explorar ejemplos más detallados?

Posibles temas a explorar en futuras unidades:

- La importancia del color en la visualización de datos

- Cómo elegir el tipo de gráfico adecuado para tus datos

- Diseño de dashboards interactivos

- Visualización de datos en tiempo real

Principios de la percepción visual

Principios de la percepción visual. Cómo el cerebro procesa la información visual.

La visualización de datos no es solo una técnica estética; es una ciencia que aprovecha la forma en que el cerebro humano procesa la información visual. Comprender estos principios fundamentales nos permitirá crear visualizaciones más efectivas y comunicar nuestras ideas de manera más clara.

¿Qué es la Percepción Visual?

- Definición: La percepción visual es el proceso mediante el cual el cerebro interpreta la información que recibe a través de los ojos.

- El papel del cerebro: El cerebro organiza, interpreta y da sentido a las imágenes que vemos.

- Factores que influyen en la percepción: Experiencias previas, cultura, contexto y expectativas personales.

Principios Básicos de la Percepción Visual