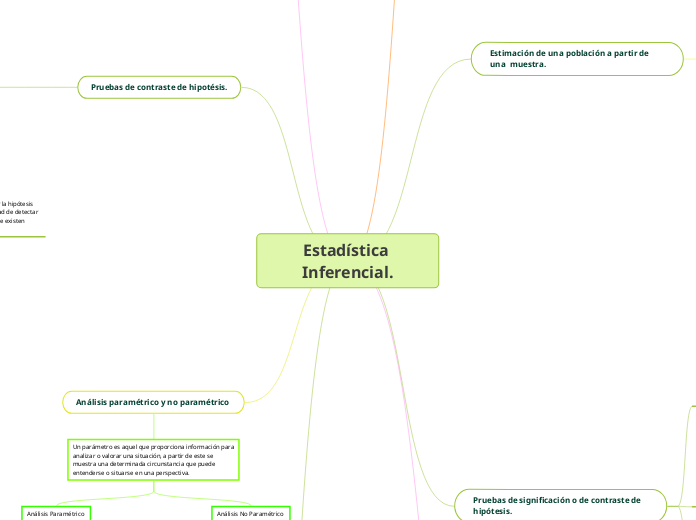

Estadística Inferencial.

Distribuciones de probabilidad.

La distribución normal.

Distribución de probabilidad

Es aquella que permite establecer toda la gama de resultados probables de ocurrir en un experimento determinado.

Características

La probabilidad de un resultado específico está entre cero y uno.

La suma de las probabilidades de todos los resultados mutuamente excluyentes es 1.

La distribución de probabilidad es una herramienta fundamental para la prospectiva, puesto que con ella es posible diseñar un escenario de acontecimientos futuros considerando las tendencias actuales de diversos fenómenos.

Variable aleatoria discreta

Solo puede tomar valores representados por números enteros y un número finito de ellos.

Propiedades

Las probabilidades que se relacionan con cada uno de los valores que toma x deben ser mayores o iguales a cero y menores o iguales a 1

La sumatoria de las probabilidades asociadas a cada uno de los valores que toma x debe ser igual a 1.

Variable aleatoria continua

Esta puede tomar tanto valores expresados en números enteros como fraccionarios y un número infinito de ellos dentro de un mismo intervalo.

Propiedades

Las probabilidades vinculadas a cada uno de los valores que toma x deben ser mayores o iguales a cero. Dicho de otro modo: la función de densidad de probabilidad deberá tomar solo valores mayores o iguales a cero.

El área definida bajo la función de densidad de probabilidad deberá ser de 1.

La esperanza matemática o valor esperado de una variable aleatoria se origina en los juegos de azar

Distribución de probabilidad normal

Es la distribución continua que se utiliza más comúnmente en estadística, es un modelo que aproxima el valor de una variable aleatoria a una situación ideal, dependiendo de la media y la desviación típica.

Importancia

Muchas variables continuas comunes en el mundo de los negocios tienen distribuciones que se asemejan estrechamente a la distribución normal.

La distribución normal sirve para acercarse a diversas distribuciones de probabilidad discreta, como la distribución binomial y la distribución de Poisson.

La distribución normal proporciona la base para la estadística inferencial clásica por su relación con el teorema de límite central.

Propiedades

Tiene una apariencia de forma de campana y, por ende, es simétrica.

Sus medidas de tendencia central (media, mediana y moda) son todas idénticas.

Su «50% central» es igual a 1,33 desviaciones estándar. Esto significa que el rango intercuartil está contenido dentro de un intervalo de dos tercios de una desviación estándar por debajo de la media y de dos tercios de una desviación estándar por encima de la media.

Su variable aleatoria asociada tiene un rango infinito (-∞ < X < ∞).

Estimación de una población a partir de una muestra.

A partir de lo observado en una muestra (un resumen estadístico con las medidas que conocemos de Descriptiva) se extrapola o generaliza dicho resultado muestral a la población total, de modo que lo estimado es el valor generalizado a la población.

El mejor estimador

Si quiero aproximar la media de la población pues cogeré la media de la muestra y si quiero estimar la varianza, pues se hallara la de la muestra

Muestra con reemplazo

se obtiene escogiendo sucesivamente un determinado número de elementos de la población sin quitarlos de la misma, de forma que pueden repetirse

Tamaño de la muestra

Depende del nivel de confianza que se desee para los resultados y de la amplitud del intervalo de confianza, es decir del error máximo que se esté dispuesto a admitir

Estimación inter censal

Se utiliza para estimar la población total la mitad de periodo o un subconjunto de la población de una localidad dada

Estimación post censal

Usa información de la vivienda para estimar el tamaño total de la población para una localidad.

Pruebas de significación o de contraste de hipótesis.

Estimación puntual.

La estimación puntual hace referencia al cálculo de valores

que apuntan hacia el verdadero valor poblacional, como por ejemplo: estimación de una media o de una prevalencia. De esta forma, un buen estimador debe ser:

Insesgado.

Que el valor del parámetro coincida con el valor promedio del

estimador. Esta propiedad la tienen la mayoría de los estimadores usados

en la práctica.

Consistente.

Que el valor de la muestra se acerque al valor del parámetro

al aumentar el tamaño de la muestra.

Suficiente

Que el estimador use toda la información que la muestra contiene respecto al parámetro de interés.

Eficiente.

Que el estimador tenga menor variabilidad que otro posible.

Hipotésis nula o alternativa.

La hipótesis nula (H0) se refiere a la afirmación contraria a la que ha llegado el investigador. Es la hipótesis que el investigador pretender rechazar. Si tiene la evidencia suficiente para ello, podrá probar que lo contrario es cierto (usualmente el valor crítico es 0,05) .

Las pruebas de hipótesis son formulaciones de lo que queremos contrastar y, en base a resultados probabilísticos (asociados a la popularmente conocida «p» o «p-value»), aceptaremos la hipótesis nula o la rechazaremos.

Error Alfa y error Beta.

Error alfa.

Es el que se comete al rechazar la hipótesis nula H0

siendo cierta.

El error alfa debe ser fijado a prioridad por los responsables del estudio, puesto que es el que marca el nivel de rechazo de la hipótesis nula. Este valor se sitúa generalmente en 0,05 y es el valor con el que compararemos nuestra «p», obtenida mediante el estadístico de contraste adecuado a nuestros objetivos.

El nivel de significación α lo marcamos nosotros de manera que, cuanto mayor sea, más fácil será

aceptar la hipótesis alternativa cuando en realidad es falsa.

Error Beta.

es el error que se comete al aceptar la hipótesis nula H0

siendo falsa

La probabilidad de rechazar la hipótesis

nula cuando ésta es falsa, es decir, la probabilidad de detectar diferencias entre

tratamientos cuando realmente existen diferencias

Asociado al error beta se ha definido la potencia estadística de un test como 1-beta. Al igual que el nivel de significación, el error beta o poder estadístico debe definirse antes de iniciar el estudio para estimar el tamaño muestral necesario para poder evaluar el objetivo del estudio.

Referencias bibliográficas.

Carreño, Á. (s. f.). Pruebas de contraste de hipotésis. Estimación puntual por intervalos. revistasden. Recuperado 30 de abril de 2023, de https://www.revistaseden.org/files/10-CAP%2010.pdf

González, A. (2019). Contraste de hipotésis mediante técnicas de simulación. Revista de Educación Matemática, 34(1).

Berenson, Mark L.; Levine, David M. y Krehbiel, Timothy C. Estadística para administración. Pearson Educación, 2006, p.179

(S/f-b). Sergas.es. Recuperado el 1 de mayo de 2023, de https://www.sergas.es/Saude-publica/Documents/1899/Ayuda_Epidat_4_Distribuciones_de_probabilidad_Octubre2014.pdf

Quevedo, F. (2011). Distribución normal. Medwave. https://doi.org/10.5867/medwave.2011.05.5033

George W. Barclay, "Rates and Ratios," Techniques of Population Analysis (New York: John Wiley & Sons, 1958) 16-55.

Conoce las principales distribuciones de probabilidad. (s/f). Edu.pe. Recuperado el 1 de mayo de 2023, de https://www.esan.edu.pe/conexion-esan/conoce-las-principales-distribuciones-de-probabilidad

Estadística Inferencial.

Técnicas de muestreo.

Las técnicas de muestreo son un conjunto de técnicas estadísticas que estudian la forma de seleccionar una muestra representativa de la población.

muestreo probabilístico

Es aquel en que todos los individuos de la población tienen una probabilidad de entrar a formar parte de la muestra (normalmente equiprobable, es decir, con la misma probabilidad).

Muestreo aleatorio simple

Muestreo estratificado

Muestreo sistemático

Muestreo en etapas múltiples

muestreo no probabilístico

Este utiliza métodos en los que no interviene el azar y por lo tanto, se desconoce la probabilidad asociada a cada individuo para formar parte de la muestra.

Muestreo de conveniencia.

Muestreo discrecional

Muestreo por cuotas.

Errores y sesgos.

Al seleccionar una muestra pueden cometerse dos tipos de errores:

Errores aleatorios

El error aleatorio corresponde a la diferencia entre el resultado obtenido a partir de la muestra y la realidad de la población.

Errores sistemáticos o sesgos

son los errores que se cometen en el procedimiento del estudio. Los sesgos no se modifican al aumentar el tamaño muestral. La definición de los distintos tipos de sesgos se limita a los errores relacionados con la validez interna de los estudios.

Tamaño muestral.

El tamaño muestral se refiere al número de observaciones o individuos que se toman de una población para realizar una inferencia acerca de dicha población.

Fórmulas para el cálculo de muestreo

calcular el tamaño de muestra en una población desconocida

n = (Z² * p * q) / E²

Donde:

n es el tamaño de muestra necesario

Z es el valor de la distribución normal estándar correspondiente al nivel de confianza deseado (por ejemplo, para un nivel de confianza del 95%, Z es 1,96)

p es la proporción estimada de la población que tiene la característica que se está midiendo

q es la proporción estimada de la población que NO tiene la característica que se está midiendo (q = 1 - p)

E es el margen de error deseado.

En el caso que la población que se desea estudiar sea finita y con un tamaño conocido (N) se utiliza la fórmula:

n = (N * Z² * p * q) / ((N - 1) * E² + Z² * p * q)

Donde:

n es el tamaño de muestra necesario

N es el tamaño de la población

Z es el valor de la distribución normal estándar correspondiente al nivel de confianza deseado

p es la proporción estimada de la población que tiene la característica que se está midiendo

q es la proporción estimada de la población que NO tiene la característica que se está midiendo (q = 1 - p)

E es el margen de error deseado.

Pruebas de contraste de hipotésis.

Pretende contraponer dos suposiciones contrarias (hipótesis) formuladas al principio de todo estudio: una a favor de la igualdad, bien sea de respuesta de tratamientos o hacia un valor conocido, y otra que establece la desigualdad entre la efectividad real de los tratamientos estudiados o entre el valor que le suponemos al inicio.

En los contrastes de hipótesis se pueden dar dos tipos de errores en función de lo que nos aporta nuestra muestra y lo que objetivamente está ocurriendo en la realidad.

Estos errores (o probabilidades) reciben el nombre de alfa y beta

ERROR ALFA

O tipo I, es el que se comete al rechazar la hipótesis nula H0

siendo cierta. Es decir, aceptamos que existen diferencias entre tratamientos cuando en realidad no las hay

Debe ser fijado a priori por los responsables del estudio, puesto que es el que marca el nivel de rechazo de la hipótesis nula.

ERROR BETA

O tipo II, es el error que se comete al aceptar la hipótesis nula H0 siendo falsa. Es decir, existe una diferencia real entre tratamientos pero no se ha podido rechazar la hipótesis nula.

Se ha definido como la probabilidad de rechazar la hipótesis

nula cuando ésta es falsa, es decir, la probabilidad de detectar diferencias entre tratamientos cuando realmente existen diferencias.

Análisis paramétrico y no paramétrico

Un parámetro es aquel que proporciona información para

analizar o valorar una situación, a partir de este se

muestra una determinada circunstancia que puede

entenderse o situarse en una perspectiva.

Análisis Paramétrico

Base de prueba estadística: Distribución

Tipo y Tamaño de muestra: Aleatoria >30 sujetos

Generalidades: -Se conoce el modelo de distribución de la población.

-Mientras más grande sea la muestra más exacta será la

estimación, mientras más pequeña, más distorsionada

será la media de las muestras.

-Las hipótesis se basan en valores numéricos,

especialmente en promedios.

Ventajas: -Más eficiencia.

-Poca probabilidad de errores.

-Sus estimaciones son exactas.

-Presentan sensibilidad a los rasgos de los datos

recogidos.

-Muestras grandes.

Desventajas:-Complejos de calcular.

-Presentan una limitación en los datos.

Nivel de medición: Datos en intervalo o razón.

Variables:Aplicable en variables nominales.

Valores perdidos: No se consideran una fuente de información.

Consideraciones: Debe contar con normalidad y homocedasticidad

Análisis No Paramétrico

Base de prueba estadística: Arbitrario

Tipo y Tamaño de muestra :No aleatoria

<30 sujetos

Generalidades; -Se desconoce cómo están distribuidos los datos.

-Se puede utilizar, aunque se desconozca los

parámetros de la población en estudio.

-Es utilizada para contrastar con la hipótesis.

-Las hipótesis se redactan sobre rangos, mediana o

frecuencia d ellos datos.

Ventajas: -Empleada en diferentes situaciones porque no

cumple con parámetros estrictos.

-Sus métodos son más afables.

-Se aplica en datos no numéricos.

-Muestras pequeñas.

Desventajas: -No son sistemáticas.

-Complica seleccionar la elección correcta.

-Provoca confusión.

-Requiere fuentes y respaldo.

-Probabilidad de errores.

-No hay exactitud.

Nivel de medicion: Datos ordinales o nominales.

Variables: Aplicable en variables categóricas.

Variables perdidos: Se consideran una fuente de información.

Consideraciones :Menor presunción y alcance más amplio.

Topic principal

Se pueden definir tres tipos según el origen:

Sesgos de selección

Se refiere a la distorsión en la estimación del efecto derivada de la forma en que se han seleccionado los sujetos de la muestra. La muestra no refleja adecuadamente a la población, es decir, que la variable medida es diferente entre los pacientes participantes en el estudio y los no participantes (edad, sexo,...).

Sesgos de información

Aparecen cuando existen diferencias sistemáticas en la manera en que los datos sobre la exposición o el efecto son obtenidos en los diferentes grupos de estudio.

Sesgos de confusión

Se presenta cuando el efecto de la intervención de estudio se confunde con el efecto de uno o más factores de confusión (edad, nivel de estudios, ...).

El tamaño muestral necesario para una inferencia depende de varios factores, como el nivel de confianza deseado, el margen de error permitido, la variabilidad de la población y el tamaño de la población.

El error aleatorio se debe en mayor parte al azar y no afecta a la validez interna del resultado, pero puede disminuir la probabilidad de encontrar relación entre las variables estudiadas. Aunque el error aleatorio no puede eliminarse a no ser que se estudie a toda la población; aumentando el tamaño de la muestra y la precisión de las mediciones puede disminuirse dicho error.