作者:Bella Villalobos 5 年以前

498

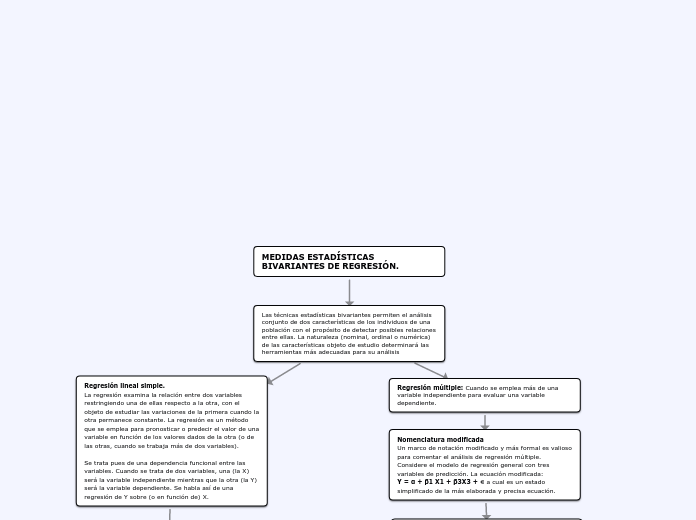

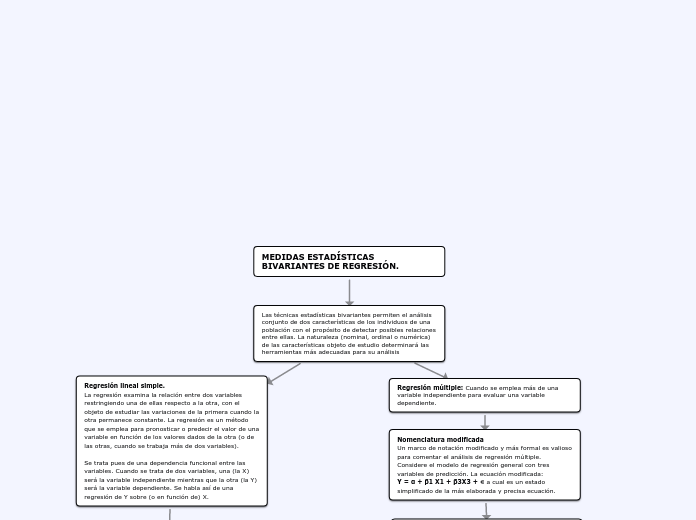

MEDIDAS ESTADÍSTICAS BIVARIANTES DE REGRESIÓN.

作者:Bella Villalobos 5 年以前

498

更多类似内容

Supuesto de multicolinealidad: Condición existente en un análisis de regresión múltiple, que consiste en que las variables de predicción no son independientes unas de otras, como se requiere, sino que están correlacionadas.

Coeficientes de regresión parcial: Coeficientes de regresión parcial es cuando existe multicolinealidad, Simplemente no resulta válida la interpretación “normal” de esos coeficientes, como “el cambio promedio de la variable de criterio relacionado con el cambio unitario de la variable de predicción apropiada cuando se mantienen constantes las demás variables de predicción“. La ecuación todavía sería útil para fines de predicción, en el supuesto de que las condiciones sean estables. Empero, no deben usarse los coeficientes de regresión parcial como base para la toma de decisiones mercadológicas estratégicas cuando es significativa la multicolinealidad

Coeficientes de correlación múltiple y de determinación múltiple Es el análisis de determinación múltiple, la proporción de variación en la variable de criterio que se explica con la covariación de las variables predictivas.

Coeficientes de correlación parcial: Cantidad que resulta del análisis de regresión múltiple e indica la proporción de variación de la variable de criterio que no se explica con una o más variables previas y sí con la inclusión de una nueva variable a la ecuación de regresión.

Variables binarias: Una a la que se asigna uno de dos valores, 0 o 1, y se usa para representar en forma numérica los atributos o características que no son esencialmente cuantitativos.

Trasformaciones de variables: Es una transformación de variable es simplemente un cambio en la escala con que se expresa una variable dada.

Una función y = f(x) se dice que es lineal en X si la variable X aparece con potencia unitaria (por tanto, se excluyen términos como x2, x3, 1/x, √x, por ejemplo) y no está multiplicada ni dividida por otra variable. Por ejemplo, yj = a + bxi + cxi2 no es una función lineal en las variables puesto que la variable X aparece elevada al cuadrado

Se dice que una función es lineal en los parámetros si éstos aparecen con frecuencia unitaria y no están multiplicados ni divididos por cualquier otro parámetro. A modo de ejemplo, yj = a + √bxi no es una función lineal en los parámetros. Sin embargo, yj = a + bxi + cxi2 sí lo es.

De las dos interpretaciones de linealidad, la linealidad en los parámetros es la más relevante en el contexto de la teoría de la regresión y de la correlación. Sin embargo, en lo que sigue, se exigirá tanto la linealidad en los parámetros como en las variables para que la regresión sea calificada de linea

COEFICIENTE DE DETERMINACIÓN LINEAL Una vez elegida la función rectilínea para representar la relación de dependencia de Y sobre X y estimados sus parámetros a y b, a continuación se procede al cómputo del coeficiente de determinación lineal con objeto de medir el grado de dependencia de Y sobre X bajo la función de regresión lineal estimada.