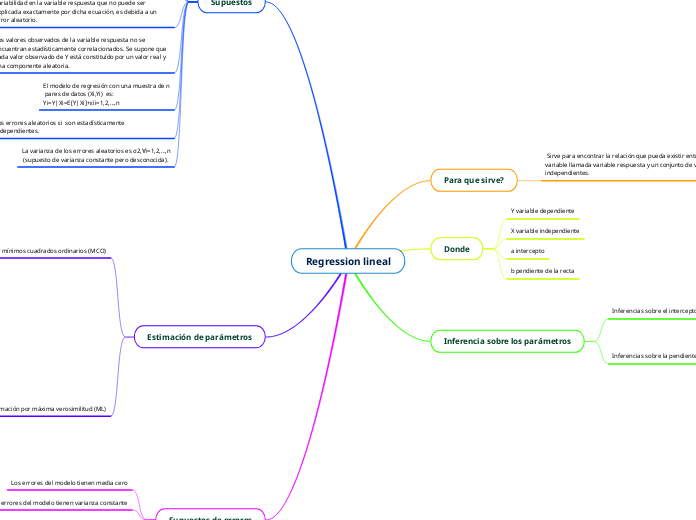

Regression lineal

Para que sirve?

Sirve para encontrar la relación que pueda existir entre una variable llamada variable respuesta y un conjunto de variables independientes.

Donde

Y variable dependiente

X variable independiente

a intercepto

b pendiente de la recta

Inferencia sobre los parámetros

Inferencias sobre el intercepto β0

Intervalos de confianza

Prueba de Hipótesis sobre la significancia del intercepto

Inferencias sobre la pendiente β1

Intervalos de confianza

Prueba de Hipótesis sobre la significancia de la pendiente

Supuestos

La variable respuesta Y es una variable aleatoria cuyos valores se observan mediante la selección de los valores de la variable predictora X en un intervalo de interés.

la variable predictora X

no es considerada como variable aletatoria, sino como un conjunto de valores fijos que representan los puntos de observación, que se seleccionan con anticipación y se miden sin error

Los datos observados (xi,yi), i=1,…,n, constituyen una muestra representativa de un medio acerca del cual se desea generalizar. Si no es así, no es apropiado realizar inferencias en un rango de los datos por fuera del considerado.

El modelo de regresión es lineal en los parámetros. Es decir, ningún parámetro de la regresión aparece como el exponente o es dividido o multiplicado por otro parámetro, o cualquier otra función.

Si la ecuación de regresión seleccionada es correcta, cualquier variabilidad en la variable respuesta que no puede ser explicada exactamente por dicha ecuación, es debida a un error aleatorio.

Los valores observados de la variable respuesta no se encuentran estadísticamente correlacionados. Se supone que cada valor observado de Y está constituído por un valor real y una componente aleatoria.

El modelo de regresión con una muestra de n

pares de datos (Xi,Yi) es:

Yi=Y|Xi=E[Y|Xi]+εii=1,2,…,n

Los errores aleatorios εi son estadísticamente independientes.

La varianza de los errores aleatorios es σ2,∀i=1,2,…,n

(supuesto de varianza constante pero desconocida).

Estimación de parámetros

Estimación por mínimos cuadrados ordinarios (MCO)

Obtener estimaciones de los parámetros de regresión, es decir hallar valores de β0 y β1 que minimicen la suma de los cuadrados de los errores S(β0,β1)

Tiene propiedades

βˆ0 y βˆ1 son combinaciones lineales de las variables aleatorias Y1,…,Yn

La suma de los residuales del modelo de regresión con intercepto es siempre cero

La suma de los valores observados yi

es igual a la suma de los valores ajustados yˆi

La línea de regresión siempre pasa a través del centroide de los datos (x¯,y¯)

La suma de los residuales ponderados por el correspondiente valor de la variable predictora es cero

Estimación por máxima verosimilitud (ML)

es un método habitual para ajustar un modelo y estimar sus parámetros

Tiene propiedades

Consistencia

Normalidad asintótica

Eficiencia

Supuestos de errores

Los errores del modelo tienen media cero

Los errores del modelo tienen varianza constante

Los errores del modelo se distribuyen normal

Los errores del modelo son independientes