von JOCELYN GUADALUPE cabezar romero Vor 3 Jahren

371

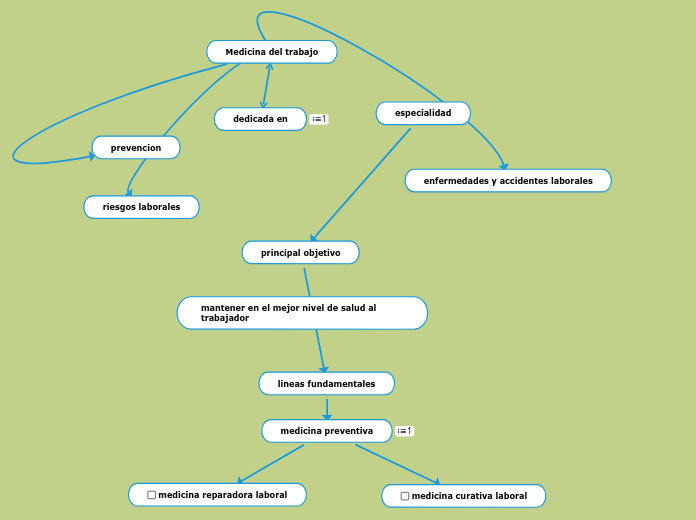

medicina del trabajo

La medicina del trabajo es una rama de la medicina que se centra en la prevención y tratamiento de enfermedades y accidentes asociados con el entorno laboral. Su objetivo principal es mantener a los trabajadores en el mejor nivel de salud posible, mediante la implementación de estrategias y prácticas que minimicen los riesgos laborales.