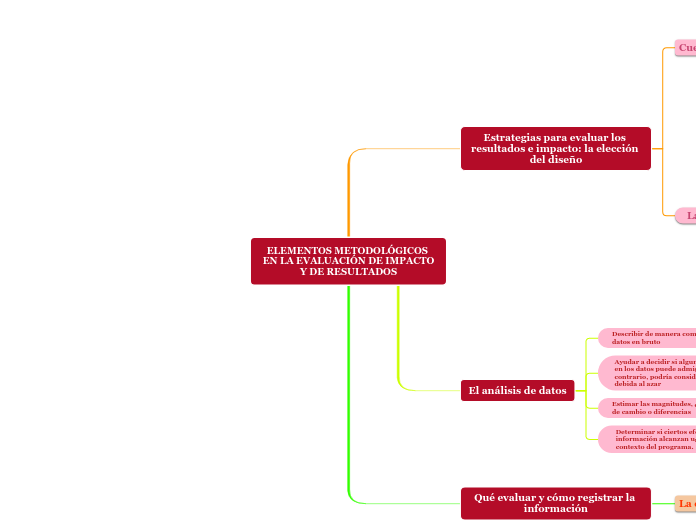

ELEMENTOS METODOLÓGICOS EN LA EVALUACIÓN DE IMPACTO

Y DE RESULTADOS

Qué evaluar y cómo registrar la información

La evaluación de resultados

Para describir y evaluar dichos cambios es clave que se

hayan definido adecuadamente los objetivos generales y específicos del programa

Las medidas de las variables y/o condiciones sociales que el programa espera cambiar constituyen las variables dependientes

El análisis de datos

Determinar si ciertos efectos que aparecen en la información alcanzan un nivel relevante en el contexto del programa.

Estimar las magnitudes, especialmente cantidades de cambio o diferencias

Ayudar a decidir si alguna relación aparente

en los datos puede admitirse con confianza o, por el contrario, podría considerarse una relación espuria debida al azar

Describir de manera comprensiva conjuntos de datos en bruto

Estrategias para evaluar los resultados e impacto: la elección del diseño

La elección del diseño

Diseños cualitativos o naturalistas

Deben dar dos supuestos

b) Que no existan variables extrañas específicas de los grupos formados, algo que puede ocurrir sobre todo cuando se utilizan como punto de corte puntuaciones extremas.

a) Que la relación entre las variable criterio y los pronósticos (VD o indicadores) de ambos grupos tengan las misma función (lineal)

Diseños cuasi-experimentales

Aplicarse tanto a programas de cobertura parcial, como a programas de cobertura total donde el programa cubre a toda la población diana.

Diseños experimentales

Experimentales se caracterizan por el control que tiene el evaluador de la variable independiente (el programa objeto de evaluación) y por la asignación aleatoria de los participantes a los grupos o condiciones de intervención y de comparación con base en algún criterio determinado para controlar el efecto de variables extrañas que pudieran contaminar los resultados de la evaluación.

Cuestiones de validez

Conclusión estadística

Grado de confianza sobre la presencia de covariación entre variables.

Constructo

Correspondencia entre los conceptos utilizados y la operativización de los mismos.

Externa

Generalización de los resultados a diferentes situaciones, participantes, programas o contextos similares.

Interna

Grado de seguridad que tenemos a la hora de atribuir los cambios al programa de intervención y no a otras causas.