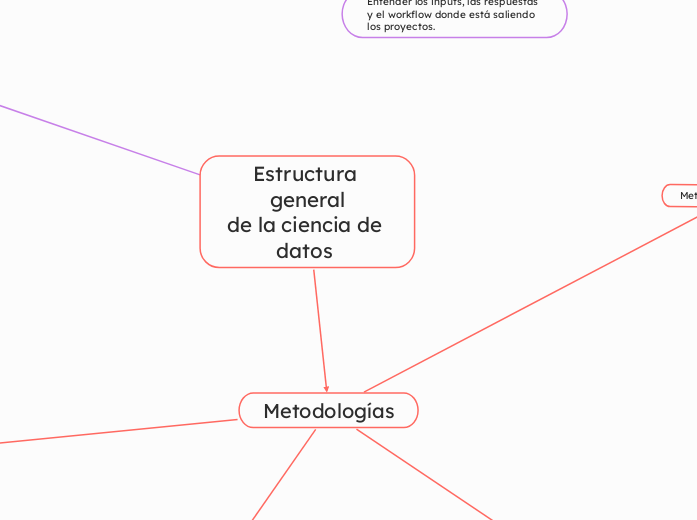

Estructura general

de la ciencia de datos

Experiecnia del experto

Danny Lenis: estadista, y experto en ciencia de datos y análisis para el sector financiero.

Nos comparto información sobre SCORING en el sector financiero, y evaluación de riesgo para cubrir posibles perdidas crediticias por prestamos a perfiles según su Score crediticio.

1.Latencia de respuesta

Consultas desde otro Sistema de información

Desarrollo metodologíco, para implementar el modelo

Tiempos de ejecución dentro del modelo

Entender los inputs, las respuestas y el workflow donde está saliendo los proyectos.

Metodologías

Metodología CRISP-DM

Es la metodología más utilizada. Se centra en un proceso iterativo con seis fases: comprensión del negocio, comprensión de los datos, preparación de los datos, modelado, evaluación y despliegue.

1-Comprensión del Negocio

Esta fase inicial se centra en comprender los objetivos y requisitos del proyecto desde una perspectiva de negocio. Se define el problema a resolver, se identifican las metas y objetivos, se determinan los criterios de éxito y se establecen las restricciones del proyecto.

2.Comprensión de los Datos

En esta fase se recopilan los datos necesarios para el proyecto y se realiza un análisis exploratorio para comprender sus características. Se identifican las fuentes de datos, se evalúa la calidad de los datos, se describen las variables y se exploran las relaciones entre ellas. Se pueden utilizar técnicas de visualización y estadística descriptiva para obtener una visión general de los datos.

3.Preparación de los Datos

Esta fase, a menudo la más larga y laboriosa del proceso, implica la limpieza, transformación y preparación de los datos para la fase de modelado. Se manejan los valores faltantes, se eliminan los datos inconsistentes o erróneos, se transforman las variables (normalización, estandarización, etc.), se crean nuevas variables y se seleccionan las variables más relevantes para el modelo.

4.Modelado

En esta fase se seleccionan y aplican las técnicas de modelado más adecuadas para el problema de negocio. Se pueden probar diferentes algoritmos y comparar su rendimiento para seleccionar el modelo más efectivo.

5.Evaluación

Antes de desplegar el modelo, se evalúa su rendimiento utilizando métricas apropiadas. Se verifica la precisión, la estabilidad, la generalización y la interpretabilidad del modelo. Se asegura que el modelo cumpla con los criterios de éxito definidos en la fase de comprensión del negocio.

6.Despliegue

En la fase final, se despliega el modelo en un entorno de producción para que pueda ser utilizado para tomar decisiones o generar predicciones. Se implementa el modelo en un sistema, se documenta el proceso y se proporciona formación a los usuarios.

Metodología Agile para Ciencia de Datos

Adaptación de la metodología Agile al desarrollo de proyectos de ciencia de datos. Se basa en ciclos iterativos (sprints) que permiten una mayor flexibilidad y adaptación a los cambios.

Es claro que hay una estructura metodología sobre este tipo de proyectos, que implica

Desde mi punto de vista las metodologías más exitosas comprenden la inclusión de la perspectiva de negocio/onbejetivo de investigación para llevar a cabo un proyecto que no sea determinista y responda a una necesidad o realidad del negocio. como en el caso de SCRUM

Procesos

Infraestructruas

Personas

Metodología SEMMA

1. Muestreo (Sample)

2.Exploración (Explore)

3.Modificación (Modify)

4.Modelado (Model)

5. Evaluación (Assess)

En la etapa final, se evalúa el rendimiento de los modelos generados en la etapa anterior. Se utilizan métricas apropiadas para medir la precisión, la estabilidad y la generalización del modelo.

Aquí se aplican diferentes técnicas de modelado para descubrir patrones y relaciones en los datos. Se seleccionan los algoritmos de modelado más adecuados en función del objetivo del análisis (predicción, clasificación, segmentación, etc.) y de las características de los datos. Se pueden probar diferentes modelos y comparar su rendimiento para seleccionar el más adecuado. Algunos ejemplos de técnicas de modelado incluyen árboles de decisión, redes neuronales, regresión logística y clustering.

En esta etapa, se preparan los datos para la fase de modelado. Esto puede implicar la transformación de variables, la creación de nuevas variables a partir de las existentes, la selección de las variables más relevantes, el tratamiento de valores faltantes y la eliminación de datos ruidosos o inconsistentes. El objetivo es mejorar la calidad de los datos y optimizarlos para los algoritmos de modelado.

Esta etapa se centra en comprender las características de los datos. Se utilizan técnicas de visualización y estadística descriptiva para identificar patrones, tendencias, relaciones entre variables y posibles valores atípicos. Algunas técnicas comunes incluyen histogramas, diagramas de dispersión, matrices de correlación y análisis de componentes principales.

En esta primera etapa, se extrae una muestra representativa de los datos originales. Trabajar con una muestra, especialmente cuando se trata de grandes conjuntos de datos, reduce el tiempo de procesamiento y los recursos computacionales necesarios, al tiempo que mantiene la información esencial para el análisis.

(Sample, Explore, Modify, Model, Assess): Metodología de SAS Institute. Se centra en el muestreo, exploración, modificación, modelado y evaluación de datos.

Metodología KDD

1. Selección (Selection)

2.Preprocesamiento (Preprocessing)

3. Transformación (Transformation)

4.Minería de Datos (Data Mining)

5.Interpretación/Evaluación(Interpretation/Evaluation)

En esta etapa final, se interpretan los patrones y modelos descubiertos en la etapa de minería de datos.

Esta es la etapa central del proceso KDD. Se aplican algoritmos de minería de datos para extraer patrones y modelos a partir de los datos transformados. La elección del algoritmo depende del tipo de problema a resolver (clasificación, regresión, clustering, etc.) y de las características de los datos.

Aquí, los datos preprocesados se transforman o consolidan en formas apropiadas para la minería de datos. Esto puede implicar la creación de nuevas variables a partir de las existentes, la reducción de la dimensionalidad mediante técnicas como el Análisis de Componentes Principales (PCA), o la discretización de variables continuas.

En esta fase se limpian y preparan los datos seleccionados. Se manejan los valores faltantes, se eliminan los datos inconsistentes o erróneos, se resuelven las inconsistencias y se tratan los datos ruidosos. El objetivo es mejorar la calidad de los datos para las etapas posteriores. Algunas tareas comunes incluyen:

Limpieza de datos: Corrección de errores, eliminación de duplicados, tratamiento de valores atípicos.

Integración de datos: Combinación de datos de diferentes fuentes.

Transformación de datos: Normalización, estandarización, discretización.

Reducción de datos: Selección de características, reducción de dimensionalidad.

Esta etapa implica la creación de un conjunto de datos objetivo a partir de los datos brutos. Se define el problema a resolver y se seleccionan las fuentes de datos relevantes para el mismo. Esto incluye la selección de variables, la definición del alcance del dataset y la creación de un subconjunto de datos manejable.

(Knowledge Discovery in Databases): Proceso para la extracción de conocimiento a partir de grandes cantidades de datos. Sus etapas son: selección, preprocesamiento, transformación, minería de datos e interpretación/evaluación.