por dr inż. Michał Malinowski hace 2 meses

66

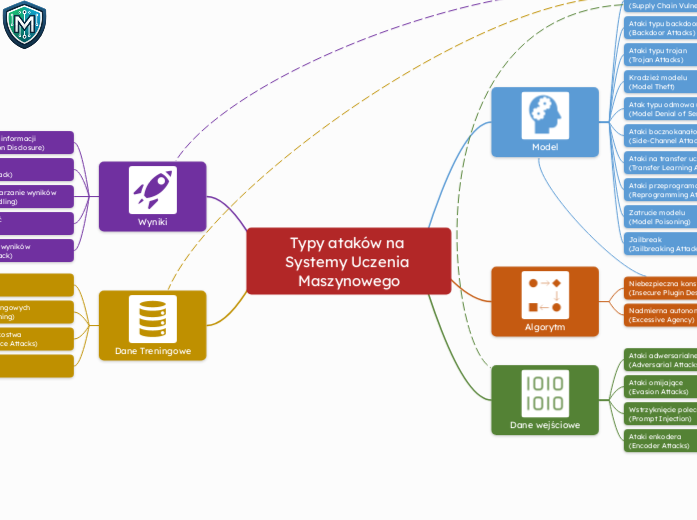

Typy ataków na Systemy Uczenia Maszynowego

Systemy uczenia maszynowego są narażone na różnorodne ataki, które mogą znacznie obniżyć ich bezpieczeństwo i funkcjonalność. Do głównych zagrożeń należą ataki typu trojan, które wprowadzają złośliwy kod do modeli; ataki typu backdoor, które umożliwiają nieautoryzowany dostęp; oraz kradzież modeli, gdzie atakujący kopiuje model bez wiedzy właściciela.