El primer teorema de Shannon muestra que (en el límite en el que una cadena de variables aleatorias independientes e idénticamente distribuidas de datos tiende a infinito) es imposible comprimir la información de forma que la relación de codificación (número medio de bits por símbolo) es menor que la entropía de Shannon de la fuente, si se garantiza que no haya pérdida de información.

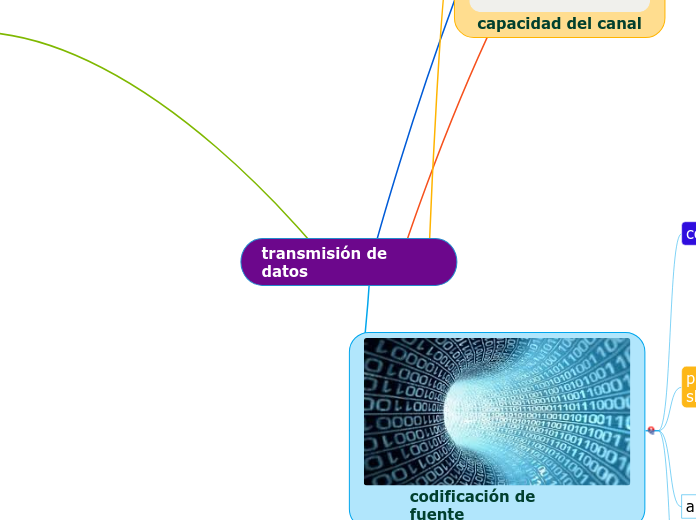

transmisión de datos

El canal ruidoso

puesto que este teorema conjuntamente con la obra de Claude Shannon sobre la teoría de la información, tuvieron una importancia fundamental en la teoría de la información, ofreciendo anchas aplicaciones en los dominios de las telecomunicaciones y del almacenamiento de información.

es un teorema, matemático enunciado por Claude Shannon , que muestra que es posible transmitir datos discretos (información digital) casi sin errores sobre un mismo canal ruidoso, a un régimen máximo computable.

Segundo teorema

codificación de fuente

entropia de un proceso estocastico

Un proceso estocástico {\displaystyle \{X_{i}\}}{\displaystyle \{X_{i}\}} es una secuencia indexada de variables aleatorias. En general, puede haber dependencias entre las variables aleatorias. Para estudiar la probabilidad de cierto conjunto de valores se suele adoptar el siguiente convenio:

Pr[(X1,X2 • • • ,Xn) = (Xl, X2, • • • , Xn)] = P(Xl, X2, • • • , Xn)

algoritmo huffman

El algoritmo de Huffman se usa para la creación de códigos de Huffman, desarrollado por David A. Huffman.

Es una técnica para la compresión de datos, en otras palabras, busca reducir la cantidad de datos o espacio de memoria para crear un mensaje.

En este algoritmo es necesario el uso de un alfabeto con n caracteres finitos. Por la tanto, debes tener en cuenta que tipo de símbolos se podrán tener. Con esto, se sacan las frecuencias que hay de cada letra en el mensaje y con ello se crea un código para cada una de ellas y finalmente se unen para crear la nueva versión del mensaje.

primer teorema de shanon

el primer teorema de Shannon o, menos utilizado, teorema de codificación sin ruido es un teorema enunciado por Claude Shannon en 1948 que establece el límite teórico para la compresión de una fuente de datos,así como el significado operacional de la entropía de Shannon.

código de bloque

El principio que se utiliza en los códigos de bloque consiste en estructurar los datos en bloques de longitud fija y añadir a cada bloque un cierto número de bits llamados bits de redundancia.

Sólo ciertas combinaciones de bits son aceptables y forman una colección de palabras de código válidas.

calculo de la capacidad

C=Blog_{2}(1+S/R)\,} (bps) o bits por segundo

Canal binario simétrico• p(r0|s0)=1-pe• p(r0|s1)=pe• p(r1|s0)=pe• p(r1|s1)=1-pe• p(r0,s0)=p(r0|s0)p(s0)=(1-pe)p(s0)• p(r1,s0)=pep(s0)• p(r0,s1)=pep(s1)=pe(1-p(s0))• p(r1,s1)=(1-pe)(1-p(s0))

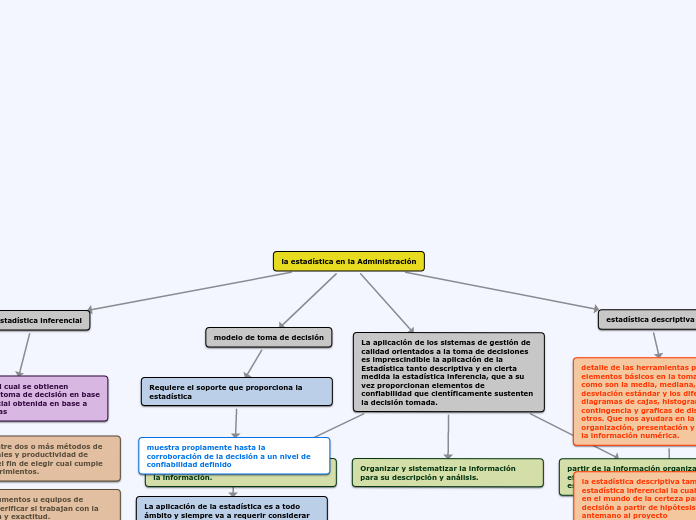

capacidad del canal

La capacidad del canal se mide en bits por segundo (bps) y depende de su ancho de banda y de la relación S/N (Relación señal/ruido).

La capacidad del canal limita la cantidad de información (se denomina régimen binario y se mide en bits por segundo, bps) que puede trasmitir la señal que se envía a través de él.

informacion mutua

En teoría de la probabilidad, y en teoría de la información, la información mutua o transinformación de dos variables aleatorias es una cantidad que mide la dependencia mutua de las dos variables, es decir, mide la reducción de la incertidumbre (entropía) de una variable aleatoria, X, debido al conocimiento del valor de otra variable aleatoria Y

La información mutua media mide la información mutua media que se produce entre los distintos valores de dos variables aleatorias. Para ello proporcionamos un peso a los valores de I ( Xi ; Yj ) sobre la base de la probabilidad de ocurrencia.