av ANGIE GOMEZ GOMEZ för 9 årar sedan

237

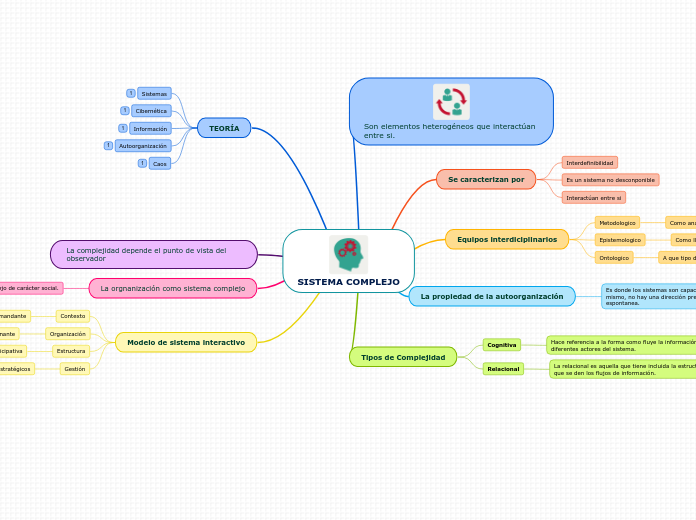

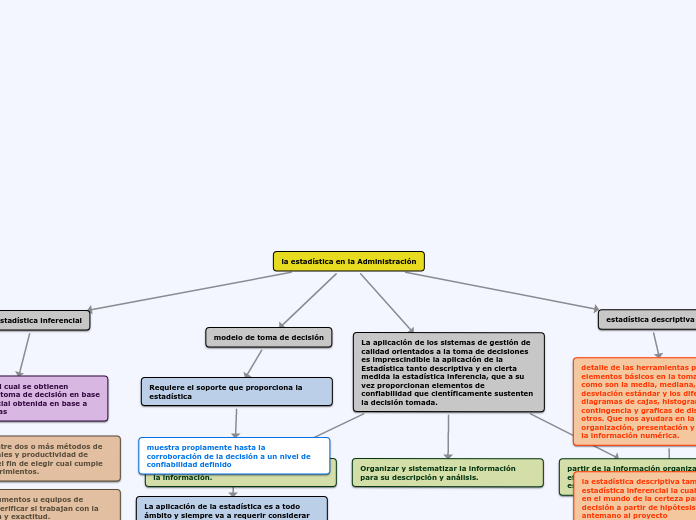

Teoria De La Información

La obtención de información de manera eficiente y precisa es esencial para la toma de decisiones y resolución de problemas. La información debe ser clara y exacta, y su calidad se evalúa comparando los hechos descritos con la realidad.