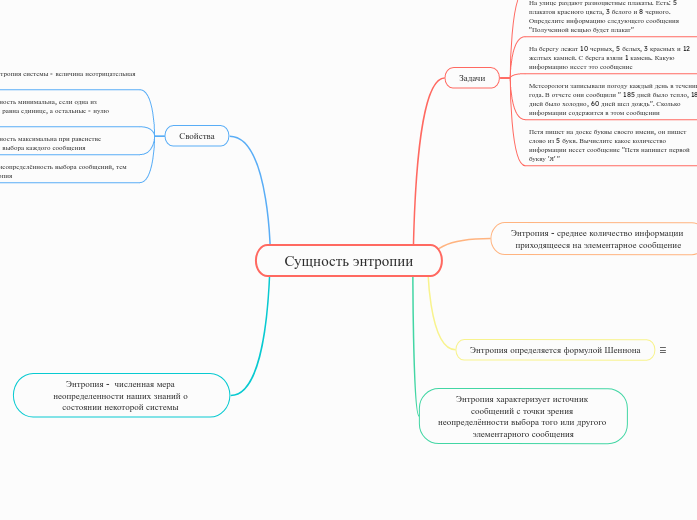

Сущность энтропии

Энтропия - численная мера неопределенности наших знаний о состоянии некоторой системы

Свойства

Чем больше неопределённость выбора сообщений, тем больше энтропия

Неопределённость максимальна при равенстве вероятностей выбора каждого сообщения

Неопределённость минимальна, если одна из вероятностей равна единице, а остальные - нулю

Энтропия системы - величина неотрицательная

Энтропия характеризует источник сообщений с точки зрения неопределённости выбора того или другого элементарного сообщения

Энтропия определяется формулой Шеннона

H=−∑i=1NPi⋅log2Pi

Энтропия - среднее количество информации приходящееся на элементарное сообщение

Задачи

Петя пишет на доске буквы своего имени, он пишет слово из 5 букв. Вычислите какое количество информации несет сообщение "Петя напишет первой букву 'Я' "

Метеорологи записывали погоду каждый день в течении года. В отчете они сообщили " 185 дней было тепло, 180 дней было холодно, 60 дней шел дождь". Сколько информации содержится в этом сообщении

На берегу лежат 10 черных, 5 белых, 3 красных и 12 желтых камней. С берега взяли 1 камень. Какую информацию несет это сообщение

На улице раздают разноцветные плакаты. Есть: 5 плакатов красного цвета, 3 белого и 8 черного. Определите информацию следующего сообщения "Полученной вещью будет плакат"

В классе 5 человек. За контрольную было получено 2 пятерки, 2 тройки и 1 четверка. Какое количество информации несет в себе сообщение, что ученик получил 5