jonka дима сутугин 3 kuukautta sitten

29

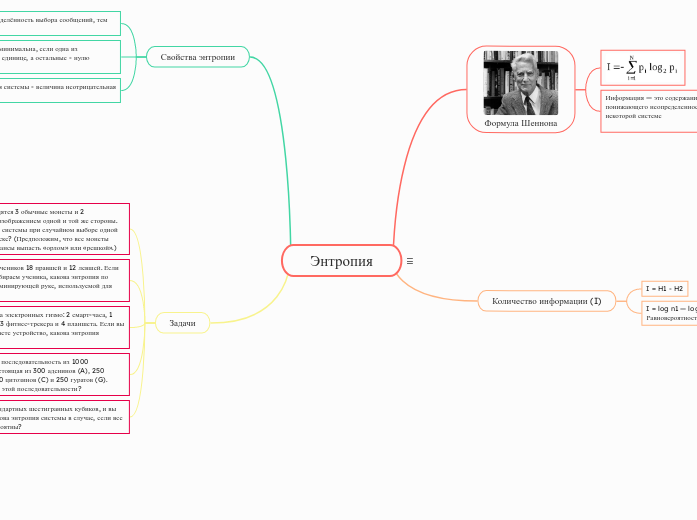

Энтропия

Энтропия является численной мерой неопределенности знаний о состоянии системы или источника сообщений. Она обозначается как H(X) и измеряет степень неопределенности, связанной с вероятностным распределением возможных исходов.