jonka LE BRAS Yves 10 vuotta sitten

297

Culturomics

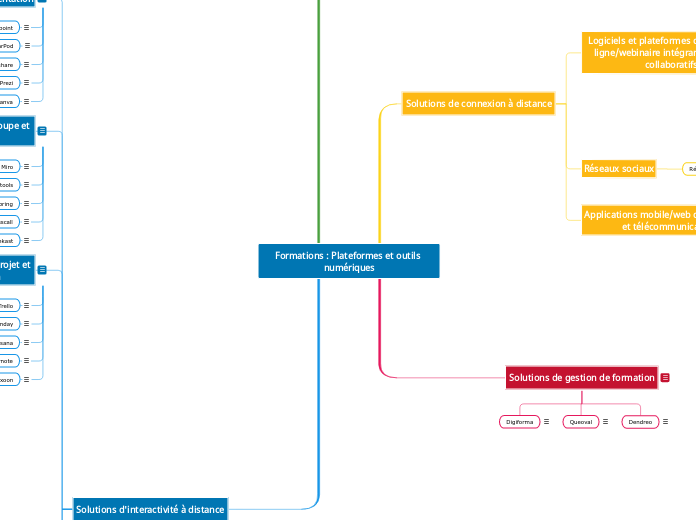

L'utilisation du numérique révolutionne la manière dont nous accédons et analysons les données culturelles. Des outils comme myPeers permettent de suivre les publications de ses collègues chercheurs, tandis que des sites tels que Google Public Data et des initiatives comme OpenData Rennes facilitent l'