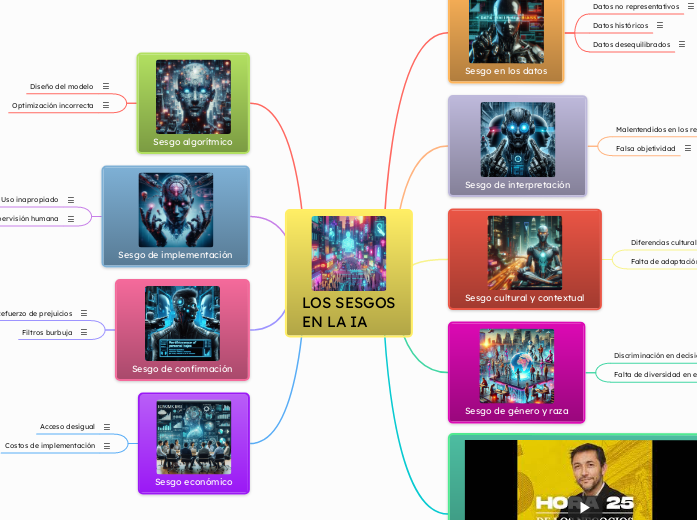

LOS SESGOS

EN LA IA

Sesgo económico

Costos de implementación

Las tecnologías de IA pueden ser costosas, lo que limita su acceso a organizaciones o individuos con más recursos.

Acceso desigual

Los sistemas de IA pueden beneficiar desproporcionadamente a ciertos grupos socioeconómicos, exacerbando las desigualdades existentes.

Sesgo de confirmación

Filtros burbuja

En sistemas de recomendación (como redes sociales o plataformas de contenido), la IA puede crear "burbujas" que refuerzan las opiniones y preferencias existentes, limitando la exposición a perspectivas diversas.

Refuerzo de prejuicios

La IA puede reforzar creencias o estereotipos existentes al proporcionar resultados que confirman las expectativas previas de los usuarios.

Sesgo de implementación

Falta de supervisión humana

Si no se supervisa adecuadamente el uso de la IA, los sesgos pueden pasar desapercibidos y tener consecuencias negativas.

Uso inapropiado

La IA puede aplicarse en contextos para los que no fue diseñada, lo que puede exacerbar los sesgos existentes.

Sesgo algorítmico

Optimización incorrecta

Si el modelo se optimiza para maximizar una métrica específica (por ejemplo, precisión general), puede ignorar el rendimiento en subgrupos minoritarios o desfavorecidos.

Diseño del modelo

Los algoritmos pueden estar diseñados de manera que favorezcan ciertos resultados sobre otros, incluso sin intención explícita.

Sesgo político

Empezar en 12:47

Sesgo de género y raza

Falta de diversidad en el desarrollo

Si los equipos que desarrollan la IA no son diversos, es más probable que se pasen por alto ciertos sesgos.

Discriminación en decisiones:

La IA puede perpetuar o amplificar la discriminación de género o raza, especialmente en áreas como contratación, préstamos o vigilancia.

Sesgo cultural y contextual

Falta de adaptación

La IA puede no tener en cuenta las diferencias regionales, lingüísticas o sociales, lo que puede resultar en exclusiones o discriminaciones.

Diferencias culturales

Los modelos entrenados en un contexto cultural pueden no ser adecuados para otros, lo que puede llevar a interpretaciones o decisiones sesgadas.

Sesgo de interpretación

Falsa objetividad

Se puede asumir erróneamente que las decisiones de la IA son completamente objetivas, cuando en realidad están influenciadas por los sesgos presentes en los datos, el diseño u otros.

Malentendidos en los resultados

Los usuarios pueden interpretar incorrectamente los resultados de la IA, especialmente si no se entienden las limitaciones del modelo o los datos.

Sesgo en los datos

Datos desequilibrados

Cuando ciertos grupos o categorías están sobrerrepresentados o subrepresentados en los datos, el modelo puede volverse menos preciso para esos grupos.

Datos históricos

Los datos históricos pueden contener prejuicios humanos (por ejemplo, discriminación racial, de género o socioeconómica), que la IA puede perpetuar o amplificar.

Datos no representativos

Si los datos de entrenamiento no reflejan adecuadamente la diversidad de la población o el contexto en el que se aplicará la IA, el modelo puede generar resultados sesgados.