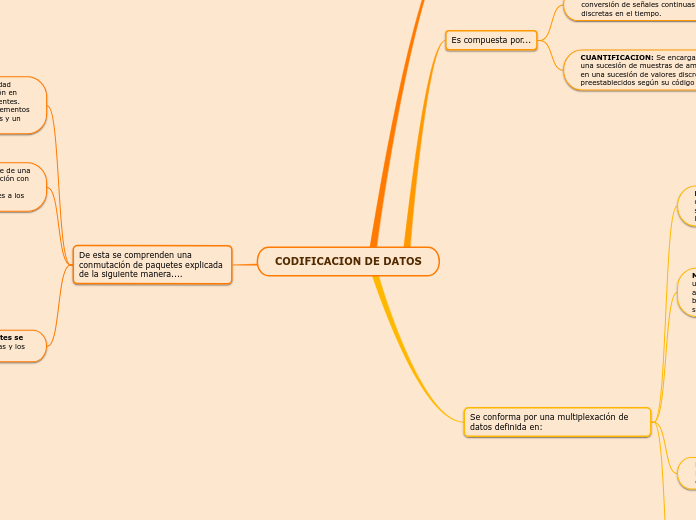

Codificación De Caracteres

Método que permite convertir un caracter de un lenguaje natural (alfabeto o silabario) en un símbolo de otro sistema de representación

Tipos principales de codificación

METODOS DE MAPEO UNICODE

UCS (Universal Character Set)

UCS-4 —un par de codificaciones de 32 bits similar al UTF-32

UCS-2 — codificación de 16 bits de longitud fija

UTF (Unicode Transformation Format)

UTF-32 — un par de codificaciones de 32 bits

UTF-16 — una codificación de 16 bits de longitud variable

UTF-8 — una codificación de 8 bits de longitud variable

UTF-7 — 7 bits, a menudo considerada obsoleta.

UNICODE

Asigna un código único a cada carácter utilizado en los lenguajes escritos del mundo

Proporciona el medio por el cual un texto en cualquier forma e idioma pueda ser codificado para el uso informático

ASCII

EXTENDIDO

Utilizan parte o la totalidad de los códigos superiores a 128 para codificar caracteres adicionales a los caracteres imprimibles ASCII

coinciden con los los caracteres comúnmente llamados "de espacio"

Juego de caracteres de 8 bits en el cual los códigos 32 a 126 (0x20 a 0x7E)

ASCII

En la actualidad define códigos para 33 caracteres no imprimibles, de los cuales la mayoría son caracteres de control obsoletos que tienen efecto sobre cómo se procesa el texto

ASCII define una relación entre caracteres específicos y secuencias de bits

Cadenas de bits representables con siete dígitos binarios (que van de 0 a 127 en base decimal)

Utiliza 7 bits para representar los caracteres