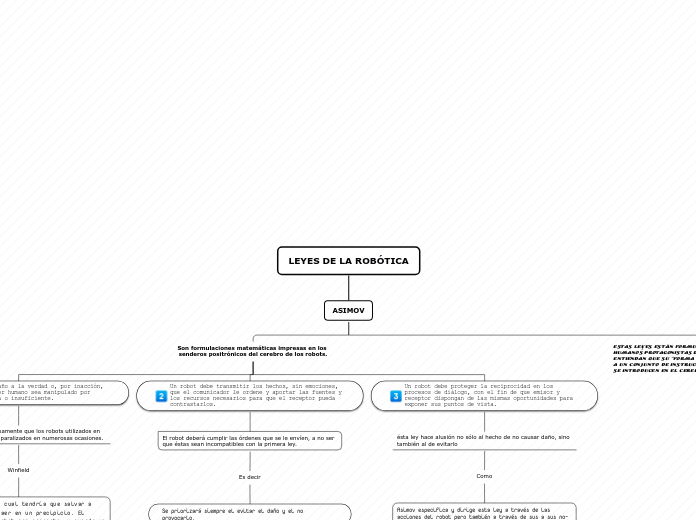

LEYES DE LA ROBÓTICA

ASIMOV

Estas leyes están formuladas de tal forma que los humanos protagonistas de las historias de Asimov, entiendan que su “forma real” en realidad equivale a un conjunto de instrucciones más complejas que se introducen en el cerebro del robot.

Son formulaciones matemáticas impresas en los senderos positrónicos del cerebro de los robots.

Un robot debe proteger la reciprocidad en los procesos de diálogo, con el fin de que emisor y receptor dispongan de las mismas oportunidades para exponer sus puntos de vista.

ésta ley hace alusión no sólo al hecho de no causar daño, sino también al de evitarlo

Como

Asimov especifica y dirige esta ley a través de las acciones del robot pero también a través de sus a sus no-acciones

Llamada

la inacción

por ejemplo

Los coches autónomos: Si el coche va a chocar contra otro, él mismo debería apartarse aunque esté circulando correctamente, para no causar daño, siguiendo la primera ley .

Un robot debe transmitir los hechos, sin emociones, que el comunicador le ordene y aportar las fuentes y los recursos necesarios para que el receptor pueda contrastarlos.

El robot deberá cumplir las órdenes que se le envíen, a no ser que éstas sean incompatibles con la primera ley.

Es decir

Se priorizará siempre el evitar el daño y el no provocarlo.

Por ejemplo

Los coches que sean autónomos, si la persona detrás del quiere tomar el mando, lo hará.

como

Un dron que esté programado para operar por su cuenta, si quien lo vigila decide tomar el control.

Un robot no hará daño a la verdad o, por inacción, permitirá que un ser humano sea manipulado por información sesgada o insuficiente.

Esta ley provocaba precisamente que los robots utilizados en las pruebas se quedaran paralizados en numerosas ocasiones.

Winfield

Programó un robot el cual tendría que salvar a otros autómatas de caer en un precipicio. El comportamiento del robot era correcto, y cuando un solo "humano" iba a caer, el robot lo evitaba rápidamente.

pero

El problema surgía cuando había dos "humanos" en dirección al precipicio al mismo tiempo. En ese caso, el robot se veía forzado a elegir. Unas veces lograba salvar a uno de los dos e incluso a los dos, pero en 14 de las 33 pruebas el robot se quedó literalmente paralizado