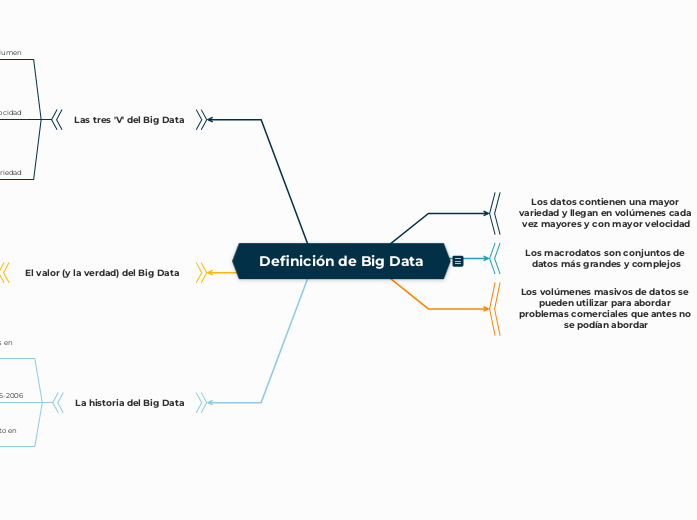

Definición de Big Data

Definición de Big Data

¿Qué es exactamente el big data?

La definición de big data es que los datos contienen una mayor variedad y llegan en volúmenes cada vez mayores y con mayor velocidad. Esto también se conoce como las tres "V".

En pocas palabras, los macrodatos son conjuntos de datos más grandes y complejos, especialmente de nuevas fuentes de datos. Estos conjuntos de datos son tan voluminosos que el software de procesamiento de datos tradicional simplemente no puede gestionarlos. Pero estos volúmenes masivos de datos se pueden utilizar para abordar problemas comerciales que antes no habría podido abordar.

Las tres "V" del Big Data

Volumen

La cantidad de datos importa. Con big data, tendrá que procesar grandes volúmenes de datos no estructurados de baja densidad. Pueden ser datos de valor desconocido, como feeds de datos de X (anteriormente Twitter), flujos de clics en una página web o una aplicación móvil, o equipos habilitados con sensores. Para algunas organizaciones, esto podría ser decenas de terabytes de datos. Para otras, puede ser cientos de petabytes.

Velocidad

La velocidad es la velocidad a la que se reciben los datos y (quizás) se actúa sobre ellos. Normalmente, la velocidad más alta de los flujos de datos se dirige directamente a la memoria en lugar de escribirse en el disco. Algunos productos inteligentes habilitados para Internet funcionan en tiempo real o casi en tiempo real y requerirán una evaluación y una acción en tiempo real.

Variedad

La variedad se refiere a los muchos tipos de datos que están disponibles. Los tipos de datos tradicionales estaban estructurados y encajaban perfectamente en una base de datos relacional . Con el auge del big data, los datos vienen en nuevos tipos de datos no estructurados. Los tipos de datos no estructurados y semiestructurados, como texto, audio y video, requieren un preprocesamiento adicional para derivar el significado y respaldar los metadatos.

El valor (y la verdad) del Big Data

En los últimos años han surgido dos V más: valor y veracidad . Los datos tienen un valor intrínseco, pero no sirven de nada hasta que se descubre ese valor. Igualmente importante: ¿cuán veraces son sus datos y en qué medida puede confiar en ellos?

Hoy en día, el big data se ha convertido en capital. Pensemos en algunas de las empresas tecnológicas más grandes del mundo. Gran parte del valor que ofrecen proviene de sus datos, que analizan constantemente para producir más eficiencia y desarrollar nuevos productos.

Los recientes avances tecnológicos han reducido exponencialmente el costo de almacenamiento y procesamiento de datos, lo que hace que sea más fácil y menos costoso almacenar más datos que nunca. Con un mayor volumen de big data, ahora más barato y más accesible, puede tomar decisiones comerciales más precisas y exactas.

Encontrar valor en los macrodatos no consiste únicamente en analizarlos (lo cual es otro beneficio muy importante). Es un proceso de descubrimiento completo que requiere analistas, usuarios comerciales y ejecutivos perspicaces que hagan las preguntas correctas, reconozcan patrones, hagan suposiciones fundamentadas y predigan comportamientos.

¿Pero cómo llegamos hasta aquí?

La historia del Big Data

Aunque el concepto de big data en sí es relativamente nuevo, los orígenes de los grandes conjuntos de datos se remontan a las décadas de 1960 y 1970, cuando el mundo de los datos recién comenzaba con los primeros centros de datos y el desarrollo de la base de datos relacional.

Alrededor de 2005, la gente empezó a darse cuenta de la cantidad de datos que generaban los usuarios a través de Facebook, YouTube y otros servicios en línea. Ese mismo año se desarrolló Hadoop (un marco de código abierto creado específicamente para almacenar y analizar grandes conjuntos de datos). NoSQL también empezó a ganar popularidad durante esa época.

El desarrollo de marcos de código abierto, como Hadoop (y más recientemente, Spark), fue esencial para el crecimiento del big data porque permite trabajar con él con mayor facilidad y abaratar su almacenamiento. En los años transcurridos desde entonces, el volumen de big data se ha disparado. Los usuarios siguen generando enormes cantidades de datos, pero no son solo los humanos quienes lo hacen.

Con la llegada de la Internet de las cosas (IoT), cada vez hay más objetos y dispositivos conectados a Internet, lo que permite recopilar datos sobre los patrones de uso de los clientes y el rendimiento de los productos. La aparición del aprendizaje automático ha generado aún más datos.

Si bien el big data ha avanzado mucho, su utilidad recién está comenzando. La computación en la nube ha ampliado aún más las posibilidades del big data. La nube ofrece una escalabilidad verdaderamente elástica, donde los desarrolladores pueden simplemente crear clústeres ad hoc para probar un subconjunto de datos. Y las bases de datos gráficas también están adquiriendo cada vez más importancia, con su capacidad para mostrar cantidades masivas de datos de una manera que permite realizar análisis rápidos y completos.

Beneficios del Big Data

El big data permite obtener respuestas más completas porque dispones de más información.

Respuestas más completas significan mayor confianza en los datos, lo que implica un enfoque completamente diferente para abordar los problemas.

Casos de uso de Big Data

El big data puede ayudarle a abordar una variedad de actividades comerciales, incluidas la experiencia del cliente y el análisis. A continuación, se indican algunas.

1. Desarrollo de productos

Empresas como Netflix y Procter & Gamble utilizan big data para anticipar la demanda de los clientes. Construyen modelos predictivos para nuevos productos y servicios clasificando los atributos clave de productos o servicios pasados y actuales y modelando la relación entre esos atributos y el éxito comercial de las ofertas. Además, P&G utiliza datos y análisis de grupos de discusión, redes sociales, mercados de prueba y lanzamientos iniciales de tiendas para planificar, producir y lanzar nuevos productos.

2. Mantenimiento predictivo

Los factores que pueden predecir fallas mecánicas pueden estar profundamente ocultos en datos estructurados, como el año, la marca y el modelo del equipo, así como en datos no estructurados que abarcan millones de entradas de registro, datos de sensores, mensajes de error y temperatura del motor. Al analizar estas indicaciones de problemas potenciales antes de que ocurran, las organizaciones pueden implementar el mantenimiento de manera más rentable y maximizar el tiempo de funcionamiento de las piezas y el equipo.

3. Experiencia del cliente

La carrera por los clientes ha comenzado. Ahora es más posible que nunca tener una visión más clara de la experiencia del cliente. El big data le permite recopilar datos de las redes sociales, las visitas a la web, los registros de llamadas y otras fuentes para mejorar la experiencia de interacción y maximizar el valor entregado. Comience a ofrecer ofertas personalizadas, reduzca la pérdida de clientes y gestione los problemas de forma proactiva.

4. Fraude y cumplimiento normativo

En materia de seguridad, no se trata solo de unos pocos piratas informáticos maliciosos: se enfrenta a equipos enteros de expertos. Los entornos de seguridad y los requisitos de cumplimiento normativo evolucionan constantemente. Los macrodatos le ayudan a identificar patrones en los datos que indican fraude y a agrupar grandes volúmenes de información para que la elaboración de informes normativos sea mucho más rápida.

5. Aprendizaje automático

El aprendizaje automático es un tema de actualidad y los datos (en concreto, los macrodatos) son una de las razones. Ahora podemos enseñar a las máquinas en lugar de programarlas. La disponibilidad de macrodatos para entrenar modelos de aprendizaje automático lo hace posible.

6. Eficiencia operativa

La eficiencia operativa no siempre es noticia, pero es un área en la que el big data está teniendo el mayor impacto. Con el big data, se pueden analizar y evaluar la producción, los comentarios y las devoluciones de los clientes, y otros factores para reducir las interrupciones y anticipar las demandas futuras. El big data también se puede utilizar para mejorar la toma de decisiones en línea con la demanda actual del mercado.

7. Impulse la innovación

El big data puede ayudarle a innovar estudiando las interdependencias entre seres humanos, instituciones, entidades y procesos, y luego determinando nuevas formas de utilizar esos conocimientos. Utilice los conocimientos de los datos para mejorar las decisiones sobre cuestiones financieras y de planificación. Examine las tendencias y lo que los clientes desean para ofrecer nuevos productos y servicios. Implemente precios dinámicos. Hay infinitas posibilidades.

Desafíos del Big Data

Si bien el big data es muy prometedor, no está exento de desafíos.

En primer lugar, el big data es… grande. Aunque se han desarrollado nuevas tecnologías para el almacenamiento de datos, los volúmenes de datos se duplican cada dos años aproximadamente. Las organizaciones aún tienen dificultades para seguir el ritmo de sus datos y encontrar formas de almacenarlos de manera eficaz.

Pero no basta con almacenar los datos. Los datos deben utilizarse para que sean valiosos y eso depende de su conservación. Los datos limpios, o los datos que son relevantes para el cliente y están organizados de una manera que permite un análisis significativo, requieren mucho trabajo. Los científicos de datos dedican entre el 50 y el 80 por ciento de su tiempo a conservar y preparar los datos antes de que puedan usarse realmente.

Por último, la tecnología de big data está cambiando a un ritmo rápido. Hace unos años, Apache Hadoop era la tecnología más utilizada para gestionar big data. Luego, en 2014, se introdujo Apache Spark. Hoy, una combinación de los dos marcos parece ser el mejor enfoque. Mantenerse al día con la tecnología de big data es un desafío constante.

Cómo funciona el Big Data

El big data le brinda nuevos conocimientos que abren nuevas oportunidades y modelos de negocios. Para comenzar, se requieren tres acciones clave:

1. Integrar

Los macrodatos reúnen datos de muchas fuentes y aplicaciones dispares. Los mecanismos de integración de datos tradicionales, como la extracción, transformación y carga (ETL), generalmente no están a la altura de esta tarea. Se requieren nuevas estrategias y tecnologías para analizar grandes conjuntos de datos a escala de terabytes o incluso petabytes.

Durante la integración, es necesario incorporar los datos, procesarlos y asegurarse de que estén formateados y disponibles en un formato que los analistas de negocios puedan comenzar a utilizar.

2. Gestionar

Big Data requiere almacenamiento. Su solución de almacenamiento puede estar en la nube, en las instalaciones o en ambas. Puede almacenar sus datos en cualquier formato que desee y aplicar los requisitos de procesamiento deseados y los motores de proceso necesarios a esos conjuntos de datos según la demanda. Muchas personas eligen su solución de almacenamiento según dónde se encuentran actualmente sus datos. La nube está ganando popularidad gradualmente porque respalda sus requisitos de computación actuales y le permite aumentar los recursos según sea necesario.

3. Analice

Su inversión en big data se amortiza cuando analiza y actúa sobre sus datos. Obtenga una nueva claridad con un análisis visual de sus diversos conjuntos de datos. Explore los datos más a fondo para hacer nuevos descubrimientos. Comparta sus hallazgos con otros. Cree modelos de datos con aprendizaje automático e inteligencia artificial. Ponga sus datos a trabajar.

Mejores prácticas de Big Data

Para ayudarlo en su recorrido hacia el big data, hemos reunido algunas prácticas recomendadas clave que debe tener en cuenta. Estas son nuestras pautas para construir una base de big data exitosa.

1. Alinee el big data con objetivos comerciales específicos

Los conjuntos de datos más amplios le permiten hacer nuevos descubrimientos. Para ello, es importante basar las nuevas inversiones en habilidades, organización o infraestructura con un contexto empresarial sólido para garantizar inversiones y financiación de proyectos en curso. Para determinar si está en el camino correcto, pregunte cómo el big data respalda y habilita sus principales prioridades comerciales y de TI. Algunos ejemplos incluyen comprender cómo filtrar registros web para comprender el comportamiento del comercio electrónico, derivar el sentimiento de las redes sociales y las interacciones de atención al cliente, y comprender los métodos de correlación estadística y su relevancia para los datos de clientes, productos, fabricación e ingeniería.

2. Alivie la escasez de habilidades con estándares y gobernanza

Uno de los mayores obstáculos para beneficiarse de su inversión en big data es la escasez de habilidades. Puede mitigar este riesgo asegurándose de que las tecnologías, consideraciones y decisiones de big data se incorporen a su programa de gobernanza de TI. Estandarizar su enfoque le permitirá administrar los costos y aprovechar los recursos. Las organizaciones que implementan soluciones y estrategias de big data deben evaluar sus requisitos de habilidades de manera temprana y frecuente y deben identificar de manera proactiva cualquier posible brecha de habilidades. Estas pueden abordarse mediante la capacitación o capacitación cruzada de los recursos existentes, la contratación de nuevos recursos y el aprovechamiento de firmas de consultoría.

3. Optimice la transferencia de conocimientos con un centro de excelencia

Utilice un enfoque de centro de excelencia para compartir conocimientos, controlar la supervisión y gestionar las comunicaciones de los proyectos. Ya sea que el big data sea una inversión nueva o en expansión, los costos indirectos y directos se pueden compartir en toda la empresa. Aprovechar este enfoque puede ayudar a aumentar las capacidades de big data y la madurez general de la arquitectura de la información de una manera más estructurada y sistemática.

4. La mayor recompensa es alinear los datos estructurados con los no estructurados

. Sin duda, es valioso analizar los macrodatos por sí solos, pero se pueden obtener conocimientos empresariales aún mayores conectando e integrando los macrodatos de baja densidad con los datos estructurados que ya se utilizan en la actualidad.

Ya sea que esté recopilando datos masivos de clientes, productos, equipos o del entorno, el objetivo es agregar puntos de datos más relevantes a sus resúmenes analíticos y maestros principales, lo que conduce a mejores conclusiones. Por ejemplo, existe una diferencia entre distinguir el sentimiento de todos los clientes y el de solo los mejores clientes. Por eso, muchos ven el big data como una extensión integral de sus capacidades de inteligencia empresarial, plataforma de almacenamiento de datos y arquitectura de la información existentes.

Tenga en cuenta que los procesos y modelos analíticos de big data pueden estar basados tanto en humanos como en máquinas. Las capacidades analíticas de big data incluyen estadísticas, análisis espacial, semántica, descubrimiento interactivo y visualización. Con los modelos analíticos, puede correlacionar diferentes tipos y fuentes de datos para hacer asociaciones y descubrimientos significativos.

5. Planifique su laboratorio de descubrimiento para obtener mejores resultados

Descubrir el significado de sus datos no siempre es sencillo. A veces ni siquiera sabemos qué estamos buscando. Eso es lo esperado. La gerencia y el departamento de TI deben respaldar esta "falta de dirección" o "falta de requisitos claros".

Al mismo tiempo, es importante que los analistas y científicos de datos trabajen en estrecha colaboración con la empresa para comprender las brechas y los requisitos clave de conocimiento empresarial. Para dar cabida a la exploración interactiva de datos y la experimentación de algoritmos estadísticos, se necesitan áreas de trabajo de alto rendimiento. Asegúrese de que los entornos sandbox tengan el soporte que necesitan y estén correctamente gobernados.

6. Alinearse con el modelo operativo de la nube

Los procesos y usuarios de big data requieren acceso a una amplia gama de recursos, tanto para la experimentación iterativa como para la ejecución de trabajos de producción. Una solución de big data incluye todos los ámbitos de datos, incluidas las transacciones, los datos maestros, los datos de referencia y los datos resumidos. Se deben crear entornos de pruebas analíticos según la demanda. La gestión de recursos es fundamental para garantizar el control de todo el flujo de datos, incluido el preprocesamiento y el posprocesamiento, la integración, el resumen en la base de datos y el modelado analítico. Una estrategia de seguridad y aprovisionamiento de nubes públicas y privadas bien planificada desempeña un papel fundamental a la hora de respaldar estos requisitos cambiantes.

La historia del Big Data

Importancia de los marcos de código abierto en el crecimiento del big data

Hadoop y Spark permiten trabajar con big data de manera más fácil y económica

Años 2005-2006

Desarrollo de Hadoop y NoSQL para almacenar y analizar grandes conjuntos de datos

Generación masiva de datos por parte de los usuarios de servicios en línea

Orígenes de los grandes conjuntos de datos en las décadas de 1960 y 1970

Desarrollo de centros de datos y bases de datos relacionales

El valor (y la verdad) del Big Data

Big data como capital

Avances tecnológicos han reducido el costo de almacenamiento y procesamiento de datos

Empresas tecnológicas obtienen valor de sus datos para producir más eficiencia y desarrollar nuevos productos

Valor y veracidad

Importancia de la veracidad de los datos y la confianza en ellos

Los datos tienen valor intrínseco

pero deben descubrirse

Las tres 'V' del Big Data

Variedad

Datos no estructurados y semiestructurados requieren preprocesamiento adicional

Los datos vienen en nuevos tipos de datos no estructurados

Velocidad

Productos inteligentes habilitados para Internet funcionan en tiempo real o casi en tiempo real

Recepción y acción en tiempo real de los flujos de datos

Volumen

Pueden ser datos de valor desconocido de diversas fuentes

Procesamiento de grandes volúmenes de datos no estructurados de baja densidad

Los volúmenes masivos de datos se pueden utilizar para abordar problemas comerciales que antes no se podían abordar

Los macrodatos son conjuntos de datos más grandes y complejos

especialmente de nuevas fuentes de datos

Los datos contienen una mayor variedad y llegan en volúmenes cada vez mayores y con mayor velocidad