da איתי איילון manca 1 anno

238

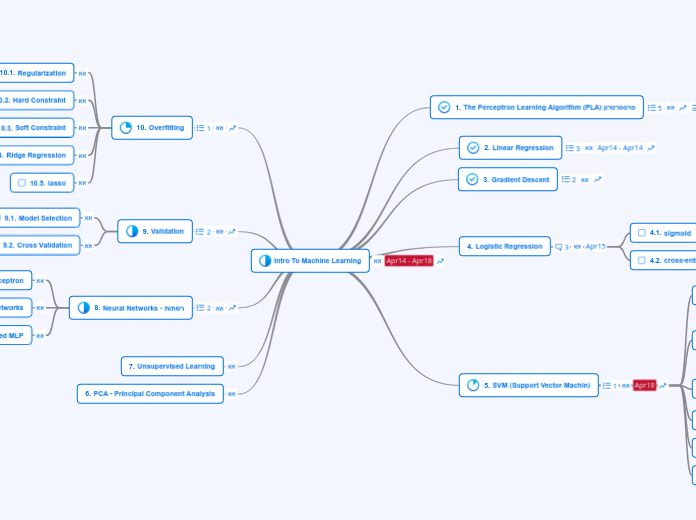

Intro To Machine Learning

The provided content covers a variety of topics in machine learning, starting with foundational concepts such as support vector machines (SVMs) and their implementation in both hard and soft margin cases.