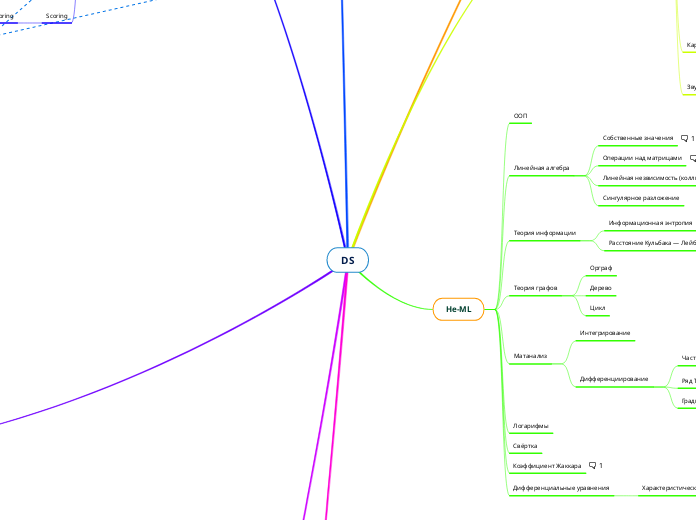

DS

Инструменты

GraphML

PROPHET

Deep

PyTorch

Tensorflow

Keras

Matplotlib

Seaborn

Scipy

Numpy

Pandas

Dask

SQL

Regexp

Метрики

Метрики временных рядов

Geometric Mean Relative Absolute Error

Symmetric Mean Absolute Percentage Error

MRR

MAP

DCG

NDCG

Plots

Weibull Plot

https://towardsdatascience.com/survival-analysis-in-python-a-quick-guide-to-the-weibull-analysis-5babd4f137f6

Q-Q plot

Regression

Residual sum of squares

RSS=SSR=SSE

Classification

Cross-entropy

Accuracy

F-score

Presision

Recall

ROC AUC

Статистика

Основы

Максимальное правдоподобие

Distribution shift(Data shift)

https://arxiv.org/pdf/2105.14119.pdf

Bootstrap

Метод Монте-Карло

Теорема Байеса

Априорное и апостериорное распределение

Корреляция

Partial correlation

Копула

https://habr.com/ru/post/145751/

Distance Correlation

https://www.freecodecamp.org/news/how-machines-make-predictions-finding-correlations-in-complex-data-dfd9f0d87889/

Спирмена (ранговая)

Пирсона

Ковариация

Каузальность

Поиск минимума функции

Triplet loss

Backpropagation

Градиентный спуск

Momentum

Conjugate gradient

BFGS

Стохастический градиентный спуск

Градиент на каждом шаге считается по одному, случайно выбранному элементу

Cross validation

Learning Curve

Распределения

Chi-Square Distribution

распределение со степенью свободы n - сумма квадратов n нормальных распределений

X3 = N1^2+N2^2+N3^2

При большом числе ступеней свободы

X(n)=N(n,2n), (стд=корень из 2n)

F-Distribution

Лапласа

Weibull

https://www.weibull.com/basics/lifedata.htm

Бернулли

Биномиальное

Пуассона

количество редких событий в одном испытании, например ,сколько голов футболист забьёт за матч (часто 0). Если события частые - переходит в нормальное.

Гамма

Время которое нужно подождать чтобы произошло n пуассоновских событий

Экспоненциальное

Промежутки между событиями, распределёнными по-пуассоновски

Нормальное

Стьюдента

Логнормальное

Статтесты

Portmanteau test

Все коэффициенты авторегрессии равны нулю

Ljung–Box Q test,

https://en.wikipedia.org/wiki/Ljung%E2%80%93Box_test

U-критерий Манна-Уитни

Проверяет гипотезу "шансы что случайный элемент из Х больше чем случайный элемент из У такие же как и наоборот"

ANOVA

Есть ли разница между выборками (много классов)

тест Фишера(F-test)

Анализ таблиц сопряжённости для выборок малого размера (менее 10 исходов на ячейку)

Пирсона(хи-квадрат)

Сравнение реального количества исходов определённого варианта и ожидаемого

p-values

https://www.kdnuggets.com/2021/10/calculate-confidence-intervals-performance-metrics-machine-learning.html

Two-Sample z-test

Одинаковы ли средние выборок

T-тест

для маленьких выборок

Z-тест

среднее значение равно H0, односторонняя или двусторонняя

Только для нормально распределённых даных

Задачи

Scoring

Credit scoring

Merton Model

https://www.investopedia.com/terms/m/mertonmodel.asp

Поиск каузальности

Average treatment effect

https://en.wikipedia.org/wiki/Average_treatment_effect

NLP

speech-to-text

Part of Speech Tagging

Transfer learning

Retention Analysis

https://towardsdatascience.com/retention-analysis-framework-4eb62933e2b

RARRR

Retention, Activation, Referral, Revenue, Acquisition

AARRR

Acquisition, Activation, Retention, Revenue, and Referral

Survival Analysis

https://analyticsindiamag.com/a-tutorial-on-survival-analysis-for-beginners/

Similarity learning

https://arxiv.org/pdf/1812.05944.pdf

Оптимизация

Ant colony optimization

Particle swarm optimization

Minimax

Тестирование гипотез

https://arxiv.org/pdf/2002.09465.pdf

Классификация

Multiclass Classification

Sequence Classification

https://direct.mit.edu/tacl/article/doi/10.1162/tacl_a_00403/106992/Sensitivity-as-a-Complexity-Measure-for-Sequence

Time series prediction

Option price

Black-Scholes Model

A/B testing

Не-ML

Дифференциальные уравнения

Характеристическое уравнение

https://en.wikipedia.org/wiki/Characteristic_equation_(calculus)

Коэффициент Жаккара

Мера схожести множеств

Свёртка

Логарифмы

Матанализ

Дифференциирование

Градиент

Ряд Тейлора

Частная производная

Седловая точка

Интегрирование

Теория графов

Цикл

Дерево

Орграф

Теория информации

Расстояние Кульбака — Лейблера

"Расстояние" между двумя распределениями

Информационная энтропия

Линейная алгебра

Сингулярное разложение

Линейная незвисимость (коллинеарность)

Операции над матрицами

сложение матриц

умножение матриц

транспонирование

обратная матрица

единичная матрица

Собственные значения

Ax=lx

x - власний вектор

l - власне значення

ООП

Данные

Звук

Картинки

Hough Transform

SIFT

Edge detection

Текст

Topic model

Bag-of-words

N-граммы

Эмбеддинг

Word2vec

GLOVE

TF-IDF

Лемматизация

Стемминг

Табличные данные

Авторегрессия

AR(n)

Xt = N(m,sigma) + O1*Xt-1 + O2* Xt-2 +...

Yule Walker Equations

http://www-stat.wharton.upenn.edu/~steele/Courses/956/ResourceDetails/YWSourceFiles/YW-Eshel.pdf

Позволяет вычислить автокорреляционную функцию из коэфициентов авторегрессии

AR MA duality

Stationarity

https://stats.stackexchange.com/questions/118019/a-proof-for-the-stationarity-of-an-ar2

Тест Дики-Фуллера

Проверка на единичные корни

Moving Average process

Xt = m + Wt + O1Wt-1 + O2Wt-2 +...

Wt = N(0,sigma)

https://online.stat.psu.edu/stat510/lesson/2/2.1

Invertibility

https://stats.stackexchange.com/questions/333802/why-do-we-care-if-an-ma-process-is-invertible

Random walk

Weiner process

Interest rate models

Subtopic

Vasicek model

https://www.investopedia.com/terms/v/vasicek-model.asp

Cox–Ingersoll–Ross model

https://www.investopedia.com/terms/c/cox-ingersoll-ross-model.asp

Ornstein–Uhlenbeck process

Случайное блуждание с трением

Эргодичность

Преобразование Фурье

Вейвлет-преобразование

Подготовка данных

Синтетические/аугментированные данные

weak labelling

https://habr.com/ru/post/597387/

http://ai.stanford.edu/blog/weak-supervision/

Нормализация

стандартизация

Encoding

one-hot

Missing data

https://bmcmedresmethodol.biomedcentral.com/articles/10.1186/s12874-018-0615-6

worst observation carried forward

last observation carried forward

simple mean

Single imputation

Multiple imputation

https://www.bmj.com/content/338/bmj.b2393

https://towardsdatascience.com/a-better-way-to-handle-missing-values-in-your-dataset-using-iterativeimputer-9e6e84857d98

Feature selection

Прямой и обратный выбор подмножества

Linear Discriminant Analysis

Random forest importance measure

LIME

https://cran.r-project.org/web/packages/lime/vignettes/Understanding_lime.html

https://www.oreilly.com/content/introduction-to-local-interpretable-model-agnostic-explanations-lime/

https://arxiv.org/pdf/1602.04938.pdf

https://github.com/marcotcr/lime

SHAP

https://towardsdatascience.com/shap-for-feature-selection-and-hyperparameter-tuning-a330ec0ea104

Дубликаты

Несбалансированные выборки

https://machinelearningmastery.com/undersampling-algorithms-for-imbalanced-classification/

Condensed Nearest Neighbor Rule

Class weights

Tomek Links

SMOTE

undersampling/oversampling

Уменьшение размерности

Linear discriminant analysis

Multidimensional scaling,

Principal Coordinates Analysis (PCoA), Torgerson Scaling or Torgerson–Gower scaling

https://medium.datadriveninvestor.com/the-multidimensional-scaling-mds-algorithm-for-dimensionality-reduction-9211f7fa5345

UMAP

PCA

Kaiser Rule

Elbow method

Feature-engineering

Выбросы

Isolation Forest

Для многомерных данных

Z-score

Модели

Loss function

Focal Loss

https://paperswithcode.com/method/focal-loss

gamma відповідає за вклад простих прикладів (ваша модель дає імовірність близьку до 1 при навчанні), alpha це щоб градіенти погані не були дуже

Pipeline

OLAP and OLTP

ETL & ELT

https://biconsult.ru/services/etl-i-elt-5-osnovnyh-otlichiy

Типы обучения

Semi-Supervised Learning

https://lilianweng.github.io/lil-log/2021/12/05/semi-supervised-learning.html

Reinforcement learning

Q-Learning

Ассамбли

Stacking

Беггинг

Бустинг

Нейронные сети

Zero-shot

Слои

GLU (Gated linear unit)

https://arxiv.org/pdf/1612.08083v3.pdf

Pulling

Full-connected

Convolution

Dropout

Архитектуры

Рекомендательные системы

AdaRank

LambdaRank

https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/tr-2008-179.pdf

Graph Neural Network

RNN

GAN

LSTM

Механизм

Gradient Checking

Random Initialization

Функция активации

Non-linear

Unbounded

Continuously differentiable

Swish

x * sigmoid(x)

GeLU

Gaussian Error Linear Unit

Exponential Linear Unit

Tahn

Softmax

ReLU

PReLU

y = x, if x > 0

y = a * x, if x <= 0 (a < 1)

Leaky ReLU

Fine-tuning

Выбор числа параметров

Bayesian information criterion(BIC)

Akaike information criterion(AIC)

Регуляризация

https://towardsdatascience.com/ridge-and-lasso-regression-a-complete-guide-with-python-scikit-learn-e20e34bcbf0b

- The L1 regularization solution is sparse. The L2 regularization solution is non-sparse.

- L2 regularization doesn’t perform feature selection, since weights are only reduced to values near 0 instead of 0. L1 regularization has built-in feature selection.

- L1 regularization is robust to outliers, L2 regularization is not.

https://neptune.ai/blog/fighting-overfitting-with-l1-or-l2-regularization

L1 когда много фич

L2 когда фичи сильно скоррелированы

Elastic-Net (a*L1 + (1-a) * L2)

Lasso(L2)

Ridge(L1)

Bias-Variance Tradeoff

Pruning

Early stopping

Classical

Manifold Learning

https://jakevdp.github.io/PythonDataScienceHandbook/05.10-manifold-learning.html

Рекомендационные системы

Content based

Collaborative filtering

Anomaly detection

Локальный уровень выброса

https://ru.wikipedia.org/wiki/Локальный_уровень_выброса

Регрессия

Метод частичных наименьших квадратов(Partial List-Square)

https://en.wikipedia.org/wiki/Partial_least_squares_regression

Последовательная ортогонализация (Forward-Stepwise regression)

Least Angle Regression

Логистическая регрессия

Сигмоида

Logit-функция

Логрегрессия

Frisch–Waugh–Lovell theorem

https://towardsdatascience.com/controlling-for-x-9cb51652f7ad

позволяет визуализировать зависимость целевой переменной от фичи, с учётом влияния других фич

Residual Plots

гетероскедастичность,

Text

Latent Dirichlet Allocation

https://towardsdatascience.com/do-you-want-to-cluster-unlabeled-text-data-try-out-topic-modeling-235795ae7cb7

Временные ряды

Simple Exponential Smoothing

Holt-Winters exponential smoothing

Dynamic time warping

Фильтр Калмана

https://habr.com/ru/post/594249/

ARMA

ARIMA

SARIMA

GARCH

Multi-armed bandits

Кластеризация

Hierarchical clustering

По плотности

OPTICS

DBSCAN

Выбор количества кластеров

Gap statistics

Elbow

Silhouette

T-SNE

K-means

K-medoids

Центром кластера всегда будет точка их данных

SVM

Теорема Мерсера

www.machinelearning.ru/wiki/index.php?title=Теорема_Мерсера

определяет условия, при выполнении которых функция может быть ядром

KNN

Проклятие размерности

Цепи Маркова

Desigion tree

Random forest

CatBoost

LightGBM

XGBoost