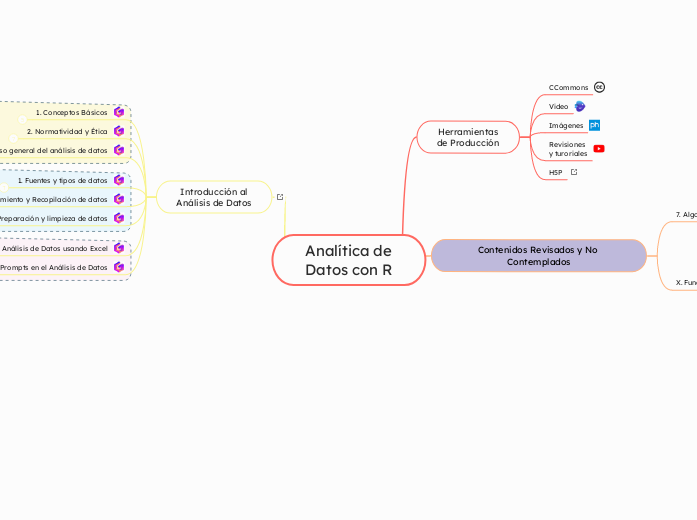

Analítica de

Datos con R

Introducción al

Análisis de Datos

2. Uso Básico de Prompts en el Análisis de Datos

Actividades Prácticas Sugeridas:

Actividades Prácticas Sugeridas:

Los prompts de IA están transformando la forma en que interactuamos con los datos. Al dominar las técnicas de ingeniería de prompts, los analistas de datos pueden aprovechar el poder de los modelos de lenguaje para obtener insights más profundos y tomar decisiones más informadas.

Al realizar estas actividades, los estudiantes podrán desarrollar habilidades prácticas en el uso de prompts de IA y comprender mejor su potencial en el análisis de datos.

- Experimentar con diferentes prompts en una plataforma como ChatGPT para ver cómo afectan los resultados.

- Crear un prompt para generar un resumen de un artículo científico.

- Utilizar un prompt para generar código Python para realizar una tarea de análisis de datos.

- Diseñar un prompt para identificar sesgos en un conjunto de datos.

8. El Futuro de los Prompts en el Análisis de Datos

Automatización de tareas: Los prompts pueden automatizar muchas tareas repetitivas en el análisis de datos.

Colaboración humano-máquina: Los analistas de datos pueden trabajar junto con los modelos de lenguaje para obtener mejores resultados.

Democratización de la IA: Los prompts hacen que la IA sea más accesible para personas sin conocimientos técnicos profundos.

7. Desafíos y Consideraciones

Sesgos: Los modelos de lenguaje pueden reflejar los sesgos presentes en los datos de entrenamiento.

Hallucinaciones: Los modelos pueden generar información falsa o engañosa.

Interpretabilidad: Puede ser difícil entender cómo el modelo llega a una conclusión.

6. Herramientas y Plataformas

Modelos de lenguaje grandes: GPT-3, Jurassic-1 Jumbo, LaMDA.

Plataformas de IA conversacional: ChatGPT, Bard.

Notebooks: Jupyter Notebook, Google Colab.

5. Aplicaciones de los Prompts en el Análisis

- Exploración de datos:

- Resumir grandes conjuntos de datos.

- Identificar patrones y tendencias.

- Generar hipótesis.

- Limpieza y preparación de datos:

- Identificar y corregir errores en los datos.

- Transformar datos en formatos adecuados para el análisis.

- Modelado y predicción:

- Generar código para construir modelos de machine learning.

- Interpretar los resultados de los modelos.

- Visualización de datos:

- Generar descripciones de visualizaciones.

- Crear código para visualizar datos.

4. Técnicas de Ingeniería de Prompts

- Prompt engineering: El arte de diseñar prompts para obtener los mejores resultados de un modelo de lenguaje.

- Técnicas:

- Reformulación: Replantear el prompt de diferentes maneras para obtener diversas respuestas.

- Aumento de contexto: Agregar más información al prompt para mejorar la calidad de la respuesta.

- Cadena de pensamiento: Guiar al modelo a través de una secuencia de pasos para resolver un problema.

- Few-shot learning: Proporcionar al modelo algunos ejemplos antes de hacerle una pregunta.

3. Componentes de un Prompt Efectivo

Claridad y concisión: El prompt debe ser claro y conciso para evitar ambigüedades.

Contexto: Proporcionar contexto relevante al modelo ayuda a generar respuestas más precisas.

Instrucciones específicas: Indicar claramente qué se espera del modelo.

Ejemplos: Incluir ejemplos puede ayudar al modelo a comprender mejor la tarea.

2. ¿Qué es un Prompt?

Definición: Un prompt es una secuencia de texto que sirve como entrada para un modelo de lenguaje.

Función: Los prompts guían al modelo hacia la generación de un texto específico, ya sea una respuesta a una pregunta, una traducción, una creación de contenido o una tarea más compleja.

1. Introducción a los Prompts de IA en el Análisis

Introducción a los Prompts de IA en el Análisis de Datos

Los prompts de IA son instrucciones o preguntas específicas que se le proporcionan a un modelo de lenguaje para obtener una respuesta o realizar una tarea determinada. En el contexto del análisis de datos, los prompts se utilizan para interactuar con modelos de lenguaje grandes (LLMs) y obtener insights valiosos a partir de grandes volúmenes de información. Esta unidad explorará los fundamentos del uso de prompts de IA en el análisis de datos.

1. Fundamentos de Análisis de Datos usando Excel

Actividades prácticas sugeridas

- Crear una hoja de cálculo con datos de ventas y realizar un análisis básico para identificar los productos más vendidos, los clientes más importantes y las tendencias de ventas.

- Utilizar una tabla dinámica para analizar los datos de un censo poblacional y obtener información sobre la distribución por edad, género y nivel educativo.

- Crear un gráfico que visualice la relación entre dos variables numéricas.

- Realizar un análisis de correlación para determinar si existe una relación entre dos variables.

Al realizar estas actividades, los estudiantes consolidarán sus conocimientos y adquirirán habilidades prácticas en el análisis de datos utilizando Excel.

9. Conclusión

Excel es una herramienta versátil y accesible para realizar análisis de datos básicos. Sin embargo, es importante comprender sus limitaciones y considerar otras herramientas más especializadas cuando sea necesario. Al dominar los fundamentos del análisis de datos en Excel, se adquiere una base sólida para abordar problemas más complejos y explorar otras herramientas de análisis.

Nota: Esta unidad de contenido puede ampliarse incluyendo temas como:

- Análisis de series de tiempo: Analizar datos que se recolectan a intervalos regulares de tiempo.

- Minería de datos: Descubrir patrones y relaciones ocultas en grandes conjuntos de datos.

- Inteligencia de negocios: Utilizar los resultados del análisis para tomar decisiones informadas.

8. Limitaciones de Excel para el Análisis de Datos

Tamaño de los datos: Excel puede tener limitaciones en el manejo de grandes conjuntos de datos.

Complejidad de los análisis: Para análisis más complejos, herramientas especializadas como R o Python pueden ser más adecuadas.

7. Análisis de Datos Avanzados con Excel

Análisis de hipótesis: Utilizar herramientas como "Análisis de datos" para realizar pruebas t, ANOVA y otras pruebas estadísticas.

Regresión lineal: Modelar la relación entre variables numéricas.

6. Visualización de Datos en Excel

Gráficos: Crear diversos tipos de gráficos (barras, líneas, circulares, dispersión) para visualizar los datos.

Formatos condicionales: Aplicar formatos a las celdas en función de criterios específicos para resaltar patrones y tendencias.

5. Tablas Dinámicas: Una Potente Herramienta

- Creación de tablas dinámicas: Convertir rangos de datos en tablas dinámicas para resumir y analizar datos de forma interactiva.

- Campos de fila, columna y valores: Configurar la tabla dinámica para mostrar los datos de la forma deseada.

- Filtros y segmentación de datos: Analizar los datos desde diferentes perspectivas utilizando filtros y segmentación.

- Cálculos personalizados: Crear cálculos personalizados para obtener información más detallada.

4. Funciones Esenciales en Excel para el Análisis

- Funciones estadísticas:

- MEDIANTA: Calcula el promedio de un rango de celdas.

- MEDIANA: Encuentra el valor central de un conjunto de datos.

- MODA: Identifica el valor que aparece con mayor frecuencia.

- DESVEST: Calcula la desviación estándar de un conjunto de datos.

- VAR: Calcula la varianza de un conjunto de datos.

- Funciones lógicas:

- SI: Realiza una prueba lógica y devuelve un valor si la condición es VERDADERO, y otro si es FALSO.

- Y: Devuelve VERDADERO si todos los argumentos son VERDADERO.

- O: Devuelve VERDADERO si al menos uno de los argumentos es VERDADERO.

- Funciones de búsqueda y referencia:

- BUSCARV: Busca un valor en la primera columna de una tabla y devuelve un valor en la misma fila desde una columna especificada.

- ÍNDICE: Devuelve el valor de una celda en una ubicación especificada por un número de fila y un número de columna.

- COINCIDIR: Devuelve la posición relativa de un elemento en un rango.

3. Preparación de los Datos en Excel

Importación de datos: Aprender a importar datos de diversos formatos (CSV, Excel, bases de datos).

Limpieza de datos: Identificar y corregir errores comunes como valores faltantes, duplicados o inconsistencias.

Transformación de datos: Manipular datos para adecuarlos al análisis (agrupar, filtrar, calcular).

2. Conceptos Básicos de Análisis de Datos

Datos: Información recopilada y organizada para su análisis.

Variable: Característica o atributo que se mide en un conjunto de datos.

Observación: Una instancia individual de un conjunto de datos.

Conjunto de datos: Colección de observaciones relacionadas.

1. Introducción al análisis de datos con Excel

Introducción al Análisis de Datos con Excel

Excel, a pesar de ser una herramienta principalmente diseñada para cálculos y gestión de hojas de cálculo, ofrece un conjunto robusto de herramientas para el análisis de datos. Su interfaz intuitiva y la amplia disponibilidad lo convierten en una opción popular para quienes se inician en el mundo de la analítica.

3. Preparación y limpieza de datos

Evaluaciones

Rúbrica

Test Secuencia

5. Cierre

La preparación y limpieza de datos son pasos esenciales para garantizar la calidad y confiabilidad de los resultados del análisis de datos. Al utilizar las herramientas y técnicas adecuadas en R, los analistas de datos pueden transformar conjuntos de datos sin procesar en datos de alta calidad listos para ser analizados y obtener información valiosa.

5.1 Importancia de la calidad de los datos:

La calidad de los datos es fundamental para la validez y confiabilidad de cualquier análisis. Un conjunto de datos de baja calidad puede conducir a resultados incorrectos o engañosos.

5.2 Consideraciones éticas:

La preparación y limpieza de datos deben realizarse de manera ética, protegiendo la privacidad de los individuos y la confidencialidad de la información.

4. Buenas Prácticas para la Preparación

y Limpieza de Datos

- Documentar el proceso: Registrar las decisiones tomadas durante la preparación y limpieza de datos para facilitar la reproducibilidad y el seguimiento del proceso.

- Validar los datos: Verificar que los datos limpios sean consistentes, precisos y adecuados para el análisis.

- Utilizar herramientas de visualización: Explorar los datos visualmente para identificar posibles problemas y patrones.

- Considerar el contexto del análisis: La preparación y limpieza de datos deben realizarse teniendo en cuenta los objetivos específicos del análisis.

3. Herramientas para la Preparación

y Limpieza de Datos en R

R ofrece una amplia gama de paquetes y funciones para la preparación y limpieza de datos, incluyendo:

- Paquete

dplyr: Un paquete versátil para manipular y transformar datos de manera eficiente. - Paquete

tidyverse: Una colección de paquetes que integran herramientas para la limpieza, análisis y visualización de datos. - Paquete

data.table: Un paquete rápido y eficiente para trabajar con grandes conjuntos de datos. - Función

is.na(): Detecta valores ausentes (NA) en un vector de datos. - **Función

na.omit(): Elimina filas o columnas con valores ausentes. - **Función

impute(): Imputa valores ausentes con valores medios, medianas o utilizando métodos más sofisticados. - **Función

transform(): Transforma variables dentro de un conjunto de datos. - **Función

unique(): Identifica y elimina valores duplicados en un vector de datos.

2. Importancia de la Preparación

y Limpieza de Datos

Los datos sin procesar a menudo contienen errores, valores ausentes, inconsistencias y formatos inconsistentes que pueden afectar la calidad del análisis. La preparación y limpieza de datos implica:

- Identificar y corregir errores: Detectar y corregir errores de tipeo, entrada de datos incorrecta o valores inconsistentes.

- Manejar valores ausentes: Tratar los valores ausentes de manera adecuada, ya sea eliminándolos, imputándolos o utilizando técnicas específicas para manejarlos.

- Transformar datos: Transformar los datos a un formato adecuado para el análisis, como convertir fechas, escalar variables o normalizar datos.

- Detectar y eliminar duplicados: Identificar y eliminar registros duplicados que puedan sesgar los resultados del análisis.

- Estandarizar formatos: Estandarizar los formatos de fecha, hora, unidades de medida y otros aspectos para garantizar la coherencia en los datos.

1. Introducción a la Preparación

y Limpieza de Datos

La preparación y limpieza de datos son pasos cruciales en cualquier proyecto de análisis de datos. Un conjunto de datos de alta calidad es esencial para obtener resultados confiables y precisos en el análisis. R ofrece diversas herramientas y técnicas para preparar y limpiar datos de manera efectiva.

2. Almacenamiento y Recopilación de datos

Guía de Observación

6. Consideraciones

El almacenamiento y la recopilación de datos son aspectos fundamentales para un análisis de datos efectivo. La elección del método de almacenamiento adecuado y la implementación de buenas prácticas para la recopilación de datos garantizan la calidad, integridad y seguridad de los datos, lo que permite obtener resultados confiables y útiles para la toma de decisiones.

6.1 Consideraciones éticas:

Es importante considerar las implicaciones éticas de la recopilación de datos, como la privacidad, el consentimiento y la protección de datos personales.

6.2 Integración de datos:

En muchos casos, los datos se recopilan de diversas fuentes y deben integrarse en un formato único para su análisis. La integración de datos implica combinar, fusionar y transformar los datos para crear un conjunto de datos coherente. Este proceso puede ser complejo y requiere herramientas y técnicas especializadas, como:

- Herramientas ETL (Extracción, Transformación y Carga): automatizan el proceso de extracción de datos de diferentes fuentes, transformación de los datos según sea necesario y carga de los datos en un destino final.

- Mapas de datos: representan las relaciones entre diferentes fuentes de datos y definen cómo se deben combinar y transformar los datos.

- Herramientas de calidad de datos: identifican y corrigen errores, valores ausentes o inconsistencias en los datos.

6.3 Almacenamiento en la nube

El almacenamiento en la nube ofrece una solución flexible y escalable para almacenar grandes volúmenes de datos. Los servicios de almacenamiento en la nube como Amazon S3, Microsoft Azure Blob Storage o Google Cloud Storage permiten:

- Acceso remoto: Acceder a los datos desde cualquier lugar con conexión a internet.

- Escalabilidad: Escalar la capacidad de almacenamiento de forma elástica según las necesidades.

- Colaboración: Compartir datos con otros usuarios o equipos de forma segura.

- Análisis de datos: Realizar análisis de datos directamente en la nube utilizando herramientas y servicios integrados.

6.4 Consideraciones de seguridad

La seguridad de los datos es un aspecto crucial en el almacenamiento y la recopilación de datos. Es importante implementar medidas de seguridad para proteger los datos contra el acceso no autorizado, el uso indebido y la divulgación. Algunas medidas de seguridad recomendadas incluyen:

- Control de acceso: Limitar el acceso a los datos a usuarios autorizados mediante autenticación y autorización.

- Cifrado: Cifrar los datos en reposo y en tránsito para protegerlos contra accesos no autorizados.

- Copias de seguridad: Realizar copias de seguridad regulares de los datos para garantizar su recuperación en caso de pérdida o daño.

- Monitoreo y auditoría: Monitorear el acceso a los datos y las actividades de los usuarios para detectar anomalías o posibles amenazas.

5. Buenas prácticas para la recopilación de datos

Planificación: Definir claramente los objetivos de la recopilación de datos, las variables de interés y las fuentes de datos.

Consentimiento: Obtener el consentimiento informado de los individuos cuando sea necesario.

Precisión: Asegurar la precisión y confiabilidad de los datos recopilados.

Completitud: Minimizar los valores ausentes o inconsistentes en los datos.

Seguridad: Proteger los datos confidenciales y sensibles contra el acceso no autorizado.

Estandarización: Implementar estándares para el formato y la organización de los datos.

Documentación: Documentar el proceso de recopilación de datos y las fuentes de datos utilizadas.

4. Herramientas para la captura de datos

4.1 Web scraping:

- Extraer datos de sitios web utilizando herramientas como Scrapy, Beautiful Soup o Octoparse.

4.2 APIs:

- Acceder a datos de aplicaciones web y servicios en línea mediante APIs como las de redes sociales, plataformas de comercio electrónico o servicios financieros.

4.3 Encuestas:

- Recopilar datos de individuos o grupos mediante encuestas online o en papel utilizando herramientas como SurveyMonkey, Google Forms o LimeSurvey.

4.4 Entrevistas:

- Obtener información en profundidad de individuos mediante entrevistas estructuradas o no estructuradas.

4.5 Experimentos:

- Recopilar datos bajo condiciones controladas utilizando herramientas de experimentación como LabVIEW o jsPsych.

4.6 Sensores:

- Recopilar datos de dispositivos físicos como sensores de temperatura, presión o movimiento utilizando plataformas como Arduino o Raspberry Pi.

3. Factores a considerar para la selección

del método de almacenamiento

Volumen de datos: La cantidad de datos a almacenar determinará la capacidad y el rendimiento requeridos del sistema de almacenamiento.

Estructura de datos: La estructura de los datos (estructurados, no estructurados, semiestructurados) influirá en la elección del método de almacenamiento adecuado.

Patrones de acceso: Los patrones de acceso a los datos (consultas analíticas complejas, acceso en tiempo real, análisis exploratorio) determinarán el rendimiento y la funcionalidad requerida del sistema de almacenamiento.

Costo: El costo de las licencias, el hardware y el mantenimiento de los diferentes métodos de almacenamiento debe ser considerado.

2. Métodos de almacenamiento de datos

2.1 Bases de datos relacionales:

- Almacenan datos estructurados en tablas con relaciones definidas entre ellas.

- Adecuadas para grandes volúmenes de datos transaccionales y análisis estructurados.

- Ejemplos: MySQL, PostgreSQL, Oracle.

2.2 Almacenes de datos:

- Diseñados para almacenar grandes volúmenes de datos históricos y agregados para su análisis.

- Optimizados para consultas analíticas complejas y visualización de datos.

- Ejemplos: Amazon Redshift, Microsoft Azure Synapse Analytics, Google BigQuery.

2.3 Data lakes:

- Almacenan datos sin procesar en su formato nativo, independientemente de su estructura o formato.

- Permiten un análisis flexible y exploratorio de diversos tipos de datos.

- Ejemplos: Amazon S3, Microsoft Azure Data Lake Storage, Google Cloud Storage.

2.4 NoSQL:

- Almacenan datos no estructurados o semiestructurados en formatos flexibles, como documentos, JSON o gráficos.

- Adecuados para datos que no encajan bien en el modelo relacional tradicional.

- Ejemplos: MongoDB, Cassandra, CouchDB.

1. Introducción al almacenamiento

y recopilación de datos

El almacenamiento y la recopilación de datos son etapas cruciales en el proceso de análisis de datos. La elección del método de almacenamiento adecuado depende del volumen, la estructura y el uso previsto de los datos. La recopilación de datos implica la extracción de datos de diversas fuentes y su organización para su análisis.

1. Fuentes y tipos de datos

Listas de Cotejo

6. Cierre

La selección adecuada de fuentes y tipos de datos es fundamental para el éxito de cualquier proyecto de análisis de datos. Al considerar la relevancia, precisión, completitud, actualidad, legalidad y ética de los datos, los analistas de datos pueden garantizar la calidad de sus análisis y obtener resultados confiables y útiles.

6.1 Importancia de la limpieza de datos:

Independientemente de la fuente, los datos a menudo contienen errores, valores ausentes o inconsistencias. La limpieza de datos es un paso crucial para preparar los datos para el análisis y garantizar su calidad.

6.2 Integración de datos:

En muchos casos, los datos se recopilan de diversas fuentes y deben integrarse en un formato único para su análisis. La integración de datos implica combinar, fusionar y transformar los datos para crear un conjunto de datos coherente.

5. Herramientas para la recopilación de datos

Web scraping: para extraer datos de sitios web.

APIs: para acceder a datos de aplicaciones web y servicios en línea.

Encuestas: para recopilar datos de individuos o grupos.

Entrevistas: para obtener información en profundidad de individuos.

Experimentos: para recopilar datos bajo condiciones controladas.

Sensores: para recopilar datos de dispositivos físicos.

4. Consideraciones para la selección

de fuentes y tipos de datos

Relevancia: Los datos deben ser relevantes para los objetivos del análisis y responder a las preguntas de investigación.

Precisión: Los datos deben ser precisos y confiables para garantizar la calidad de los resultados del análisis.

Completitud: Los datos deben estar completos y no contener valores ausentes o inconsistencias.

Actualidad: Los datos deben estar actualizados y reflejar la situación actual.

Legalidad y ética: Se deben considerar las leyes y regulaciones relacionadas con la recopilación y uso de datos, así como los principios éticos de la investigación.

3. Tipos de datos

3.1 Datos cuantitativos:

- Se pueden medir en números y representar valores numéricos.

- Ejemplos: edad, ingresos, temperatura, ventas, calificaciones.

3.2 Datos cualitativos:

- No se pueden medir en números y representan características o atributos no numéricos.

- Ejemplos: opiniones, preferencias, emociones, comentarios, categorías.

3.3 Datos estructurados:

- Están organizados en un formato definido, como tablas de bases de datos o archivos CSV.

- Fáciles de almacenar, procesar y analizar con herramientas informáticas.

3.4 Datos no estructurados:

- No tienen un formato definido y pueden incluir texto libre, imágenes, audio o video.

- Requiere técnicas de procesamiento de lenguaje natural, análisis de imágenes o análisis de audio/video para su análisis.

2. Tipos de fuentes de datos

2.1 Fuentes de datos internas:

- Bases de datos: almacenan datos estructurados y organizados, como transacciones de ventas, registros de clientes o datos financieros.

- Sistemas transaccionales: registran actividades y eventos en tiempo real, como sistemas de punto de venta o registros de acceso a redes.

- Datos de sensores: recopilan datos de dispositivos físicos, como sensores de temperatura, presión o movimiento.

2.2 Fuentes de datos externas:

- Datos web: se pueden extraer de sitios web, redes sociales y otras plataformas online.

- Datos públicos: están disponibles gratuitamente en portales gubernamentales, organizaciones internacionales o repositorios de datos abiertos.

- Datos de terceros: se pueden comprar a proveedores de datos especializados o a través de plataformas de intercambio de datos.

1. Introducción a las fuentes y tipos de datos

El análisis de datos comienza con la recopilación de datos de diversas fuentes. La elección de la fuente de datos correcta es crucial para garantizar la calidad, confiabilidad y relevancia de los datos para los objetivos del análisis.

3. Proceso general del análisis de datos

Flashcards y Cuestionarios

4. Cierre

El proceso de análisis de datos con R proporciona una metodología sistemática para transformar datos sin procesar en información útil y significativa. Al seguir las buenas prácticas y utilizar las herramientas adecuadas, los analistas de datos pueden obtener conocimientos valiosos de los datos y contribuir a la toma de decisiones informadas en diversos campos.

4.1 Importancia de la comunicación:

La comunicación efectiva de los resultados del análisis de datos es crucial para garantizar que sean utilizados por las partes interesadas y para generar un impacto positivo.

4.2 Aprendizaje continuo:

El campo del análisis de datos está en constante evolución, por lo que es importante que los analistas de datos se mantengan actualizados sobre las últimas técnicas y herramientas.

3. Buenas prácticas para el análisis de datos con R

Documentar el proceso de análisis: Es importante documentar cada paso del proceso de análisis de datos, incluyendo la fuente de datos, la metodología utilizada y los resultados obtenidos.

Reproducibilidad: El análisis de datos debe ser reproducible, lo que significa que otros investigadores deberían poder obtener los mismos resultados utilizando el mismo código y datos.

Validación de modelos: Los modelos de análisis de datos deben validarse cuidadosamente antes de utilizarse para tomar decisiones.

Interpretabilidad de los modelos: Es importante comprender cómo funcionan los modelos de análisis de datos para poder interpretar sus resultados y confiar en sus predicciones.

2. Herramientas para el análisis de datos con R

R es un lenguaje de programación y entorno de software ampliamente utilizado para el análisis de datos. Ofrece una amplia gama de herramientas y paquetes especializados para cada etapa del proceso de análisis de datos, incluyendo:

- Recolección de datos: paquetes para leer datos de diversas fuentes, como bases de datos, archivos CSV y APIs.

- Limpieza y preparación de datos: paquetes para identificar y corregir errores, valores ausentes y inconsistencias en los datos.

- Exploración y análisis descriptivo: paquetes para crear visualizaciones de datos, calcular estadísticas descriptivas y resumir los datos.

- Modelado y análisis predictivo: paquetes para desarrollar y ajustar modelos estadísticos y de aprendizaje automático, como modelos de regresión, clasificación y series temporales.

- Comunicación y presentación de resultados: paquetes para crear visualizaciones de datos de alta calidad, generar informes y presentaciones.

1. Introducción al proceso de análisis de datos

El análisis de datos implica un proceso sistemático para transformar datos sin procesar en información útil y significativa. Este proceso generalmente se divide en las siguientes etapas:

1.1 Definición de objetivos y preguntas:

- Es crucial establecer claramente los objetivos del análisis de datos y las preguntas que se buscan responder.

- Los objetivos y las preguntas deben ser específicos, medibles, alcanzables, relevantes y con un plazo determinado (SMART).

1.2 Recolección de datos:

- Los datos se pueden recopilar de diversas fuentes, como bases de datos, encuestas, experimentos, sensores y redes sociales.

- Es importante garantizar que los datos sean precisos, completos, confiables y relevantes para los objetivos del análisis.

1.3 Limpieza y preparación de datos:

- Los datos sin procesar a menudo contienen errores, valores ausentes o inconsistencias.

- La limpieza de datos implica identificar y corregir estos problemas para garantizar la calidad de los datos.

1.4 Exploración y análisis descriptivo:

- Esta etapa consiste en explorar los datos para comprender su distribución, tendencias, patrones y relaciones.

- Se utilizan técnicas estadísticas y visualizaciones de datos para resumir y describir los datos.

1.5 Modelado y análisis predictivo:

- Se desarrollan modelos estadísticos o de aprendizaje automático para predecir resultados o tendencias futuras.

- Los modelos se evalúan en función de su precisión y capacidad para generalizar a nuevos datos.

1.6 Comunicación y presentación de resultados:

- Los hallazgos del análisis de datos se comunican de manera efectiva a las partes interesadas, utilizando visualizaciones, informes y presentaciones claras y concisas.

- Es importante comunicar los resultados de manera que sean relevantes para la audiencia y que respalden la toma de decisiones informadas.

2. Normatividad y Ética

Rúbrica de Sustentación y Cuestionarios

6. Conclusión

El análisis de datos es una herramienta poderosa que puede generar beneficios significativos para la sociedad. Sin embargo, es crucial utilizarla de manera responsable y ética, respetando los derechos individuales y la privacidad. La normatividad y la ética brindan un marco para el manejo responsable de los datos en el análisis de datos con R, asegurando que esta herramienta se utilice para el bien y no para el daño.

5. Recursos para el manejo ético de

datos en el análisis de datos con R

5.1 Importancia de la colaboración:

Es importante que los profesionales de datos, los desarrolladores de software, los responsables políticos y el público en general colaboren para desarrollar e implementar prácticas de análisis de datos éticas y responsables.

5.2 El futuro del análisis de datos:

A medida que la tecnología de análisis de datos continúa evolucionando, es fundamental que los principios éticos y legales se mantengan a la vanguardia. Es necesario un compromiso continuo para garantizar que el análisis de datos se utilice de manera responsable y beneficiosa para todos.

Al seguir las buenas prácticas descritas en este documento, los profesionales de análisis de datos pueden contribuir a un futuro en el que el análisis de datos se utilice para generar conocimientos valiosos, mejorar la toma de decisiones y crear un mundo más justo y equitativo.

5.3 Algunos enlaces de referencias de normatividad:

Comisión Nacional de Protección de Datos Personales de Colombia: https://www.minambiente.gov.co/politica-de-proteccion-de-datos-personales/

Reglamento General de Protección de Datos (RGPD): https://gdpr-info.eu/

Red Española de Protección de Datos: https://www.aepd.es/

AAI Guide on AI Ethics: https://aaai.org/about-aaai/ethics-and-diversity/

4. Buenas prácticas para el manejo ético

de datos en el análisis de datos con R

4.1 Obtención del consentimiento informado:

- Obtener el consentimiento libre e informado de los individuos antes de recopilar sus datos personales.

- Informar a los individuos sobre cómo se utilizarán sus datos, quién tendrá acceso a ellos y sus derechos con respecto a sus datos.

4.2 Minimización de datos:

- Recopilar solo la cantidad mínima de datos necesaria para el propósito específico del análisis.

- Evitar la recopilación de datos innecesarios o sensibles.

4.3 Seguridad de los datos:

- Implementar medidas de seguridad adecuadas para proteger los datos contra el acceso no autorizado, el uso indebido y la divulgación.

- Usar técnicas de cifrado y control de acceso para proteger los datos confidenciales.

4.4 Documentación y auditoría:

- Documentar las prácticas de manejo de datos,

4.5 Evaluación de impacto:

- Evaluar el impacto potencial del análisis de datos en la privacidad, la seguridad y otros derechos individuales.

- Tomar medidas para mitigar los riesgos potenciales.

4.6 Uso responsable de la inteligencia artificial:

- Al utilizar técnicas de inteligencia artificial en el análisis de datos, considerar los principios éticos y las directrices relevantes.

- Evitar el uso de la inteligencia artificial para fines discriminatorios o dañinos.

4.7 Capacitación y sensibilización:

- Capacitar a los profesionales de análisis de datos sobre los principios éticos y legales del manejo de datos.

- Sensibilizar a los usuarios sobre los riesgos y beneficios del análisis de datos.

3. Consideraciones éticas en el desarrollo

de modelos de análisis de datos

3.1 Sesgo y discriminación:

- Los modelos de análisis de datos pueden reflejar y amplificar los sesgos existentes en los datos utilizados para entrenarlos.

- Es crucial evaluar y mitigar los sesgos en los modelos para evitar la discriminación algorítmica.

3.2 Transparencia e interpretabilidad:

- Los modelos de análisis de datos, especialmente los modelos de aprendizaje automático complejos, pueden ser difíciles de interpretar.

- Es importante desarrollar modelos transparentes y explicables para que los usuarios comprendan cómo funcionan y puedan tomar decisiones informadas.

3.3 Equidad y justicia:

- Los modelos de análisis de datos deben utilizarse de manera equitativa y justa para todos los individuos.

- Es necesario evitar el uso de modelos que puedan exacerbar las desigualdades sociales o discriminar a grupos específicos.

2. Normatividad relevante para el análisis de datos

2.1 Leyes de protección de datos:

- Reglamento General de Protección de Datos (RGPD) de la Unión Europea: establece un marco legal para la protección de datos personales en la Unión Europea.

- Ley de Protección de Datos Personales de Colombia: regula la recolección, tratamiento y circulación de datos personales en Colombia.

- Ley Sarbanes-Oxley de Estados Unidos: establece requisitos para el control interno y la presentación de informes financieros, incluyendo la protección de datos.

2.2 Otras regulaciones relevantes:

- Leyes de privacidad de la información: protegen la información personal en diversos sectores, como la atención médica y los servicios financieros.

- Leyes de propiedad intelectual: protegen los derechos de autor y otros derechos de propiedad intelectual sobre los datos.

- Leyes de competencia: prohíben prácticas anticompetitivas, como el uso indebido de datos para obtener una ventaja injusta.

1. Introducción a la normatividad y

ética en el análisis de datos

1.1 ¿Por qué son importantes la normatividad y la ética en el análisis de datos?

El análisis de datos implica la recopilación, el almacenamiento y el uso de información personal y confidencial. Es crucial garantizar que estos datos se manejen de manera responsable y ética, respetando los derechos individuales y la privacidad. La normatividad y la ética brindan un marco para el manejo responsable de los datos, asegurando:

- Protección de la privacidad: los individuos tienen derecho a controlar cómo se recopilan, utilizan y divulgan sus datos personales.

- Prevención de daños: el uso indebido de los datos puede causar daños a las personas, como discriminación, fraude o robo de identidad.

- Equidad y justicia: los algoritmos y modelos de análisis de datos deben ser justos y no discriminatorios.

- Transparencia: las personas deben tener derecho a saber cómo se utilizan sus datos y quién tiene acceso a ellos.

1.2 Principios éticos clave en el análisis de datos:

- Responsabilidad: las organizaciones que recopilan y utilizan datos son responsables de su manejo ético.

- Transparencia: las personas deben tener información clara y accesible sobre cómo se recopilan, utilizan y divulgan sus datos.

- Propósito y limitación: los datos deben recopilarse y utilizarse solo para los propósitos específicos y claramente definidos.

- Precisión y calidad: los datos deben ser precisos, completos y actualizados.

- Seguridad: los datos deben protegerse contra el acceso no autorizado, el uso indebido y la divulgación.

- No discriminación: los datos no deben utilizarse para discriminar a individuos o grupos.

- Rendición de cuentas: las organizaciones deben ser responsables de sus prácticas de manejo de datos.

Para Consulta (Superintendencia de Industria y Comercio SIC)

-Documento Autorización Tratamiento de Datos Personales

.-Política de tratamiento de Datos Personales

-Política de seguridad de la Informacon

1. Conceptos Básicos

Quiz

Conclusión

En resumen, el análisis de datos es una herramienta poderosa que nos permite transformar datos sin procesar en información valiosa para tomar decisiones informadas y mejorar diversos aspectos del mundo real. R es un lenguaje de programación y entorno de software ampliamente utilizado para el análisis de datos, debido a su flexibilidad, potencia y amplia gama de paquetes especializados.

3. Relación del análisis de datos con el mundo real

El análisis de datos tiene un impacto significativo en diversos aspectos del mundo real, incluyendo:

- Negocios: las empresas utilizan el análisis de datos para mejorar sus operaciones, tomar decisiones estratégicas, aumentar las ventas y optimizar sus campañas de marketing.

- Finanzas: las instituciones financieras utilizan el análisis de datos para evaluar riesgos, detectar fraudes, gestionar inversiones y desarrollar nuevos productos financieros.

- Ciencia: los científicos utilizan el análisis de datos para analizar experimentos, identificar patrones en la naturaleza y desarrollar nuevos modelos teóricos.

- Gobierno: los gobiernos utilizan el análisis de datos para comprender mejor a sus ciudadanos, optimizar la prestación de servicios públicos y formular políticas públicas efectivas.

- Salud: los profesionales de la salud utilizan el análisis de datos para diagnosticar enfermedades, predecir resultados de tratamientos y mejorar la calidad de la atención médica.

2. Conceptos básicos del análisis de datos

2.1 Tipos de datos

- Datos cuantitativos: se pueden medir en números, como la edad, el ingreso o la temperatura.

- Datos cualitativos: no se pueden medir en números, como las opiniones, las preferencias o las emociones.

2.2 Variables

- Variables independientes: son las variables que se manipulan o cambian en un experimento.

- Variables dependientes: son las variables que se miden y se ven afectadas por las variables independientes.

2.3 Medidas estadísticas

- Medidas de tendencia central: como la media, la mediana y la moda, que resumen el valor "típico" de una variable.

- Medidas de dispersión: como la varianza y el desvío estándar, que indican la variabilidad de los datos alrededor de la media.

2.4 Asociación y correlación

- Asociación: describe la relación entre dos variables, sin especificar causa y efecto.

- Correlación: mide la fuerza y la dirección de la asociación entre dos variables.

1. Introducción al análisis de datos

1.1 ¿Qué es el análisis de datos?

El análisis de datos es el proceso de extraer información significativa de conjuntos de datos sin procesar. Implica la limpieza, manipulación, exploración, modelado y visualización de datos para descubrir patrones, tendencias y relaciones que puedan ser útiles para la toma de decisiones.

1.2 ¿Por qué es importante el análisis de datos?

El análisis de datos es crucial en el mundo actual, donde la información es abundante y compleja. Nos permite:

- Obtener conocimientos sobre el comportamiento de clientes, mercados, operaciones y otros aspectos del mundo real.

- Tomar decisiones informadas basadas en evidencia, no en intuición o suposiciones.

- Mejorar la eficiencia y la productividad en diversos sectores.

- Identificar nuevas oportunidades de negocio y crecimiento.

- Reducir riesgos y anticipar problemas potenciales.

1.3 Ejemplos de aplicaciones del análisis de datos en el mundo real:

- Análisis de ventas: para comprender las preferencias de los clientes, identificar productos populares y optimizar las estrategias de marketing.

- Análisis financiero: para evaluar riesgos crediticios, detectar fraudes y optimizar las inversiones.

- Análisis de atención médica: para diagnosticar enfermedades, predecir resultados de tratamientos y mejorar la calidad de la atención.

- Análisis de recursos humanos: para identificar empleados con alto potencial, optimizar la capacitación y reducir la rotación de personal.

- Análisis de redes sociales: para comprender el sentimiento del público, identificar tendencias y mejorar la imagen de marca.

Contenidos Revisados y No Contemplados

X. Fundamentos de Lenguaje R

Mapa

5. Conclusión

El lenguaje R ofrece un conjunto poderoso de herramientas y algoritmos para el análisis de datos. Al comprender los fundamentos del lenguaje R y familiarizarse con los diferentes tipos de algoritmos disponibles, los analistas de datos pueden abordar una amplia gama de problemas y obtener información valiosa a partir de los datos.

5.1 Importancia de la práctica:

La práctica regular es fundamental para dominar R y sus algoritmos. Existen numerosos conjuntos de datos y desafíos disponibles en línea para practicar habilidades de análisis de datos con R.

5.2 Aplicaciones del análisis de datos con R:

El análisis de datos con R se utiliza en una amplia gama de campos, incluyendo finanzas, marketing, medicina, ciencias sociales, medio ambiente y muchos más.

4. Recursos para aprender algoritmos y R

Existen numerosos recursos disponibles para aprender algoritmos y R, incluyendo:

- Documentación oficial de R: https://www.r-project.org/other-docs.html

- Libros y tutoriales: Una gran cantidad de libros y tutoriales están disponibles en línea y en bibliotecas, como "The R Language" de Peter Dalgaard o "Hands-On Machine Learning with R" de Aurélien Géron.

- Cursos online: Plataformas como Coursera, edX y Udemy ofrecen cursos online sobre R y análisis de datos.

- Comunidades en línea: Existen comunidades en línea activas, como el subreddit r/Rlanguage o el foro de Stack Overflow para R, donde puedes encontrar ayuda y colaborar con otros usuarios de R.

3. Fundamentos del lenguaje R

Para comprender y utilizar los algoritmos de R de manera efectiva, es esencial tener una base sólida en los fundamentos del lenguaje R. Esto incluye:

- Sintaxis básica: Comprender la estructura y las reglas del lenguaje R, incluyendo la definición de variables, la creación de vectores y matrices, y el uso de operadores y funciones.

- Estructuras de control: Utilizar estructuras de control como

if, else y for para controlar el flujo del programa. - Funciones: Crear y utilizar funciones personalizadas para realizar tareas específicas.

- Manejo de datos: Importar, limpiar, transformar y analizar datos utilizando paquetes de R como

dplyr, tidyverse y data.table. - Visualización de datos: Crear gráficos y visualizaciones de datos atractivas e informativas utilizando paquetes de R como

ggplot2, plotly y lattice.

2. Tipos de algoritmos en R

R ofrece una amplia variedad de algoritmos para diferentes tareas de análisis de datos. Algunos de los tipos de algoritmos más comunes incluyen:

- Algoritmos de regresión: Utilizados para modelar la relación entre una variable dependiente y una o más variables independientes.

- Algoritmos de clasificación: Utilizados para clasificar datos en categorías predefinidas.

- Algoritmos de agrupamiento: Utilizados para agrupar datos en clusters con características similares.

- Algoritmos de reducción de dimensionalidad: Utilizados para reducir la cantidad de variables en un conjunto de datos sin perder información significativa.

- Algoritmos de minería de datos: Utilizados para extraer patrones y conocimientos ocultos de grandes conjuntos de datos.

1. Introducción a los algoritmos y el lenguaje R

El lenguaje R proporciona un entorno poderoso para el análisis de datos, ofreciendo una amplia gama de algoritmos y herramientas para diversas tareas, incluyendo:

- Análisis descriptivo: Resumir y describir las características de los datos.

- Análisis exploratorio de datos (EDA): Explorar y visualizar los datos para identificar patrones, tendencias y anomalías.

- Modelado estadístico: Desarrollar modelos estadísticos para comprender las relaciones entre variables y hacer predicciones.

- Aprendizaje automático: Entrenar modelos de aprendizaje automático para realizar tareas como clasificación, regresión y agrupamiento.

- Visualización de datos: Crear visualizaciones de datos atractivas e informativas para comunicar los resultados del análisis.

7. Algoritmos Básicos con Pseudocódigo (PseInt)

Aplicación

8. Conclusión

PseInt es una herramienta valiosa para aprender a programar y desarrollar algoritmos de manera clara y estructurada. Al comprender los conceptos básicos de tipos de datos, variables, operadores e instrucciones de control de flujo, podemos comenzar a crear algoritmos más complejos y resolver problemas de programación de manera efectiva.

7. Ejemplo de Algoritmo: Calcular

el Promedio de dos Números

Proceso PromedioDosNumeros

Descripción: Calcula el promedio de dos números enteros.

// Declaración de variables

Entero numero1, numero2, promedio;

// Ingreso de datos

Escribir "Ingrese el primer número: ";

Leer numero1;

Escribir "Ingrese el segundo número: ";

Leer numero2;

// Cálculo del promedio

promedio = (numero1 + numero2) / 2;

// Mostrar el resultado

Escribir "El promedio de los números es: ", promedio;

FinProceso

En este ejemplo, el algoritmo solicita al usuario dos números enteros, calcula su promedio y muestra el resultado final.

6. Instrucciones de Control de Flujo en PseInt

Las instrucciones de control de flujo permiten modificar el orden de ejecución de las instrucciones en un algoritmo según ciertas condiciones. Algunas instrucciones comunes incluyen:

- Si (IF): Ejecuta un conjunto de instrucciones si se cumple una condición específica.

- Sino (ELSE): Ejecuta un conjunto de instrucciones alternativo si la condición del

SI no se cumple. - Mientras que (WHILE): Repite un conjunto de instrucciones mientras se cumpla una condición específica.

- Para (FOR): Repite un conjunto de instrucciones un número determinado de veces.

5. Operadores en PseInt

Los operadores permiten realizar operaciones matemáticas, lógicas y de comparación entre datos. Algunos operadores comunes en PseInt incluyen:

- Operadores aritméticos: Suma (+), resta (-), multiplicación (*), división (/), potencia (^).

- Operadores lógicos: AND (&&), OR (||), NOT (!).

- Operadores de comparación: Igual que (==), diferente que (!=), mayor que (>), menor que (<), mayor o igual que (>=), menor o igual que (<=).

4. Variables en PseInt

Las variables son elementos que almacenan datos durante la ejecución de un algoritmo. Para declarar una variable en PseInt se utiliza la siguiente sintaxis:

TipoVariable NombreVariable;

Donde:

TipoVariable indica el tipo de dato que almacenará la variable (Entero, Real, Cadena, Booleano).NombreVariable es el identificador único que se asigna a la variable.

3. Tipos de Datos en PseInt

PseInt maneja diferentes tipos de datos para almacenar información:

- Entero: Números enteros positivos o negativos, como 1, -5, 100.

- Real: Números decimales, como 3.14, -2.5, 10.25.

- Cadena: Secuencias de caracteres, como "Hola", "Mundo", "Programación".

- Booleano: Valores lógicos que pueden ser Verdadero o Falso.

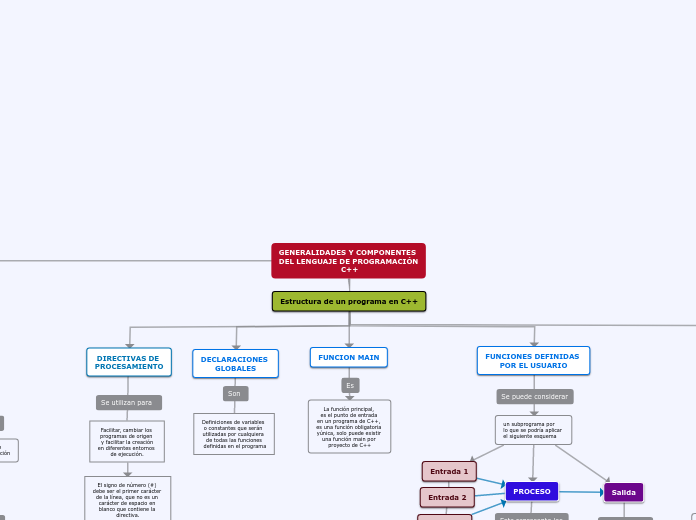

2. Estructura Básica de un Algoritmo en PseInt

Un algoritmo en PseInt se compone de las siguientes partes:

- Proceso: Se inicia con la palabra

Proceso seguida del nombre del algoritmo. - Descripción: Se incluye una breve descripción del propósito del algoritmo.

- Cuerpo del Algoritmo: Aquí se detallan las instrucciones paso a paso que conforman el algoritmo. Cada instrucción termina con punto y coma.

- FinProceso: Se finaliza con la palabra

FinProceso para indicar el término del algoritmo.

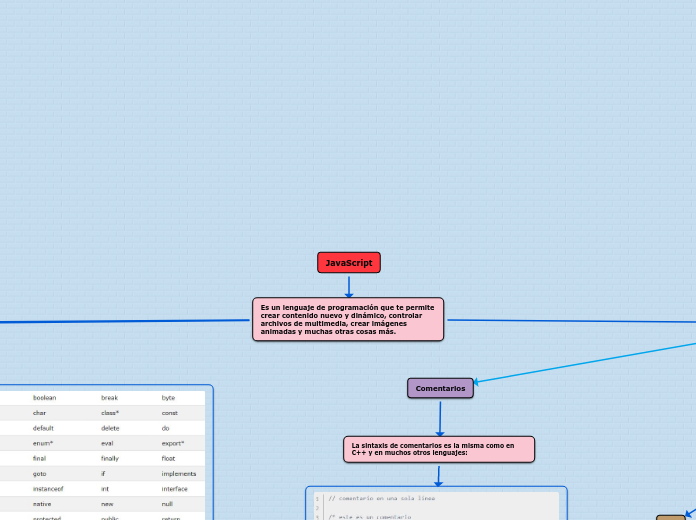

1. Introducción a la Programación

con Algoritmos y PseInt

La programación es la base fundamental para el desarrollo de software y aplicaciones. Implica la creación de instrucciones detalladas que le indican a una computadora cómo realizar una tarea específica. Los algoritmos son la representación paso a paso de un proceso para resolver un problema o lograr un objetivo.

PseInt (Pseudo Algoritmo) es una herramienta de gran utilidad para aprender a programar y desarrollar algoritmos. Permite expresar algoritmos de una manera clara, lógica y estructurada, utilizando un lenguaje similar al español.

En esta unidad de contenido, exploraremos algunos algoritmos básicos en programación utilizando PseInt, sentando las bases para comprender y desarrollar programas más complejos.

Herramientas

de Producción

H5P

Revisiones

y turoriales

Imágenes

Video

CCommons